Maya Research 近期重磅推出 Maya1,一款拥有30亿参数的先进文本转语音模型,为语音合成领域带来了革命性突破。该模型能够将文本内容与简短描述转化为高度可控、富有表现力的语音输出,更令人惊叹的是,它支持在单个GPU上实现实时运行,极大地拓宽了应用场景。

Maya1的核心优势在于其卓越的情感捕捉能力和精准的声音设计能力。通过深度学习算法,模型能够精准解析人类情感的细微变化,并将其转化为相应的语音表现,使得合成语音更加自然生动。无论是需要朗读的文本内容,还是对声音的详细描述,Maya1都能完美结合,生成符合要求的音频效果。

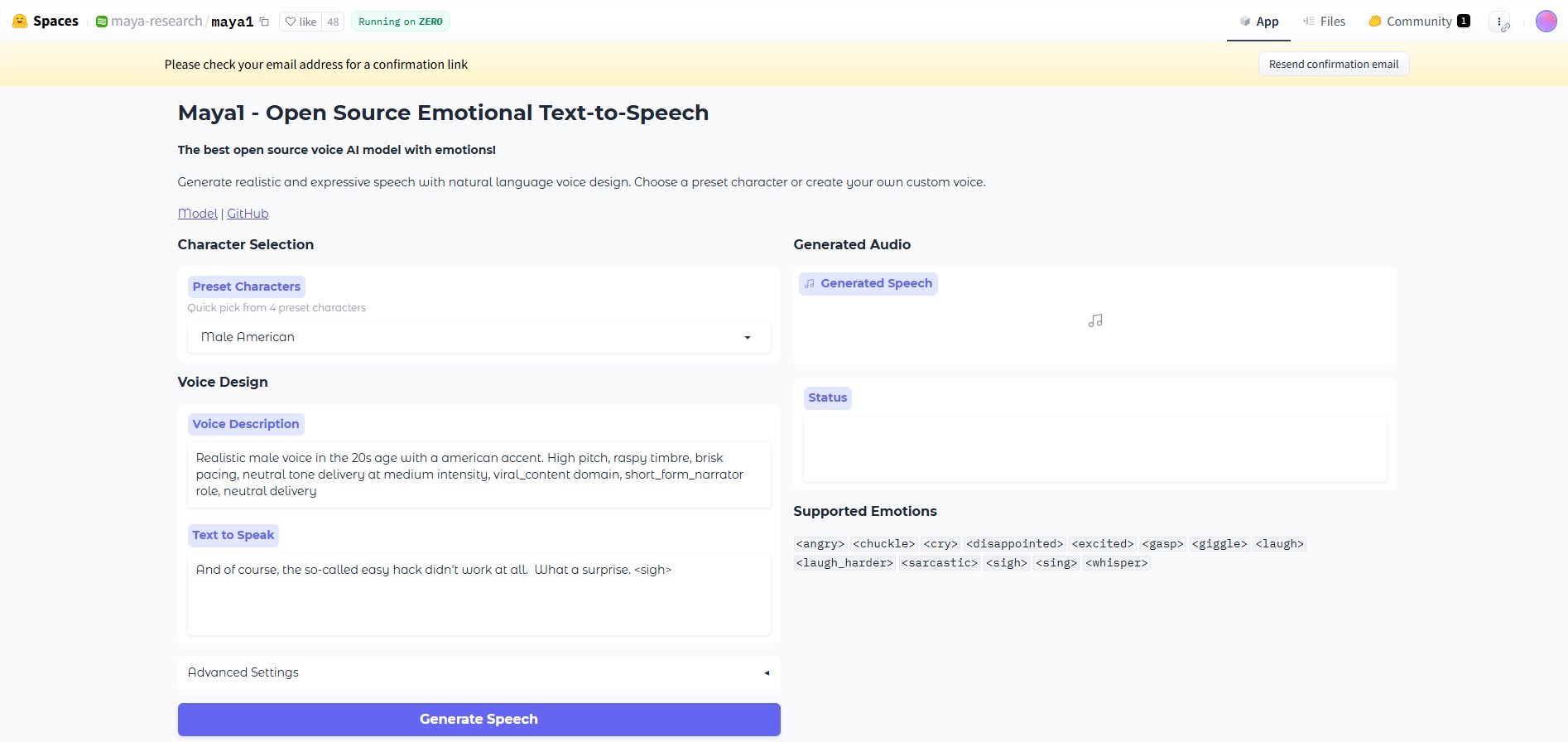

在操作界面方面,Maya1提供了两种输入方式:自然语言语音描述和需要朗读的文本。用户可以根据需求输入描述,例如“20多岁女性,英式口音,充满活力,清晰的发音”,或“恶魔角色,男性声音,低音调,沙哑的音色,慢节奏”。模型会智能分析这些信息,生成与之匹配的音频输出。此外,用户还可以在文本中插入情感标签,如、、等,模型支持超过20种情感表达,让语音合成更加灵活多变。

Maya1输出的音频质量高达24kHz单声道,并支持实时流媒体功能,使其成为助手、互动代理、游戏、播客及直播内容的理想选择。Maya Research 团队自豪地表示,该模型的性能已超越许多顶级的专有系统,同时完全开源,遵循 Apache2.0许可证,为开发者提供了极大的便利。

在技术架构上,Maya1采用解码器仅有的变换器结构,类似于 Llama 模型,不直接预测原始波形,而是通过名为 SNAC 的神经音频编码器进行预测编码。这一创新设计有效提高了生成效率,并便于模型的扩展应用。整个生成流程包括文本处理、编码生成和音频解码,每个环节都经过精心优化,确保输出效果的高质量。

Maya1的训练数据来自互联网规模的英语语音语料库,旨在学习广泛的声学覆盖和自然的连贯性。随后,模型还在一个经过精心挑选的专有数据集上进行了微调,该数据集包含经人类验证的语音描述和多种情感标签,进一步提升了模型的性能表现。

为了在单个GPU上进行推理和部署,Maya1推荐使用16GB及以上的显存卡,例如 A100、H100或 RTX4090,以确保最佳运行效果。此外,Maya Research 团队还提供了一系列工具和脚本,方便用户进行实时音频生成和流媒体支持,进一步降低了使用门槛。

huggingface:https://huggingface.co/spaces/maya-research/maya1

划重点:

🎤 Maya1是一个30亿参数的开源文本转语音模型,能够实时生成富有表现力的音频。

💡 该模型结合自然语言描述和文本输入,支持多种情感标签,提升语音表现力。

🚀 Maya1可在单个 GPU 上运行,并提供多种工具以支持高效的推理和部署。