vLLM团队重磅推出业界首个”全模态”推理框架vLLM-Omni,将文本、图像、音频、视频的统一生成从理论验证阶段成功推向可落地的开源代码。该框架现已全面登陆GitHub与ReadTheDocs平台,开发者可通过pip命令即时安装并开始调用,极大地降低了多模态AI应用的开发门槛。

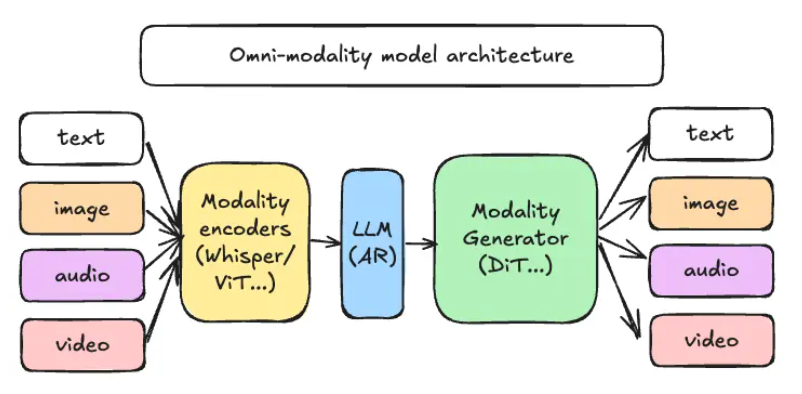

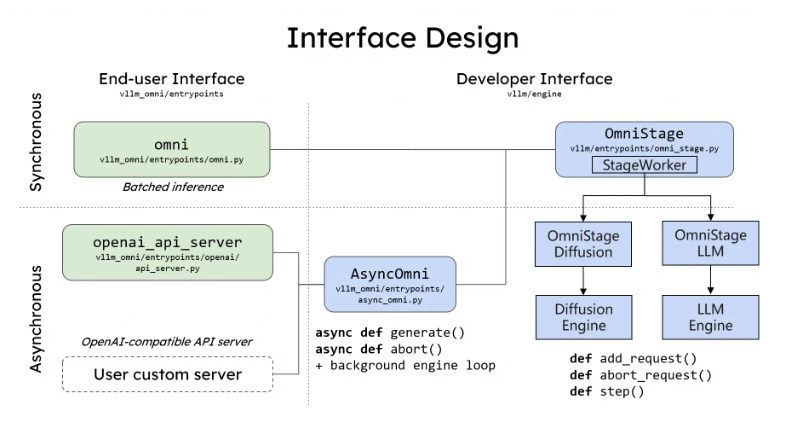

框架采用创新的解耦流水线架构,清晰划分三大核心组件:模态编码器负责将视觉、语音等多源数据转化为中间特征表示,目前支持ViT、Whisper等业界领先模型;LLM核心继续沿用vLLM自回归引擎,专注于高级推理、规划与对话能力;模态生成器则采用DiT、Stable Diffusion等扩散模型解码技术,实现图像、音频、视频的同步生成。这种模块化设计使各组件可独立运行,通过微服务架构在不同GPU或计算节点间灵活调度,资源利用率实现弹性伸缩——在图像生成高峰期可横向扩展DiT算力,在文本推理低谷期自动收缩LLM资源,显存利用率最高提升达40%。

在性能与兼容性方面,vLLM-Omni创新性地提供Python装饰器@omni_pipeline,仅需三行代码即可将原有单模态模型无缝升级为多模态应用。官方基准测试显示,在8×A100高性能集群上部署10亿参数”文本+图像”模型,其吞吐量比传统串行方案提升2.1倍,端到端延迟显著降低35%,充分验证了框架的工程化实力。

开源生态建设方面,GitHub仓库已完整收录各类示例代码与Docker Compose部署脚本,全面支持PyTorch2.4+与CUDA12.2最新版本。团队还透露了清晰的路线图:2026年第一季度将重点加入视频DiT模型与高性能语音Codec,并计划推出Kubernetes自定义资源定义(CRD),为企业用户提供私有云环境的一键部署方案。

业内专家指出,vLLM-Omni通过创新的数据流设计将异构模型统一纳入处理流程,有望显著降低多模态应用的开发成本与部署难度。尽管不同硬件间的负载均衡和缓存一致性仍是需要攻克的工程难题,但随着框架持续完善,AI初创企业将能够以更经济的方式构建”文本-图像-视频”一体化平台,彻底摆脱维护三条独立推理链路的繁琐工作。

项目地址:https://github.com/vllm-project/vllm-omni