Meta 的人工智能研究团队携手新加坡国立大学,共同研发出一种名为“自我对弈环境中的自我提升”(SPICE)的创新强化学习框架。该框架的核心机制在于通过两个 AI 代理之间的相互对抗,在零人类干预的环境下实现自我驱动的能力提升。尽管目前仍处于概念验证阶段,但 SPICE 框架预示着未来 AI 系统将具备动态适应复杂环境的能力,显著增强其在现实世界中的鲁棒性。

自我提升型 AI 的根本目标是通过与环境互动实现自我进化。传统方法往往依赖人工设计的问题集和奖励机制,这种模式在扩展性上存在明显瓶颈。而 SPICE 框架开创性地采用自我对弈机制,让 AI 模型在竞争对抗中实现能力跃升。然而,现有自我对弈方法在语言模型应用中面临两大挑战:一是问题与答案中的事实错误会相互叠加,产生“幻觉”现象;二是当问题生成者与解答者共享相同知识库时,难以生成创新性挑战,容易陷入重复循环。

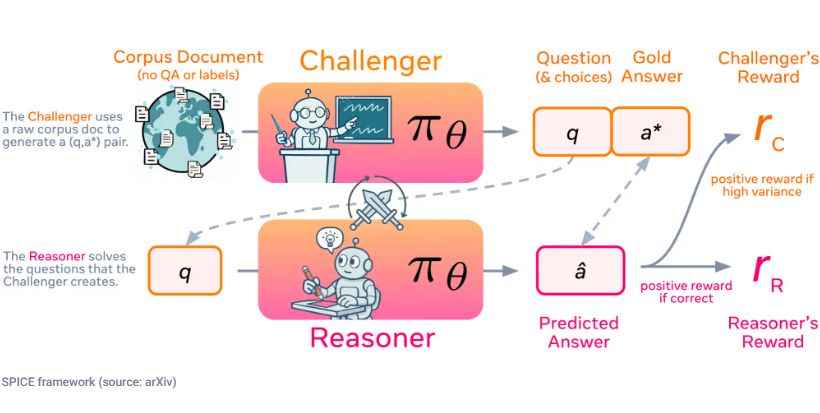

SPICE 框架通过引入角色分离机制巧妙解决了上述难题。其中一个模型扮演“挑战者”角色,从海量文档中构建高难度问题;另一个模型则作为“推理者”,在无法访问源文档的情况下尝试解答。这种信息不对称的设计有效避免了知识泄露,显著降低了错误率。框架内置的对抗性动态形成了一套自动化的进阶课程:挑战者通过生成恰好位于推理者能力边界的难题获得奖励,而推理者则通过正确解答问题获得正向反馈。这种互惠机制推动两个角色协同进化,持续发现并攻克新挑战。

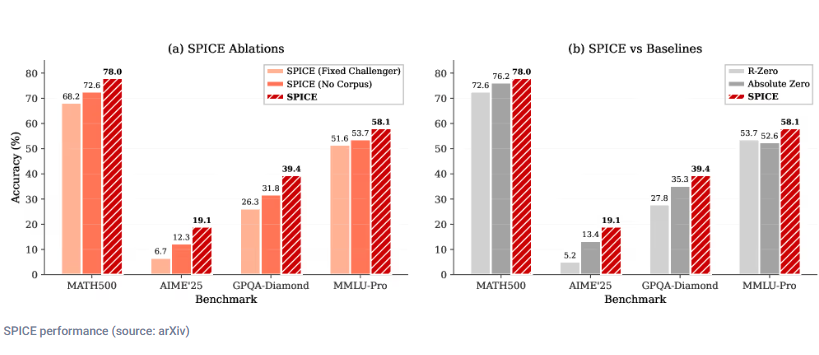

更值得关注的是,SPICE 框架摆脱了对预定义问题-答案对的依赖,直接基于原始文档生成多样化任务,打破了传统方法在特定领域的局限。研究人员对多个基础模型进行的评估显示,SPICE 在数学和一般推理任务中的表现显著优于其他基线模型。这一成果有力证明,基于语料库的自我对弈所培养的推理能力能够有效迁移至不同模型,为自我提升推理方法开启了全新篇章。

论文链接:https://arxiv.org/abs/2510.24684

✅ SPICE 框架通过自我对弈机制,实现 AI 系统无监督环境下的推理能力持续提升

✅ 创新的挑战者-推理者角色设计打破信息对称,有效遏制错误累积

✅ 多模型测试结果验证 SPICE 框架的广泛适用性和卓越性能