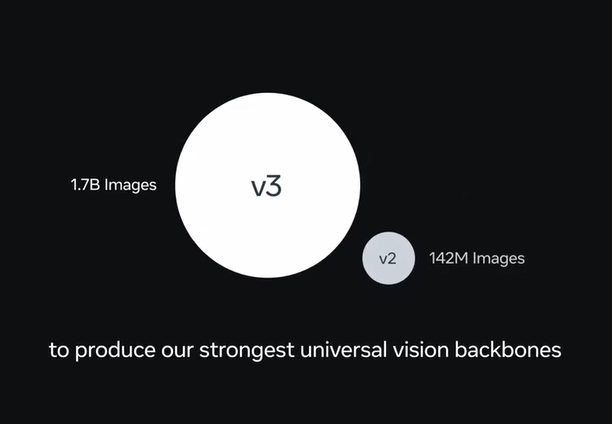

Meta AI 近期正式发布了全新一代通用图像识别模型 DINOv3,这一突破性成果迅速吸引了全球开发者和研究人员的目光。作为基于自监督学习的计算机视觉模型,DINOv3 以其无需人工标注即可实现卓越性能的特质,被广泛视为 AI 视觉技术发展的新里程碑。

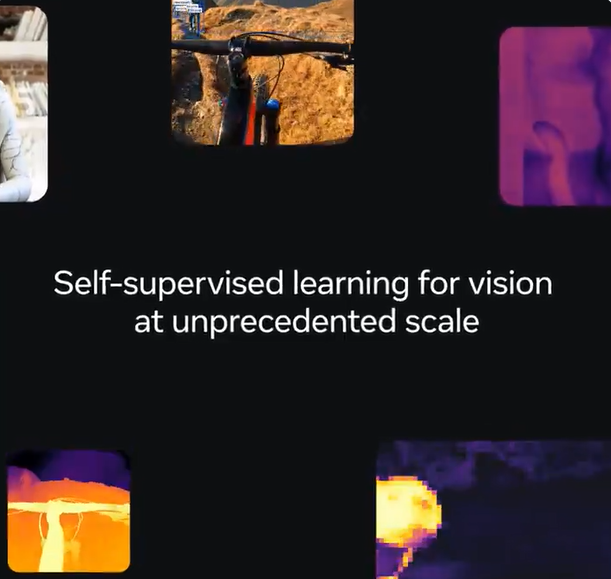

自监督学习:无需人工标注的突破

DINOv3 的核心创新在于其自监督学习框架,这一技术彻底摆脱了对人工标注的依赖。传统图像识别模型通常需要大量标注数据进行训练,而 DINOv3 通过自监督学习,能够从海量未标注图像中自主提取特征。这一特性不仅显著降低了数据准备的成本,更使其在数据稀缺或标注昂贵的场景中展现出巨大的应用潜力。社交媒体上的积极反馈表明,DINOv3 在多项基准测试中的表现与 SigLIP2、Perception Encoder 等领先模型持平甚至更优,充分彰显了其强大的通用性。

高分辨率特征提取:全局与细节兼得

DINOv3 的另一大亮点是其高质量高分辨率密集特征表示能力。该模型能够同时捕捉图像的全局信息和局部细节,为各类视觉任务提供强大的支持。无论是图像分类、目标检测、语义分割,还是图像检索和深度估计,DINOv3 均表现出色。此外,DINOv3 不仅限于处理普通照片,还能高效处理卫星图像、医学图像等多种复杂数据类型,为跨领域应用奠定了坚实基础。

广泛应用场景:从环境监测到医疗安防

DINOv3 的通用性和高性能使其在多个行业展现出广阔的应用前景。以下是一些典型场景:

– 环境监测:DINOv3 可用于分析卫星图像,助力监测森林覆盖、土地使用变化等,为环境保护和资源管理提供有力支持。

– 自动驾驶:通过精准的目标检测和语义分割,DINOv3 能够显著提升自动驾驶系统对道路环境和物体的识别能力。

– 医疗保健:在医学图像分析中,DINOv3 可用于检测病灶、分割器官,从而提升诊断效率和准确性。

– 安防监控:其人员识别和行为分析能力,为智能安防系统提供了强大支持。

社交媒体上已有开发者表示,DINOv3 的开源为中小型企业和研究机构提供了低成本接入尖端 AI 技术的机会,尤其是在数据资源有限的场景下。

开源赋能:推动 AI 视觉生态发展

Meta AI 此次将 DINOv3 的完整训练代码和预训练模型以商业友好许可开源,极大地降低了开发者的使用门槛。模型支持通过 PyTorch Hub 和 Hugging Face Transformers 库加载,提供了多种规模的预训练模型(从 21M 到 7B 参数),适应不同计算资源的需求。此外,Meta 还提供了下游任务的评估代码和示例笔记本,方便开发者快速上手。社交媒体反馈显示,DINOv3 已被整合进 Hugging Face 生态,开发者社区对其易用性和性能表现赞不绝口。

DINOv3 开启视觉 AI 新篇章

DINOv3 的发布不仅是 Meta AI 在计算机视觉领域的一次技术飞跃,也是开源 AI 生态的重要推动力。其自监督学习能力和多任务适应性,为开发者提供了前所未有的灵活性,特别是在数据稀缺的场景下。AIbase 认为,DINOv3 的开源将加速 AI 视觉技术在环境、医疗、自动驾驶等领域的落地,助力构建更加智能化的未来。然而,社交媒体上也有声音提醒,DINOv3 的广泛应用可能带来隐私和偏见等潜在风险,未来需进一步关注其在实际部署中的伦理问题。

结语

DINOv3 的开源标志着自监督学习在计算机视觉领域的又一次突破。从环境监测到医疗诊断,从自动驾驶到安防监控,DINOv3 的通用性和高性能正在为各行各业带来新的可能性。项目地址:https://github.com/facebookresearch/dinov3