Nvidia 近期推出了一款备受瞩目的新型小型语言模型——Nemotron-Nano-9B-v2,凭借其在多项基准测试中的卓越表现和高度灵活的推理功能控制,迅速吸引了开发者和研究者的目光。这款模型的参数量精简至90亿,相较于前代120亿的规模实现了显著压缩,使其能够完美适配单个Nvidia A10 GPU的部署需求,为资源受限的环境提供了强大的AI解决方案。

Nvidia AI模型后训练总监Oleksii Kuchiaev特别强调,Nemotron-Nano-9B-v2是专为A10 GPU深度优化的产物,能够将处理速度提升高达6倍,充分展现了其在性能效率方面的突破性进展。该模型支持包括英语、德语、西班牙语、法语、意大利语、日语在内的多种语言,并扩展了韩语、葡萄牙语、俄语和中文等语种的覆盖,特别适用于指令跟随和代码生成等复杂任务场景。

在技术架构上,Nemotron-Nano-9B-v2基于先进的Nemotron-H系列设计,创新性地融合了Mamba与Transformer的双重优势,在处理长序列信息时能够大幅降低内存消耗和计算压力。与传统的Transformer模型不同,Nemotron-H系列采用了革命性的选择性状态空间模型(SSM),在确保输出准确性的同时,实现了对更长信息序列的高效处理能力。

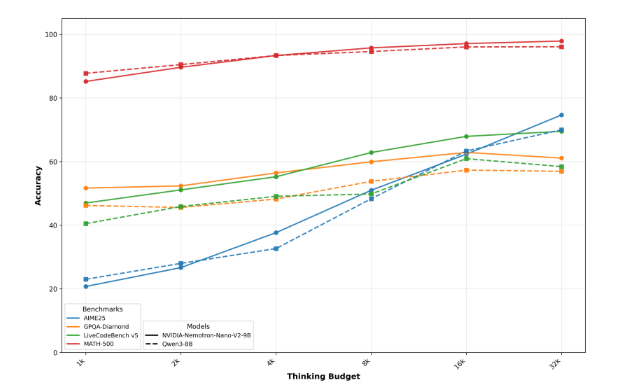

特别值得一提的是,Nemotron-Nano-9B-v2在推理功能控制方面实现了前所未有的灵活性。用户不仅可以默认获取推理过程的详细跟踪记录,还可以通过简单的控制指令如/think或/no_think随时切换这一功能。此外,模型内置了创新的运行时”思考预算”管理系统,允许开发者精确设定推理过程所允许的最大token数量,从而在准确性与响应速度之间实现理想的平衡。

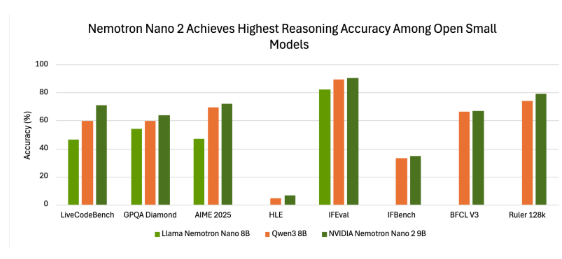

基准测试结果有力证明了Nemotron-Nano-9B-v2的卓越性能。在使用NeMo-Skills套件的”推理开启”模式下,该模型在多项关键测试中均表现突出,其综合表现甚至超越了其他同类小型开源模型,充分彰显了Nvidia在模型优化方面的领先实力。

在开源策略方面,Nvidia以极具吸引力的开放模型许可证发布了Nemotron-Nano-9B-v2,不仅允许商业用途,更赋予开发者完全的自由权去创建和分发衍生模型。尤为重要的是,Nvidia明确表示不会对模型生成的任何输出主张所有权,确保用户能够完全掌控其应用成果。这一举措标志着Nvidia在推动语言模型高效化与可控化发展道路上的坚定步伐。

huggingface:https://huggingface.co/nvidia/NVIDIA-Nemotron-Nano-9B-v2

? Nvidia 推出了新型小型语言模型 Nemotron-Nano-9B-v2,支持用户灵活控制推理功能。

⚙️ 该模型基于先进的混合架构,能够高效处理长序列信息,适用于多语言任务。

? Nemotron-Nano-9B-v2以开放模型许可证发布,允许开发者进行商业用途和衍生模型的创建。