Meta AI 研究团队近日通过 Pixio 图像模型研究,再次颠覆了人工智能视觉领域的传统认知。这项突破性成果表明,即便采用更为简化的训练路径,Pixio 依然能在深度估计和3D重建等复杂视觉任务中取得令人瞩目的表现。这一发现彻底打破了学术界长期以来的固有认知——即掩码自编码器(MAE)技术在场景理解上远逊于 DINOv2 或 DINOv3 等复杂算法。

Pixio 的核心创新源于对2021年 MAE 框架的深度改良。研究人员发现,原始设计中解码器的功能限制直接制约了编码器的表现。为此,他们显著增强了解码器的功能,并大幅扩大了图像遮罩区域。通过将细小的遮罩方块升级为大面积连续区域,Pixio 被迫从简单的像素复制转向真正的图像理解。这种设计迫使模型必须精准把握图像中的物体共现、3D 透视以及反射等复杂空间关系。

在模型架构上,Pixio 引入了多个用于聚合全局属性的类别标记。这些标记能够更精准地捕捉场景类型、相机角度及光照信息,从而显著提升场景理解的深度和广度。更值得关注的是 Pixio 的训练策略。与 DINOv3 针对特定基准测试(如 ImageNet)进行重复优化的做法不同,Pixio 从网络收集了20亿张图像,并采用动态频率调整机制——减少简单产品照的权重,增加复杂场景的训练频次。这种不针对测试集“刷分”的纯粹训练方式,反而赋予了模型更强的迁移能力。

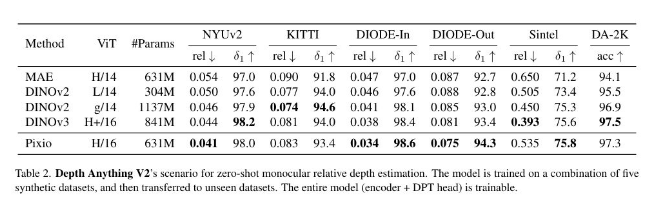

数据对比结果令人震撼。仅拥有6.31亿参数的 Pixio,在多项关键指标上全面超越了参数量达8.41亿的 DINOv3。在单目深度估计任务中,Pixio 的准确率提升了整整16%。更令人惊叹的是,在3D重建任务中,仅凭单张图像训练的 Pixio 表现甚至优于使用八视角训练的 DINOv3。同时,在机器人学习领域,Pixio 以78.4%的成功率同样领先于 DINOv2。

尽管研究团队承认人工掩蔽存在一定局限性,并计划向视频预测方向进一步探索,但 Pixio 目前取得的突破已经充分证明:回归像素重建的本质,往往能通向更深层的视觉理解。这一成果不仅为人工智能视觉领域带来了新的研究思路,更为未来智能应用开辟了更广阔的可能性。