在人工智能领域,Token数量限制始终是一个亟待突破的技术瓶颈。最近一项由华人团队完成的突破性研究,为这一难题带来了曙光。研究证实,扩散语言模型在Token数量受限的条件下,其数据学习潜力竟是传统自回归模型的整整三倍。这一发现不仅可能颠覆现有语言模型训练范式,更预示着AI领域即将迎来新的技术革命。

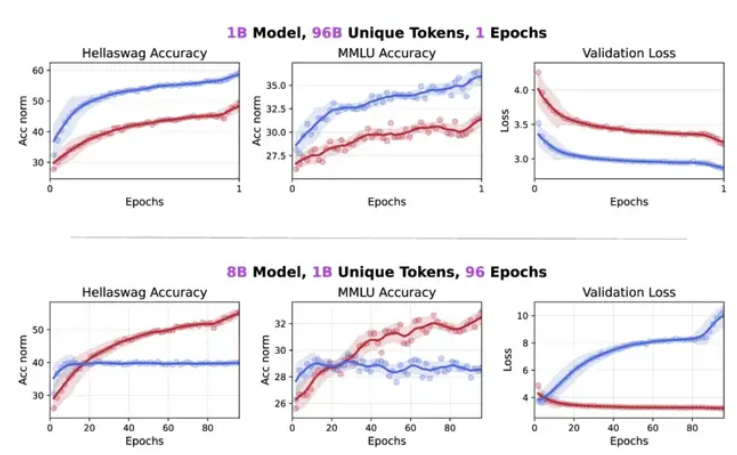

这项研究的核心是一个参数规模达10亿的扩散模型。研究团队采用10亿个Token进行了长达480个周期的密集训练。在HellaSwag和MMLU两大权威基准测试中,该模型分别取得了56%和33%的惊人准确率。尤为关键的是,整个训练过程完全摒弃了任何特殊技巧或数据筛选,所有成果均基于标准训练方法获得。更令人瞩目的是,即便在高度重复的数据训练环境中,模型性能依然呈现持续提升态势,充分证明其具备从同一数据中深度挖掘更多有效信息的独特能力。

研究人员深入剖析了扩散语言模型卓越数据学习能力的两大核心机制。首先,其采用的双向建模与扩散目标设计,使其能够全面捕捉数据深层语义,而传统自回归模型受限于单向因果处理方式。其次,扩散模型具备更高的计算密度,通过在训练与推理过程中投入更多计算资源,实现多次数据迭代优化,从而显著提升整体性能表现。

尽管扩散模型对数据重复使用展现出较强鲁棒性,研究团队注意到随着训练周期增加,模型会出现明显的过拟合现象。但令人意外的是,在下游任务中,模型性能并未如预期般下降,反而呈现持续提升趋势。这一反常现象揭示了一个重要发现:验证损失与下游任务准确率之间并非简单的线性关系。当模型面对有限训练数据时,可能会对某些文本片段产生过度自信的预测结果,从而在特定任务中表现更优。

这项研究成果为未来AI模型训练提供了全新思路。特别是在Token数量受限场景下,扩散语言模型的应用前景极为广阔。研究团队表示,后续将采用更大规模的模型和更多元化的数据集,进一步验证这些发现,有望为整个AI领域带来革命性突破。