DeepMind在其最新论文中提出了革命性的“帧链”(CoF,chain-of-frames)概念,为视频生成模型的发展开辟了新纪元。这一创新概念与先前的“链式思维”(CoT)异曲同工,后者赋予语言模型符号推理能力,而“帧链”则让视频模型能够在时空维度上实现推理,仿佛为视频生成模型注入了独立的思考能力。在论文中,DeepMind的研究团队提出了一个颠覆性的设想:视频生成模型是否能够像当前的大语言模型(LLM)一样,具备通用的视觉理解能力,无需针对特定任务进行专门训练?

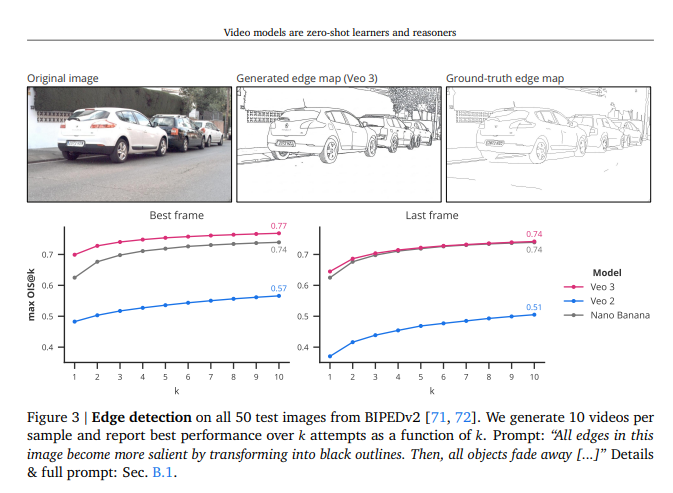

目前,机器视觉领域仍处于传统阶段,各种视觉任务需要不同的模型来处理,如物体分割、物体检测等,每次更换任务都需要重新训练模型。为了验证这一设想,研究团队采用了一种简单直接的方法:仅提供模型一张初始图像和一段文字指令,观察它能否生成720p分辨率、时长8秒的视频。这种方法与大型语言模型通过提示进行任务的方式如出一辙,旨在测试模型的原生通用能力。

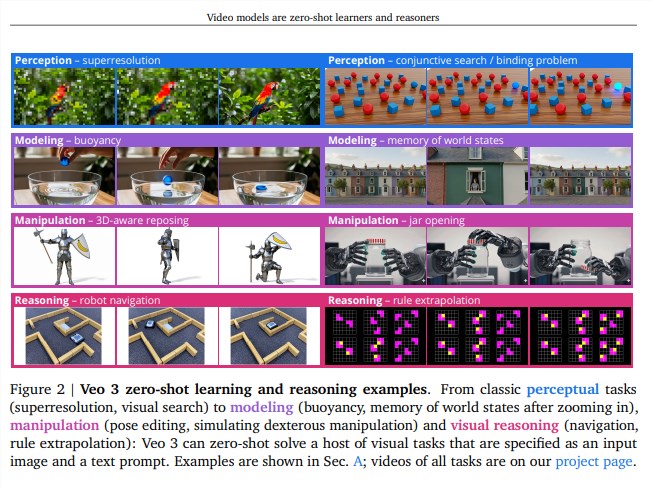

实验结果显示,DeepMind的Veo3模型在多个经典视觉任务上表现卓越,展现出强大的感知能力、建模能力和操控能力。更令人惊叹的是,该模型在进行跨时空视觉推理时表现出色,成功规划了一系列路径,从而能够解决复杂的视觉难题。总体而言,DeepMind团队总结了以下三大核心结论:

首先,普遍适应性强。Veo3能够解决许多未经专门训练的任务,展现出惊人的通用能力。其次,视觉推理初现雏形。通过分析生成的视频,Veo3显示出了类似于“帧链”的视觉推理能力,逐步建立起对视觉世界的理解。最后,快速发展趋势明显。尽管特定任务模型表现更优,Veo3的能力正在迅速提升,预示着未来可能出现更强大的通用视觉模型。

展望未来,DeepMind认为通用的视频模型将可能取代专用模型,就像早期的GPT-3最终成为强大的基础模型一样。随着成本的逐步降低,视频生成模型的广泛应用指日可待,预示着机器视觉的新时代正在向我们走来。论文地址:https://papers-pdfs.assets.alphaxiv.org/2509.20328v1.pdf