通义千问团队今日重磅发布全新图像生成模型——Qwen-Image-Layered,以突破性的自研创新架构彻底革新传统AI图片编辑模式。该模型通过革命性的“图层拆解”技术,赋予静态图片前所未有的可编辑性,引领“指哪改哪”精准编辑新时代的来临。

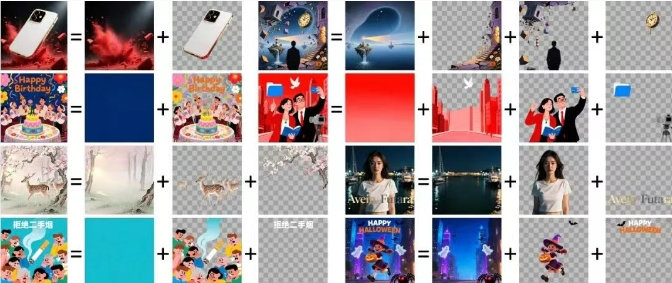

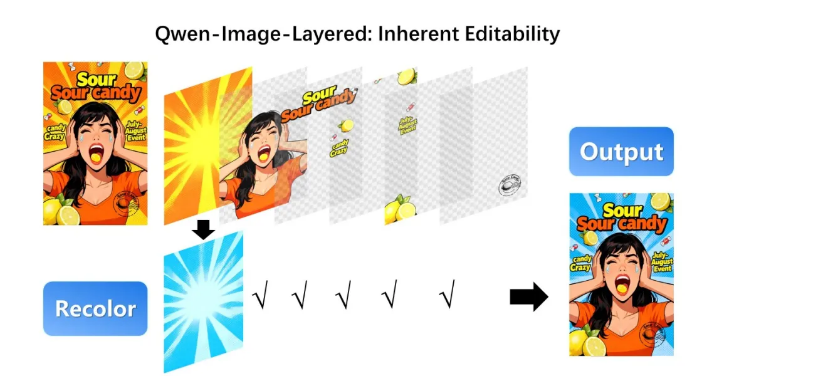

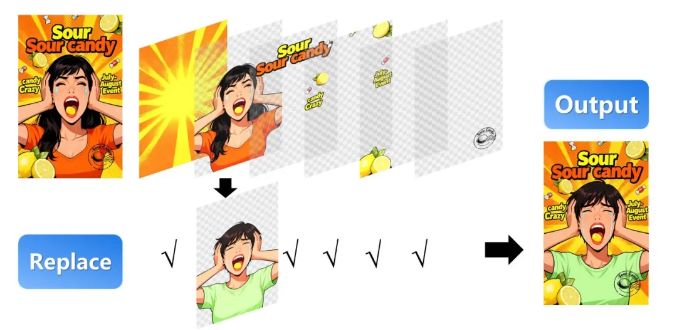

当前AI图片编辑领域存在两大核心痛点:全局编辑时易破坏未修改区域的一致性,而基于掩码的局部编辑又难以有效处理遮挡与模糊边界问题。Qwen-Image-Layered创新性地提出“图像解耦”思路,将图片自动“剥洋葱”式分解为语义独立的RGBA图层,每层拥有专属颜色(RGB)与透明度(Alpha),可独立操作且互不干扰。

模型的核心亮点主要体现在三个方面:全新研发的RGBA-VAE技术,使RGB图像与RGBA图层能在同一潜空间实现无缝“对话”,有效解决图层分布不均、边界模糊等难题;VLD-MMDiT架构支持3层至10层以上的灵活处理,层间通过注意力机制协同工作,无需低效递归拆解;历经“生成单图-生成多层-拆解任意RGB图像”多阶段进化,成功实现从生成能力到理解能力的转化。

在应用层面,Qwen-Image-Layered可胜任重新着色、物体替换、文字修改、元素删除、缩放移动等多种操作。更令人瞩目的是,该模型支持可变数量图层分解,同一图像可按需拆分为3层或8层,且任一图层还能进一步递归分解,实现无限层级细化。

目前,Qwen-Image-Layered的技术报告、代码仓库及Demo已分别在arXiv、Github、ModelScope等平台正式上线。通义千问团队表示,希望通过该模型将图像重构为可组合图层,为用户提供直观、精准且鲁棒的图片编辑能力,开启AI图像处理的新纪元。

技术报告:https://arxiv.org/abs/2512.15603Github: https://github.com/QwenLM/Qwen-Image-Layered ModelScope: https://www.modelscope.cn/models/Qwen/Qwen-Image-LayeredHugging Face: https://huggingface.co/Qwen/Qwen-Image-LayeredDemo: https://www.modelscope.cn/studios/Qwen/Qwen-Image-Layered