近日,苹果公司与普渡大学的研究团队共同推出了一项革命性的摄影技术——DarkDiff,旨在彻底解决智能手机在极端微光环境下的拍摄难题。这项创新技术通过将生成式扩散模型直接应用于相机的图像信号处理流程,使手机镜头能够在黑暗中捕捉令人惊叹的细节,为用户带来前所未有的夜拍体验。

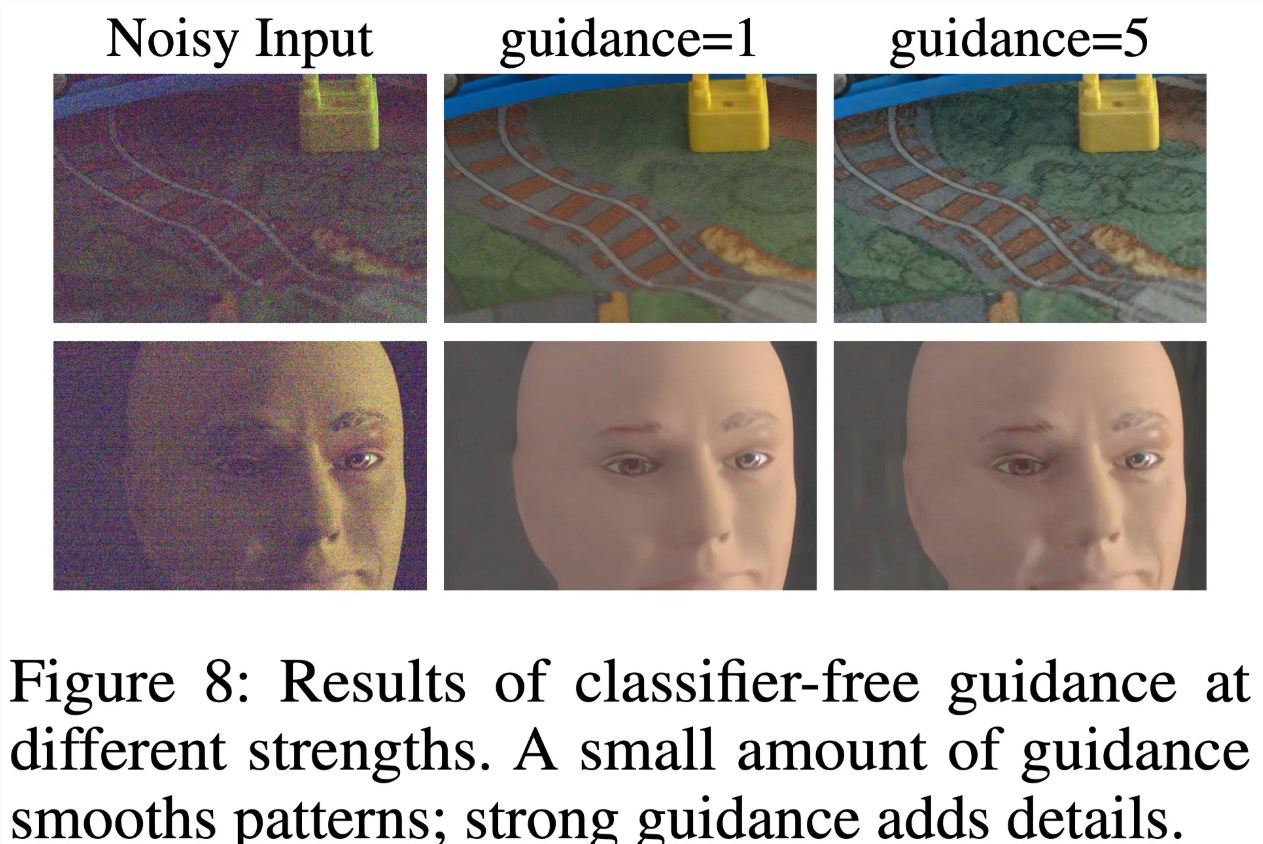

传统的夜景模式往往依赖后期算法降噪,但这种方式常常导致照片出现类似油画的虚假感或严重的涂抹痕迹,无法真实还原场景。DarkDiff的创新之处在于它并非简单的“后期修图”,而是让AI在图像生成的最初阶段就参与进来。通过学习海量影像数据,DarkDiff能够“预判”并恢复传感器在暗光下丢失的纹理与色彩,让夜拍照片重获生动与真实。

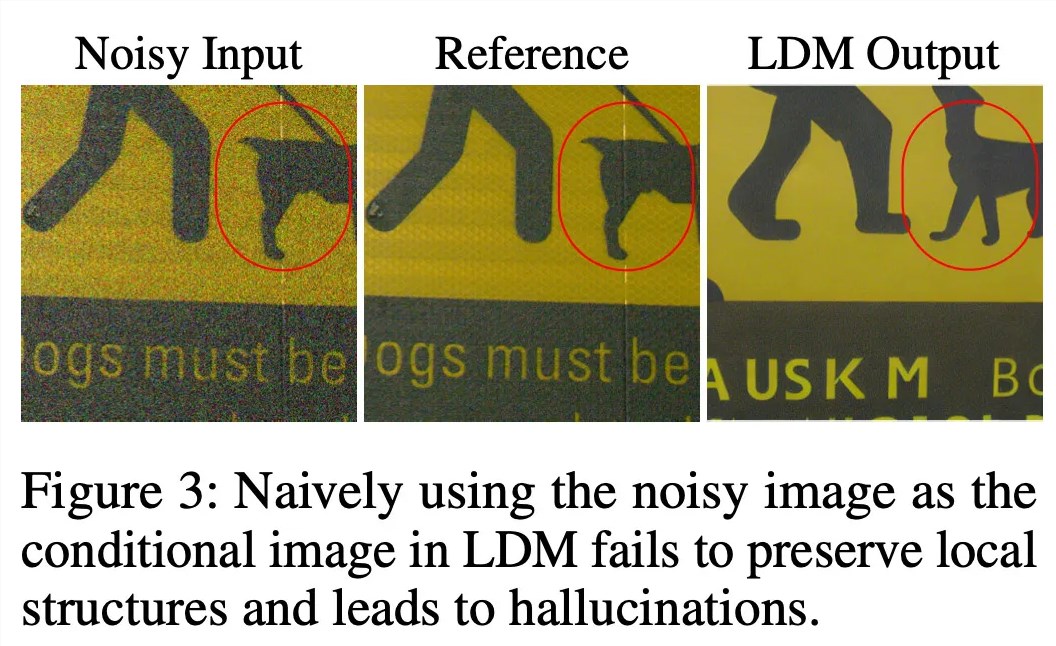

为了防止AI“凭空捏造”不真实的物体,研究团队还引入了局部斑块注意力机制,确保生成的每一处细节都符合拍摄现场的实际结构。这一机制不仅提升了照片的真实感,更保证了图像的准确性。在实际测试中,研究人员使用索尼A7SII模拟极暗环境,在仅有0.033秒的极短曝光下,DarkDiff还原出的照片质量极高,甚至能与使用三脚架进行300倍时长曝光的参考照片相媲美,展现了惊人的技术实力。

尽管DarkDiff的效果令人惊叹,但该技术要真正装进iPhone仍面临挑战。由于扩散模型对算力要求极高,运行起来非常耗电,未来可能需要依赖云端处理。此外,该模型目前在识别弱光环境下的非英语文字时仍有局限,需要进一步优化。虽然苹果尚未透露这项技术何时正式商用,但这无疑展示了未来移动摄影在AI加持下的无限潜力,预示着智能手机摄影将迎来新的革命。