近年来,随着人工智能技术的飞速发展,本地化AI大模型的开发与应用逐渐成为行业焦点。Ollama作为一款备受瞩目的开源工具,凭借其卓越的本地语言模型运行能力赢得了广泛认可。近日,据AIbase从社交媒体及相关渠道获悉,Ollama正式发布了桌面客户端,这一重大升级彻底改变了其传统的命令行操作模式,新增了直观界面、多模态识别以及文档拖拽功能,为用户带来了前所未有的便捷、智能交互体验。

从命令行到图形化界面:操作更简单直观

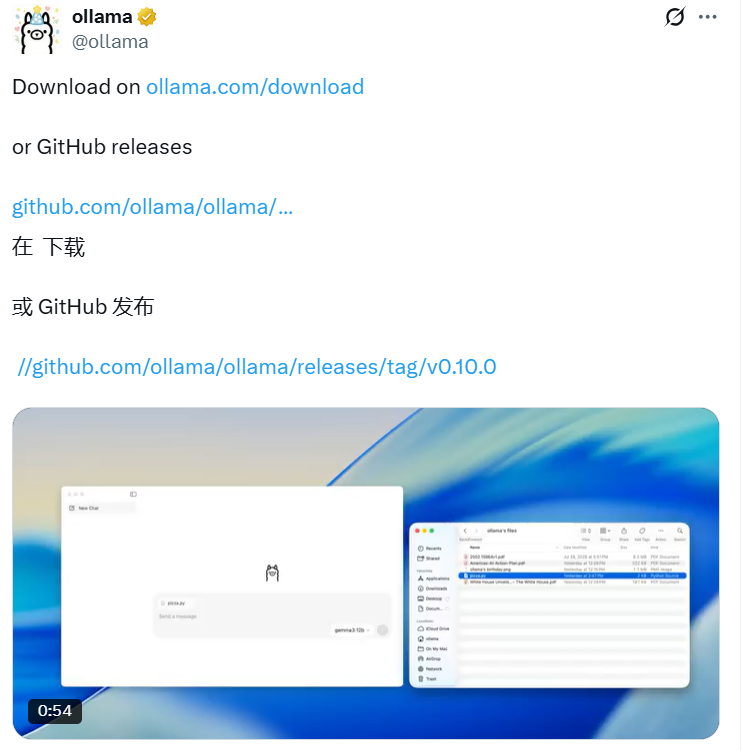

Ollama最初以命令行工具(CLI)的形式为开发者提供服务,虽然功能强大,但对非技术用户而言存在一定使用门槛。最新推出的桌面客户端彻底打破了这一限制。据悉,该客户端目前支持macOS系统,未来可能扩展至Windows和Linux平台。用户无需进行复杂配置,即可通过图形化界面直接操作,极大地降低了使用难度。

通过桌面客户端,用户可以轻松管理本地大语言模型(LLM),如Llama3、Qwen2、Phi3等。相比命令行,客户端提供了一键式模型下载功能,用户只需通过下拉菜单选择所需模型,即可完成安装和配置,极大地降低了使用门槛。AIbase认为,这一改进不仅吸引了开发者,也为普通用户打开了本地AI应用的大门。

下载地址:https://ollama.com/download

多模态识别:支持图像与文本交互

Ollama桌面客户端的另一大亮点是其多模态识别功能。社交媒体上已有用户反馈,客户端不仅支持文本交互,还能处理图像输入。例如,用户可以通过拖拽图片到界面,让模型(如LLaVA1.6)识别图像内容并生成描述。这一功能特别适用于需要图像分析的场景,例如内容创作、教育辅助或数据处理。

此外,客户端还支持PDF文档的拖拽上传,结合RAG(检索增强生成)技术,用户可以直接与文档内容进行交互,快速获取总结或解答相关问题。这一功能的加入,使Ollama从单一的文本生成工具升级为综合性的AI助手,满足多样化的使用需求。

隐私与效率并重:本地运行的独特优势

Ollama一直以其本地化运行的特性受到推崇,桌面客户端进一步强化了这一优势。所有模型和数据均存储在用户本地设备上,无需依赖云服务,最大程度保障了数据隐私。这对于法律、教育、医疗等对数据敏感行业尤为重要,能够满足如GDPR等严格的合规要求。

与此同时,桌面客户端优化了模型加载速度和内存管理,尤其是在macOS系统中,启动时间显著缩短,安装包体积也大幅减少。用户还可以通过设置,将模型存储路径调整至外部硬盘,灵活应对存储需求。AIbase注意到,部分用户反馈称,即便在硬件配置较低的设备上,Ollama客户端仍能流畅运行中小型模型(如9B以下参数模型),展现了其高效的资源利用能力。

开源社区的创新力:生态不断扩展

Ollama桌面客户端的发布离不开其背后活跃的开源社区支持。AIbase了解到,目前已有多个第三方项目围绕Ollama客户端展开开发,例如Ollamate、Cherry Studio等,提供了更多定制化功能。此外,Open WebUI等工具为Ollama提供了类似ChatGPT的网页界面,进一步丰富了用户体验。

社交媒体上,用户对Ollama客户端的评价普遍积极,认为其“简单优雅”且“功能强大”。有开发者表示,客户端的开源性质使其易于二次开发,未来有望集成更多插件,如语音交互、代码补全等功能。AIbase预计,随着社区的持续贡献,Ollama的生态系统将进一步扩展,为本地AI应用带来更多可能性。

未来可期:跨平台与多场景应用

目前,Ollama桌面客户端主要支持macOS,但社区反馈显示,Windows和Linux版本已在计划中。此外,部分用户提出希望客户端支持远程访问功能,以便在高性能设备上运行模型并通过低性能设备访问,这将进一步提升其灵活性。AIbase认为,Ollama桌面客户端的发布标志着本地AI工具从专业领域走向大众化应用的转折点。无论是开发者、教育工作者还是普通用户,都可以通过这一工具探索AI的潜力。未来,随着多模态功能的进一步完善和跨平台支持的实现,Ollama有望成为本地AI领域的标杆产品。

结语

Ollama桌面客户端的推出,不仅让本地AI操作更加便捷,也通过多模态识别和文档交互功能,为用户提供了更丰富的应用场景。AIbase将持续关注Ollama的更新动态,为您带来更多前沿资讯。让我们共同期待本地AI如何在隐私保护与高效交互的平衡中,开启智能生活的新篇章!