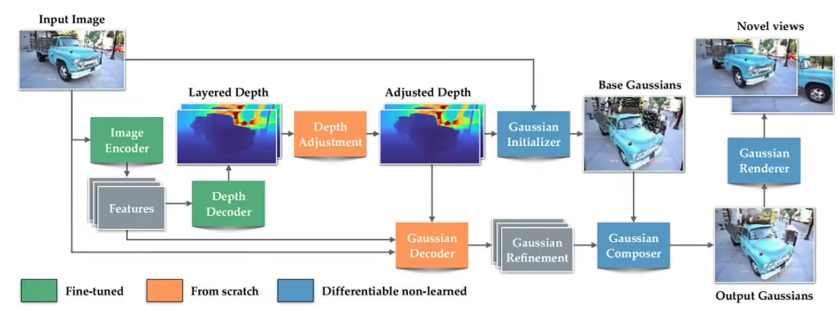

苹果公司近日在3D内容创作领域投下重磅炸弹,正式开源了名为SHARP的新型AI模型,为行业带来颠覆性突破。据科技媒体9to5Mac独家披露,这项技术彻底打破了传统3D重建耗时数小时的瓶颈,仅需不到一秒钟,就能将普通2D照片转化为具有真实物理比例的3D场景。苹果最新发布的论文《一秒内实现清晰的单目视图合成》揭示了SHARP的核心奥秘——先进的”3D高斯泼溅”技术(3D Gaussian Splatting)。这项技术彻底革新了建模流程,无需从成百上千个角度拍摄照片,SHARP凭借海量数据的深度训练,已掌握通用空间几何规律。通过神经网络的一次快速”扫描”,就能直接预测出数百万个带有光影信息的”高斯球”位置,瞬间完成建模。

在成像质量方面,SHARP同样刷新了行业标杆。测试数据显示,其生成的3D视图在纹理细节和结构还原度上大幅领先于此前业内最强的模型,能够支持极其真实的相机移动模拟。目前,苹果已将SHARP的完整代码及资源发布在GitHub平台供全球开发者下载。尽管该模型目前主要侧重于原图视角附近的重建,无法完全”脑补”背后的盲区,但其带来的近乎实时的转换体验,无疑将为移动端3D创作和空间计算应用开启全新的可能。

划重点:⚡ 速度实现量级突破:SHARP模型将2D转3D的处理速度提升了三个数量级,实现了不到一秒的近乎实时转换体验。🌐 领先的3D生成技术:基于3D高斯泼溅技术,模型通过单次神经网络前馈即可预测数百万个3D点位,精准还原真实物理比例。🔓 全面开源生态:苹果已在GitHub开源SHARP的代码与资源,旨在加速全球开发者在空间计算和3D内容领域的创新。