近日,阿里巴巴通义实验室携手南开大学计算机科学学院共同推出了一项突破性的视频大模型压缩技术——LLaVA-Scissor。这一创新成果旨在有效应对视频模型处理过程中所面临的核心挑战,特别是传统方法在处理视频帧时因高 token 数量而导致的推理速度缓慢和扩展性不足等问题。视频模型需要对每一帧进行独立编码,这种序列化处理方式使得 token 数量急剧增长,给计算资源带来了巨大压力。

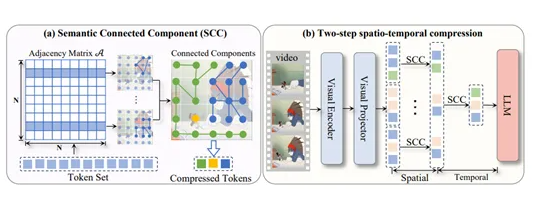

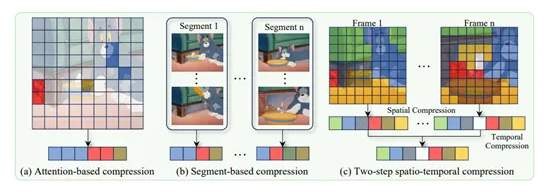

尽管传统的 token 压缩技术如 FastV、VisionZip 和 PLLaVA 等在图像领域取得了显著进展,但在视频理解任务中却暴露出语义覆盖不足和时序冗余等突出问题。为了突破这些瓶颈,LLaVA-Scissor 采用了一种基于图论的创新算法——SCC 方法,能够精准识别 token 集合中的不同语义区域。通过计算 token 之间的相似性,构建相似性图,并识别图中的连通分量,该方法能够将每个连通分量中的多个 token 替换为代表性 token,从而大幅减少 token 数量,显著提升处理效率。

为了进一步提升压缩效果,LLaVA-Scissor 采用了两步时空压缩策略。在空间压缩阶段,系统会对每一帧进行语义区域的精准识别,而在时间压缩阶段则专注于去除跨帧的冗余信息。这种双管齐下的压缩方式确保了最终生成的 token 能够高效地表示整个视频的完整语义,既保留了关键信息,又大幅降低了计算复杂度。

在实验验证方面,LLaVA-Scissor 在多个权威视频理解基准测试中展现了卓越性能,特别是在低 token 保留率下的优势尤为突出。例如,在视频问答基准测试中,该模型在仅保留50% token的情况下,性能与原始模型相当,而在35%和10%的保留率下,其表现更是超越了其他竞争方法。在长视频理解测试中,LLaVA-Scissor 同样表现出色,在 EgoSchema 数据集上,当 token 保留率仅为35%时,准确率仍能达到57.94%。这些优异表现充分证明了该技术的创新性和实用性。

这一创新的压缩技术不仅显著提升了视频处理的效率,更为未来视频理解和处理领域的发展开辟了新的方向。LLaVA-Scissor 的推出,无疑将为视频人工智能领域带来深远影响,推动相关技术的进一步突破和应用拓展。划重点:? LLaVA-Scissor 是阿里巴巴与南开大学联合研发的创新视频大模型压缩技术,专门针对传统方法中 token 数量激增的问题提供高效解决方案。 ? SCC 方法通过计算 token 相似性,构建图并识别连通分量,能够精准减少 token 数量,同时保留关键语义信息。 ? LLaVA-Scissor 在多个视频理解基准测试中表现卓越,尤其在低 token 保留率下展现出显著性能优势,为视频人工智能领域树立了新的标杆。