开源AI领域近日迎来重大突破,一款名为Jan-v1的深度研究模型正式问世,凭借卓越性能和独特优势迅速引发广泛关注。该模型基于阿里云Qwen3-4B-Thinking模型进行深度微调,直接对标商业化产品Perplexity Pro,却以仅4亿参数的精巧身姿展现出惊人的实力。

Jan-v1在性能表现上超越预期,其91%的SimpleQA准确率与商业产品不相上下,这一成绩令业界为之瞩目。通过对Qwen3-4B-Thinking模型的专项微调,Jan-v1在逻辑推理、工具使用和多步骤任务处理方面展现出超凡能力。更令人惊叹的是,该模型支持高达256K tokens的上下文长度,并通过YaRN技术可扩展至100万tokens,使其特别适用于长文档分析、学术研究和复杂对话场景,为用户提供了前所未有的灵活性。

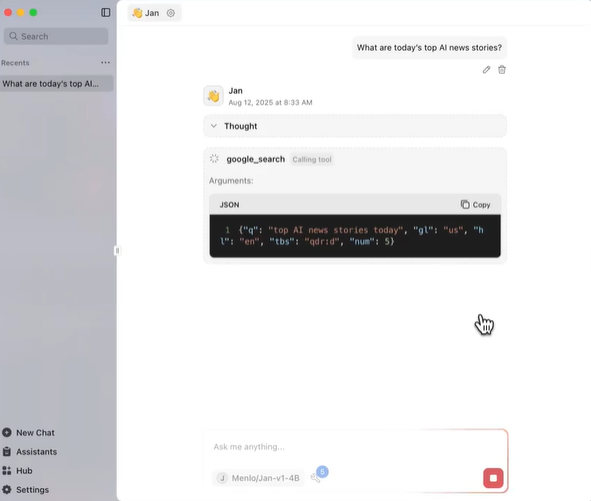

与依赖云端算力的大型模型不同,Jan-v1最大的优势在于完全支持本地运行。仅需约4GB VRAM即可高效工作,大大降低了硬件门槛和使用成本。这一特性不仅保障了用户数据的隐私安全,还避免了网络延迟和服务中断的风险。通过与Jan App的深度集成,用户可通过简洁的界面快速调用模型功能,支持vLLM和llama.cpp等多种部署方式,为开发者提供了丰富的集成选择。官方推荐的参数设置包括温度0.6、top_p0.95,以确保推理输出的高质量与稳定性。

Jan-v1的技术架构源于阿里云2025年4月发布的Qwen3-4B-Thinking模型,该基础模型拥有独特的双模推理机制,包括思考模式与非思考模式两种工作状态。通过创新的多阶段强化学习微调技术,Jan-v1摆脱了对传统监督微调的依赖,进一步提升了在数学、科学、编码和逻辑推理方面的能力。该模型的”思考模式”能够自动生成结构化的推理过程,输出以特定格式呈现,便于用户验证和理解AI的推理逻辑,这种透明化的推理过程对于学术研究和复杂问题分析具有重要价值。

Jan-v1被定位为多功能AI助手,特别适合深度研究、网络搜索和工具调用等场景。无论是解答复杂的学术问题、生成高质量代码,还是通过各种框架执行外部工具任务,Jan-v1都能提供可靠支持。该模型采用Apache2.0开源许可证,允许开发者自由定制和二次开发,结合Hugging Face、Ollama等平台的生态支持,Jan-v1的应用场景有望得到进一步扩展。

Jan-v1的发布在AI开发者社区引发了热烈讨论,许多开发者对其在低资源环境下的高性能表现给予高度评价,认为该模型重新定义了小型模型的应用潜力。91%的SimpleQA准确率和256K上下文支持,使其成为学术研究者和个人开发者的理想选择。尽管部分社区成员指出,4亿参数规模的模型在处理极其复杂的任务时可能需要配合外部工具进行优化,但Jan-v1的开源特性和完整的技术文档为社区贡献和持续改进提供了良好基础。

Jan-v1的发布标志着开源AI领域的重要进展,其兼顾性能与隐私的设计理念,以及相对较低的资源需求,为AI技术的普及和应用提供了新的可能性。随着社区的持续贡献和工具生态的不断完善,这款模型有望在AI研究和实际应用中发挥更大作用。项目地址:https://huggingface.co/janhq/Jan-v1-4B