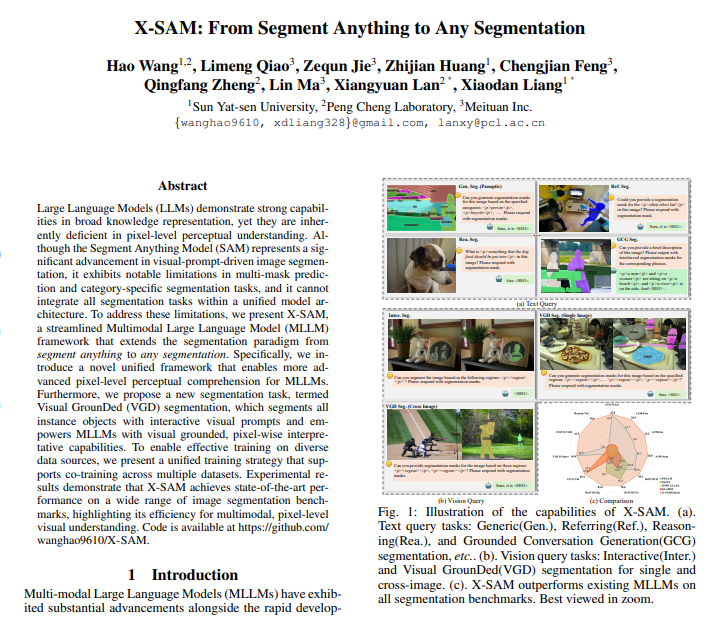

中山大学、鹏城实验室与美团联合研发的X-SAM图像分割模型近日正式问世,这款创新性多模态大模型在图像分割领域实现重大突破,将传统Segment Anything Model(SAM)的”分割万物”能力升级为”任意分割”,大幅拓展了模型的适应性与应用范围。相较于传统SAM仅能接受单一视觉提示输入的局限性,X-SAM通过突破性的视觉定位分割(VGS)任务框架,实现了对所有实例对象的精确交互式分割,为多模态大语言模型赋予了前所未有的像素级理解能力。

X-SAM的技术架构融合多项创新设计。模型采用统一的输入输出格式,可灵活处理包括文本描述、点标注在内的多种视觉和文本查询输入。其核心的双编码器架构能够深度解析图像内容与分割特征,而创新的分割连接器通过多尺度信息融合显著提升分割精度。尤为突出的是,X-SAM集成了Mask2Former架构作为分割解码器,实现了单次操作即可同时分割多个目标对象,彻底打破了传统SAM仅能处理单一对象的技术壁垒。这一改进不仅大幅提高处理效率,更为复杂场景下的批量分割任务开辟了新路径。

在模型训练方面,研究团队独创三阶段渐进式训练策略,通过逐步增强的学习过程确保模型性能的稳步提升。经过在20余个主流分割数据集上的全面验证,X-SAM在对话生成分割任务和图文理解任务中均取得领先性能表现,充分验证了其技术方案的卓越有效性。X-SAM的问世为图像分割技术发展指明新方向,为构建更智能的通用视觉理解系统奠定重要技术基础。

研究团队表示,未来将重点探索X-SAM在视频领域的应用拓展,推动图像与视频分割技术的统一化发展,持续突破机器视觉理解能力的边界。这项研究成果不仅在学术领域具有里程碑意义,其在自动驾驶、医疗影像、工业检测等实际应用场景中的巨大潜力也令人期待。随着模型开源和技术推广,预计将全面推动计算机视觉领域的快速发展。

论文地址:https://arxiv.org/pdf/2508.04655代码地址:https://github.com/wanghao9610/X-SAMDemo地址: https://47.115.200.157:7861