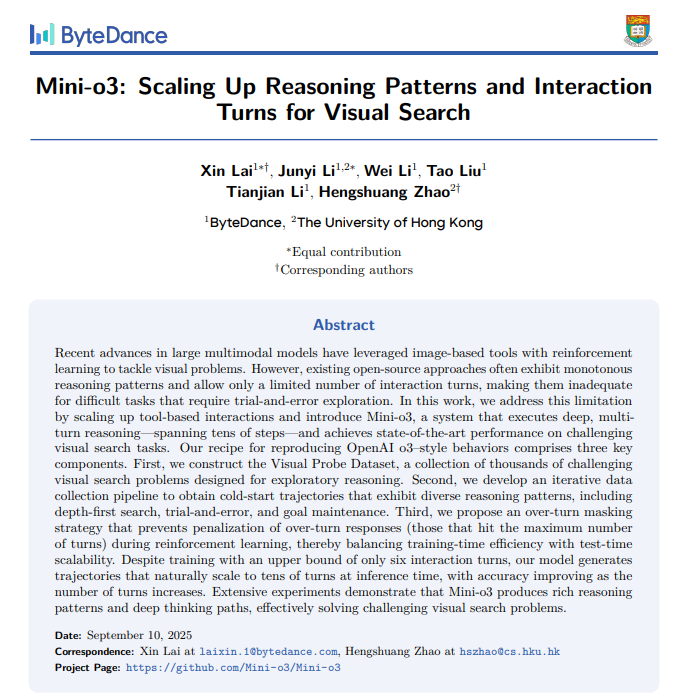

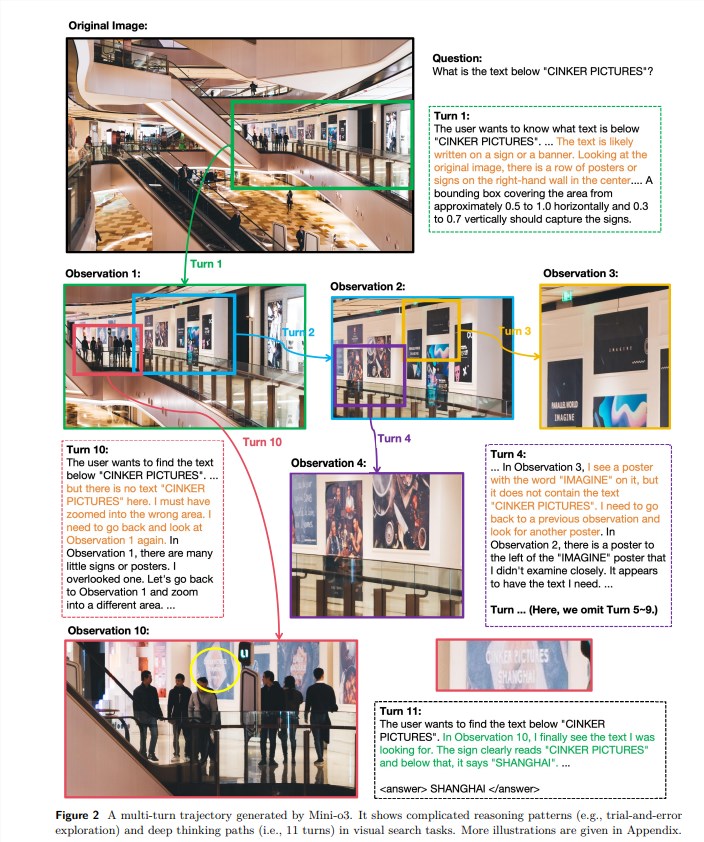

字节跳动与香港大学强强联手,共同研发出突破性的开源视觉推理模型——Mini-o3,为多轮视觉推理技术领域带来革命性进展。与以往仅支持1-2轮对话的视觉语言模型(VLM)相比,Mini-o3在训练阶段设定了6轮对话限制,却在测试环节实现了数十轮的推理扩展,显著增强了处理复杂视觉问题的能力。该模型在高难度视觉搜索任务中的深度推理表现,已达到当前技术前沿水平,其卓越性能源于三大核心设计要素的精妙融合。

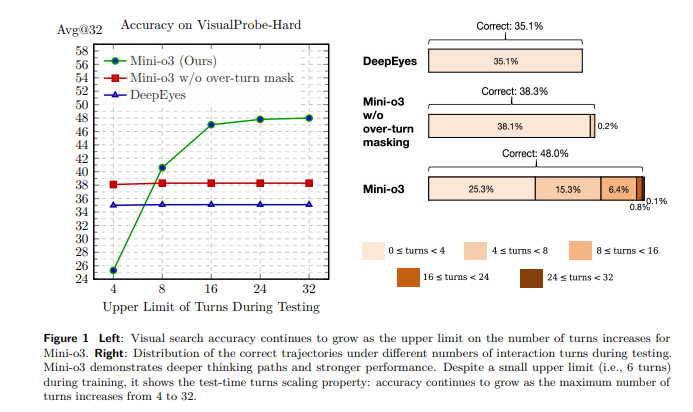

首先,研究团队精心构建了VisualProbe视觉探测数据集,内含数千个专为探索性推理设计的视觉搜索难题,为模型提供了丰富的认知训练素材。其次,他们创新性地开发了迭代数据收集流程,使模型能够自主学习深度优先搜索、试错探索和目标维持等多元推理策略,大幅提升了认知灵活性。最后,团队提出的超轮次掩码策略在强化学习过程中巧妙规避了对达到最大交互轮次的回答进行惩罚,这一创新显著提高了训练效率与测试扩展性。

Mini-o3的训练过程采用双阶段设计,第一阶段通过冷启动监督微调(SFT)激活多轮工具使用能力,研究团队通过上下文学习方式积累了大量高质量推理轨迹。第二阶段引入强化学习(RL)机制,通过降低图像像素限制和引入超轮次掩码技术,使模型互动轮次和推理能力得到质的飞跃。在多个视觉搜索基准测试中,Mini-o3的表现全面超越现有开源模型,展现出强大的技术优势。

对比实验进一步证实,冷启动SFT技术和超轮次掩码机制是提升推理能力的两大关键支柱。此外,合理的最大像素预算设置对模型性能优化同样至关重要。Mini-o3的问世不仅在技术上树立了新标杆,更为未来多轮视觉推理发展指明了创新方向。这一突破性成果表明,无需依赖海量训练资源,深度思考和复杂推理已成为可能,为人工智能领域注入了新的活力。论文详情请参阅:https://arxiv.org/pdf/2509.07969