近日,中国科学院自动化研究所的李国齐与徐波团队联合发布了一项革命性成果——全球首款大规模类脑脉冲大模型SpikingBrain1.0。这一创新模型在处理长文本任务时展现出惊人的性能,其速度比当前主流的Transformer模型高出百倍以上,能够高效处理高达400万token的超长文本,同时仅需2%的数据量即可达到同等效果。这一突破性进展为人工智能领域带来了新的曙光。

当前主流的大语言模型,如GPT系列,普遍基于Transformer架构。尽管Transformer凭借其强大的自注意力机制在自然语言处理领域取得了显著成就,但其计算复杂度却成为制约其发展的瓶颈。随着文本长度的增加,Transformer的计算量呈现平方级别的增长,导致处理长文本时耗时且能耗巨大。这一局限性使得AI在分析长篇小说、法律文书等复杂文本时显得力不从心。

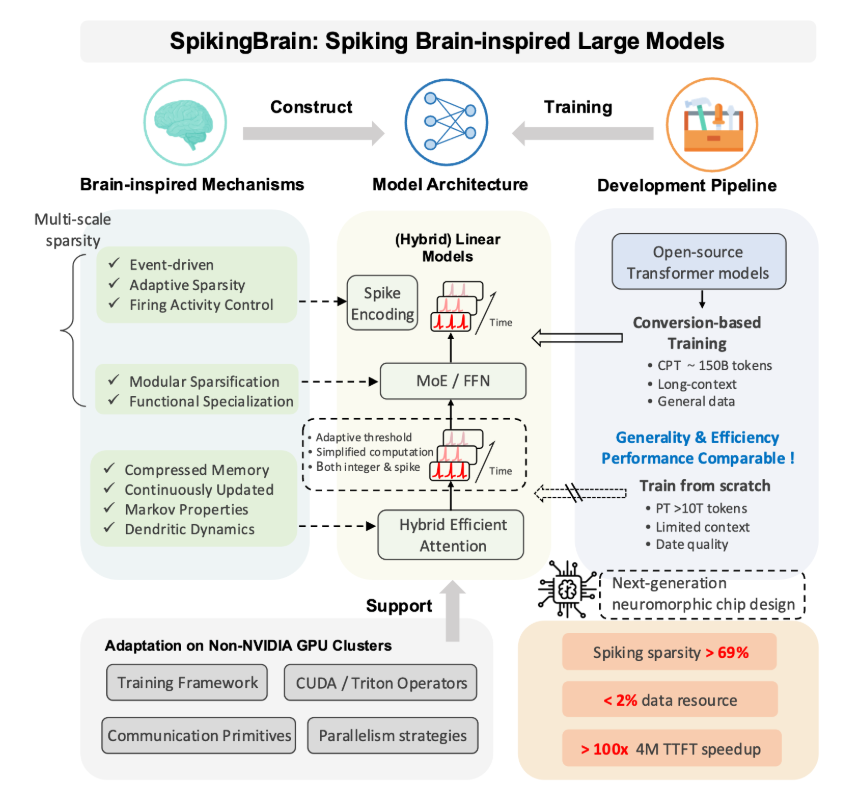

为了突破这一瓶颈,研究团队将目光投向了自然界最精密的智能系统——人脑。人脑由千亿神经元构成,却能以仅为20瓦的功耗高效运行。受此启发,团队提出了“基于内生复杂性”的理念,旨在通过模拟人脑神经元的工作方式提升模型的内部效率与智能。

SpikingBrain模型通过全新的架构模拟了人脑神经元的工作原理,推出了两个版本:SpikingBrain-7B(70亿参数)和SpikingBrain-76B(760亿参数)。首先,该模型创新性地抛弃了传统Transformer的二次方复杂度自注意力机制,采用了“混合线性注意力架构”,将计算复杂度降至线性(O(n)),大幅提升了处理长文本的效率。这一改进使得模型在处理超长文本时能够保持极高的速度和效率。

其次,SpikingBrain引入了“自适应阈值脉冲神经元”机制。这种机制使神经元的激活状态取决于接收到的信号强度,通过动态调整阈值,模型能够在高效能状态下运行。这种事件驱动的机制显著降低了能耗,计算稀疏度高达69.15%,为AI模型的绿色计算提供了新方案。

此外,研究团队还开发了一套高效的模型转换技术,能够将现有的Transformer模型直接转化为SpikingBrain架构,极大地降低了模型训练的成本和门槛。所有技术细节和代码已在GitHub及魔搭平台上开源,供全球研究人员免费使用,这一举措将加速类脑计算技术的普及与发展。

此次SpikingBrain的问世不仅在计算效率上取得了重大突破,更为未来的通用人工智能发展提供了一条全新的思路。通过模拟人脑的工作原理,SpikingBrain展现了在处理复杂任务时的巨大潜力,有望推动人工智能领域迈向更高水平的发展。

GitHub:https://github.com/BICLab/SpikingBrain-7B

划重点:

🌟 研究团队推出的SpikingBrain模型在处理长文本时速度比主流模型快100倍,仅需2%训练数据。

🧠 该模型采用混合线性注意力架构,计算复杂度从二次方降至线性,显著提升了处理效率。

💡 SpikingBrain的自适应阈值脉冲神经元机制大幅降低能耗,实现高达69.15%的计算稀疏度。