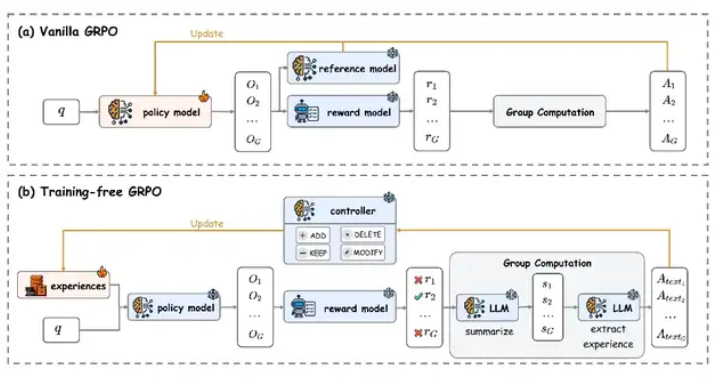

腾讯AI实验室近期推出了一项突破性的模型优化技术——”无训练组相对策略优化”(Training-Free GRPO),为AI领域带来了革命性的变革。这项创新技术通过引入外部知识库更新机制,巧妙地替代了传统的参数微调方式,在显著降低训练成本的同时,实现了与高成本微调方案相当的性能表现。其核心突破在于将人类经验知识转化为token级别的先验信息,使得大模型能够在完全不调整参数的状态下完成性能优化。

在腾讯研究团队的精心实验中,DeepSeek-V3.1-Terminus模型经过Training-Free GRPO优化后,在数学推理和网络搜索等关键任务上展现出惊人的表现。这一成果为解决传统大语言模型在复杂任务处理中的局限性提供了全新思路。与常规方法不同,Training-Free GRPO采用保持模型主体参数冻结,仅动态维护外部经验知识库的设计理念,既大幅减少了计算资源消耗,又显著提升了模型的跨领域泛化能力。

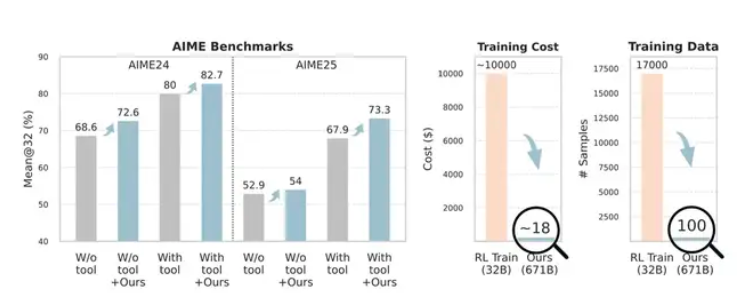

实验数据有力证明了这一方法的卓越效果。在数学竞赛级测试AIME24和AIME25中,经过优化的DeepSeek-V3.1-Terminus模型准确率分别实现了从80%到82.7%和从67.9%到73.3%的显著提升。更令人惊叹的是,这一进步仅依赖于100个跨域训练样本,而传统强化学习方法通常需要数千个样本才能达到类似效果,其高昂成本往往高达数万美元。在网络搜索任务中,模型的Pass@1指标也从63.2%跃升至67.8%,充分展现了该技术的普适性。

从经济角度来看,Training-Free GRPO的性价比优势尤为突出。官方数据显示,使用该技术优化一个模型仅需约120元人民币,而传统参数微调方案的成本通常高达7万元左右。这种巨大的成本差异主要源于该方法无需进行梯度回传和参数更新等计算密集型操作。这一创新为AI模型优化领域开辟了新的发展方向,特别是对于资源有限的中小企业和研究机构而言,这种低成本高效率的优化方案极大地降低了大模型应用的门槛。

尽管当前公布的测试数据主要集中在数学推理和信息检索等特定任务上,但这项技术的发布无疑为AI模型优化提供了全新的思路方向。随着更多场景下的验证数据逐渐完善,Training-Free GRPO有望在更广泛的领域发挥其独特优势,推动AI技术的普及和应用。论文地址:https://arxiv.org/abs/2510.08191