近日,小红书与复旦大学联合宣布在布局控制生成(Layout-to-Image)领域取得突破性进展,正式推出创新技术——InstanceAssemble。这项研究成果旨在攻克AI绘画中困扰已久的“构图难题”,通过革命性机制实现从简单到复杂场景的精准图像生成。据悉,相关技术论文已成功入选人工智能顶级会议NeurIPS2025,标志着该技术获得学术界的高度认可。

在当前AI绘画领域,虽然“文字生成图像”技术已趋于成熟,但在“布局控制生成”方面仍存在明显短板。传统AI往往难以精确遵循用户设定的空间约束(如边界框或分割掩码)来安排画面元素,常见问题包括物体位置对齐误差和语义逻辑脱节。InstanceAssemble技术的问世,正式开启了AI绘画的“精准构图”新纪元。

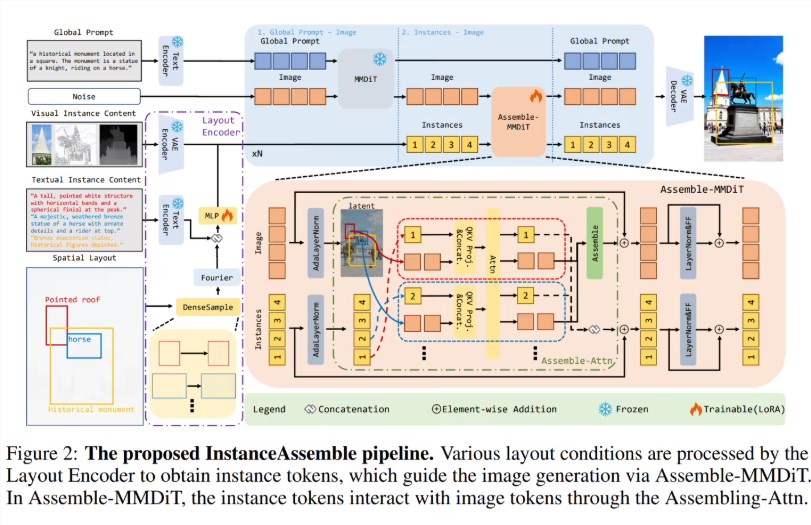

该技术基于主流的扩散变换器架构,核心创新在于提出“实例拼装注意力”机制。用户在使用时,只需提供每个物体的具体位置标注(边界框)和内容描述,AI即可在指定区域内生成高度符合要求的图像。无论是包含少量元素的简洁画面,还是实例密集的复杂场景,InstanceAssemble都能保持卓越的排版精度和语义一致性。

InstanceAssemble最值得关注的技术特性是其轻量级适配方案。该技术无需对整个大模型进行重新训练,仅需极少的额外参数即可实现现有模型的快速适配。具体而言,适配Stable Diffusion3-Medium模型仅需约3.46%的额外参数,而适配Flux.1模型时参数占比更是低至0.84%。这种高效的设计大大降低了技术应用的门槛。

为了全面评估技术性能,研究团队还同步推出了包含9万个实例的“Denselayout”基准测试集及全新评估指标体系。这一举措将推动行业对布局控制生成技术的标准化评估进程。目前,InstanceAssemble已在GitHub完成开源,开发者可免费获取源代码和预训练模型,为设计、广告及内容创意行业带来巨大应用潜力。

github:https://github.com/FireRedTeam/InstanceAssemble

划重点:🎯 精准排版控制:通过“实例拼装注意力”机制,让AI能够严格按照用户设定的位置生成物体,完美支持从稀疏到密集的复杂布局需求。⚡ 极低适配成本:采用轻量化设计理念,无需重训全模型,仅需不足1%至4%的额外参数即可适配Flux.1或SD3等主流模型。🔓 全面开源共享:项目已在GitHub开源并提供预训练模型,同时发布了全新的测试基准集Denselayout以推动行业评估标准化进程。