智谱AI今日凌晨重磅官宣,正式向全球开源其最新研发的”混合思考”模型——GLM-4.7-Flash,这一30B规格的顶尖模型在性能与轻量化部署之间实现了完美平衡,凭借卓越的推理编码能力强势登顶同类规格模型性能榜首。

性能领跑:30B级别的”全能王者”GLM-4.7-Flash

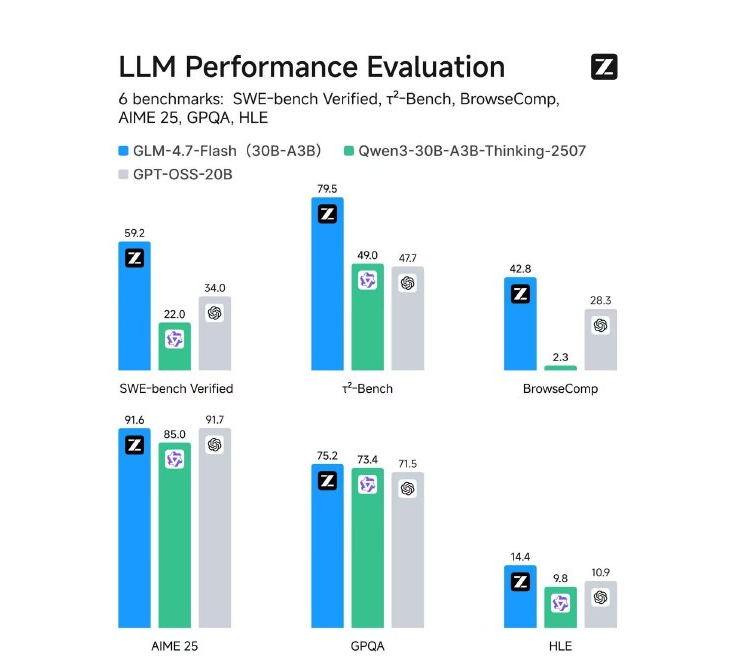

该模型采用创新的30B-A3B MoE(混合专家)架构,总参数量高达300亿,但在实际任务处理中仅需激活约30亿精锐参数。这种精妙设计在资源占用与处理能力之间构建了理想平衡,使其成为30B规格中的性能标杆。多项权威基准测试结果印证了其卓越表现:

在软件工程领域,GLM-4.7-Flash以59.2分的优异成绩超越同行,展现出顶尖的代码修复能力;数学与推理能力同样突出,AIME25测试斩获91.6分,GPQA(专家级问答)达到75.2分;工具协作方面,τ²-Bench测试成绩79.5分,BrowseComp测试42.8分,在智能体(Agent)场景下表现尤为亮眼。

开发者友好:灵活的本地化部署方案

GLM-4.7-Flash主打轻量化与实用主义,特别适合本地或私有云环境部署。为确保性能稳定释放,该模型已获得主流推理框架全面支持:

– vLLM与SGLang:均在main分支提供稳定支持,开发者可通过tensor-parallel-size和speculative-config等参数优化并发与解码速度;SGLang更支持EAGLE算法进一步提升推理效率

– Hugging Face:支持直接通过transformers库调用,极大降低了快速实验与集成的技术门槛

市场反馈:不牺牲轻便的性能跃迁

行业社区对该版本发布反响热烈。众多开发者表示,GLM-4.7-Flash在不增加硬件负担的前提下,显著提升了实际任务中的”体感速度”。一位资深开发者评价道:”它在编码和工具调用上的表现让本地AI助手真正好用,这种性能与效率的完美平衡正是我们长期追求的。”

开源地址:https://huggingface.co/zai-org/GLM-4.7-Flash