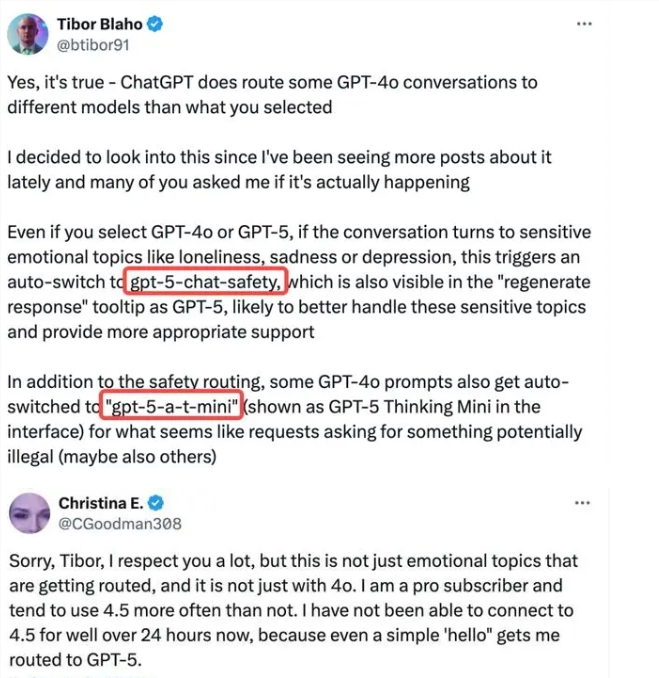

近日,OpenAI 在付费用户群体中掀起了一场不小的风波,其未经用户许可便将备受期待的 GPT-4 和 GPT-5 高阶模型替换为两款低算力的“秘密模型”——gpt-5-chat-safety 和 gpt-5-a-t-mini,这一举动迅速引发了广泛关注和热议。根据众多用户的反馈,当他们在对话中涉及情感表达、敏感话题或可能触发安全机制的违规内容时,系统会自动切换至这些过滤模型,导致回复质量大幅下降,甚至出现逻辑混乱、内容生成能力减弱等问题。这一突然的变更不仅让用户感到措手不及,更引发了他们对自身权益和选择权的强烈质疑。

据了解,OpenAI 在进行模型切换的过程中,并未以任何形式提前告知用户,也没有提供任何官方说明或解释。尽管 OpenAI 后续回应称,此举是出于安全测试和风险控制的考虑,旨在防止模型被滥用或生成不当内容,但这一解释并未平息用户的愤怒。许多用户表示,他们作为付费用户,理应享有使用高阶模型所对应的服务和体验,而不是在毫不知情的情况下被暗中降级。这种缺乏透明度和沟通的做法,让用户感到自己的知情权和使用权受到了严重侵犯。

用户们普遍反映,当他们满怀期待地为 GPT-4 或 GPT-5 付费订阅时,期望的是能够获得最前沿的 AI 生成能力和最流畅的对话体验,而不是在不知不觉中被替换为功能受限的过滤模型。这种“暗箱操作”不仅损害了用户体验,更让他们对 OpenAI 的信任度大打折扣。有用户甚至表示,如果这种做法持续下去,他们可能会考虑取消订阅或转向其他更可靠的 AI 服务提供商。

这一事件也折射出当前人工智能行业中用户选择权和知情权的重要性日益凸显。随着 AI 技术的快速发展,用户对 AI 厂商在算法控制、模型切换、资源分配等方面的政策越来越敏感。越来越多的用户开始对那些模糊不清、缺乏透明度的政策表示担忧,认为这样的做法不仅会影响用户体验,更可能损害品牌形象和用户忠诚度。AI 厂商需要更加重视用户的需求和感受,建立更加完善的沟通机制和反馈渠道,确保用户能够获得公平、透明、可靠的服务体验。只有这样,才能在激烈的市场竞争中赢得用户的信任和支持,实现可持续发展。