微新创想:MiniMax 发布 M2.5 模型,这是其 M2 系列在 108 天内的第三个版本。该模型不仅开源权重同步上线魔搭 ModelScope,更在能力、效率、成本三个方面实现了突破性进展。M2.5 在编程、搜索、办公等多个应用场景中表现出色,为用户提供了从零代码使用到私有化部署的全流程接入方案。此外,MiniMax 还推出了工具调用与推理参数调优的完整实战指南,推动低成本 Agent 时代的到来。

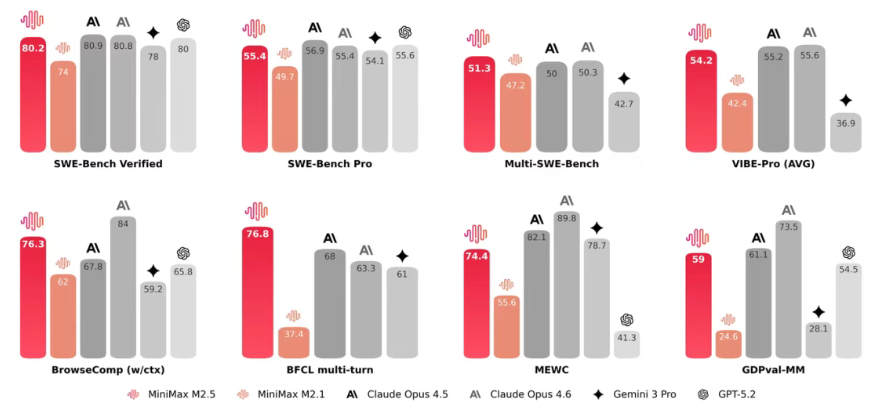

微新创想:M2.5 在多项权威评测中取得了优异成绩。SWE-Bench Verified 得分达到 80.2%,超越了 GPT-5.2 并接近 Claude Opus4.5。在 Multi-SWE-Bench 测试中,M2.5 以 51.3% 的表现位居多语言编程能力行业第一。BrowseComp 得分高达 76.3%,在搜索与工具调用能力方面大幅领先。编程能力方面,M2.5 展现出架构师级别的规划能力,覆盖完整的开发生命周期,支持多平台全栈开发,其框架泛化能力优于 Claude Opus4.6。搜索任务中,模型能够减少 20% 的轮次消耗,专家级搜索表现卓越。办公场景中,M2.5 融合了金融、法律等行业知识,展现出高阶办公能力,内部评测显示其对主流模型的胜率高达 59.0%。

微新创想:M2.5 在性能上也有显著提升,其速度较 M2.1 提高了 37%,与 Claude Opus4.6 的耗时持平,但成本仅为后者十分之一。这一突破性的表现得益于 MiniMax 在技术创新方面的持续投入。M2.5 的快速迭代主要源于三大核心技术的创新:一是 Forge 原生 Agent RL 框架,实现了约 40 倍的训练加速;二是 CISPO 算法保障大规模训练的稳定性,有效解决了长上下文信用分配难题;三是创新的 Reward 设计,能够在模型效果与响应速度之间取得良好平衡。这些技术的融合使得 MiniMax 内部 30% 的日常任务和 80% 的新提交代码得以由 M2.5 完成,M2 系列在 108 天内 SWE-Bench Verified 得分从 69.4% 飙升至 80.2%,迭代速度远超行业主流模型。

微新创想:为了满足不同用户的需求,M2.5 提供了多种部署方式,包括零代码使用、API 调用和本地部署。非技术用户可以通过 MiniMax Agent 网页端轻松上手,平台已有超过 10000 个用户创建了可复用的 “Expert” 工具。开发者可以选择调用魔搭免费 API 或官方 API,官方还推出了 Lightning 和标准版两个 API 版本,成本仅为同类模型的十分之一到 twentieth。本地部署方面,M2.5 支持 SGLang、vLLM、Transformers、MLX 四种方案,分别适用于高并发生产、中小规模生产、快速验证和 Mac 本地开发等不同场景,并提供了各方案的硬件要求和详细操作步骤。

微新创想:M2.5 还原生支持结构化工具调用,能够并行调用多个工具。通过 vLLM 或 SGLang 部署,用户可以直接使用 OpenAI SDK 格式进行调用,而其他框架则需要手动解析 XML 格式输出。同时,官方提供了工具结果回传模型的完整流程和最佳实践,帮助用户更高效地实现自动化任务。在推理参数方面,官方推荐使用 temperature=1.0、top_p=0.95、top_k=40 的配置,以达到最佳效果。不同场景下,用户可以根据需求灵活调优参数。此外,M2.5 对 10 多种编程语言和多种脚手架均具备优秀的适配性,使得编程提示词能够充分利用模型的架构师思维,提升开发效率与质量。