字节跳动Seed团队近日重磅发布3D生成大模型Seed3D1.0,这一突破性技术能够从单张图像实现端到端的高质量仿真级3D模型生成,涵盖精细几何结构、真实纹理效果以及基于物理渲染(PBR)的材质表现。这一创新成果将为具身智能领域的发展注入强大动力,有效突破当前技术在物理交互能力和内容多样性方面的现有瓶颈。

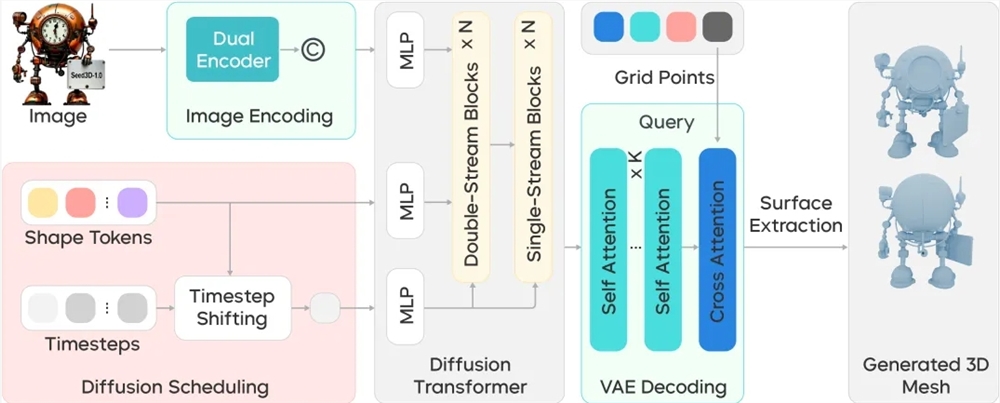

在研发过程中,Seed团队通过系统化收集与处理海量高质量3D数据,构建了完整的三阶段数据处理管线,成功将海量异构原始数据转化为高精度训练集。Seed3D1.0基于先进的Diffusion Transformer架构设计,采用端到端技术路线,实现了从单张图像到仿真级3D模型的快速高效生成。该模型在多个维度展现出卓越性能:几何生成方面,能够精准构建复杂物体的结构细节并确保物理完整性;纹理贴图生成上,通过创新的多模态Diffusion Transformer架构,实现了不同视角间的高度一致性;PBR材质生成方面,采用先进的估计方法框架,显著提升了材质估计的准确性。

Seed3D1.0的生成能力在多项权威对比评估中脱颖而出。在几何生成测试中,仅含1.5B参数的Seed3D1.0性能超越了业界主流的3B参数模型,能够更精准地还原复杂物体的精细特征。在纹理材质生成方面,Seed3D1.0在参考图像保持性上表现卓越,尤其在精细文本生成和人物建模方面优势显著。人工评测结果显示,该模型在几何质量、材质纹理、视觉清晰度及细节丰富度等多个维度均获得高度认可。

Seed3D1.0不仅支持单一物体的3D模型生成,还能通过分步生成策略构建完整的3D场景。生成的模型可无缝导入Isaac Sim等主流仿真引擎,仅需少量适配工作即可支持具身智能大模型训练。这一能力为机器人训练提供了丰富多样的操作场景,实现了交互式学习,并为视觉-语言-行动模型的构建奠定了全面的评估基准。

尽管Seed3D1.0在三维模型和场景生成领域展现出卓越性能,Seed团队仍清醒认识到,要基于3D生成大模型搭建完整世界模型,仍需在生成精度和泛化性方面持续提升。未来,团队计划引入多模态大语言模型(MLLM)技术,进一步优化3D生成的质量和鲁棒性,并加速推动3D生成模型在世界模拟器中的大规模应用落地。

项目主页:https://seed.bytedance.com/seed3d

体验入口:https://console.volcengine.com/ark/region:ark+cn-beijing/experience/vision?modelId=doubao-seed3d-1-0-250928&tab=Gen3D