英伟达研究团队近日重磅发布了全新全模态理解模型——OmniVinci,该模型在关键基准测试中实现了突破性表现,相较于当前顶尖模型整整领先19.05分。更令人惊叹的是,这一卓越成果是在仅使用1/6训练数据的前提下取得的,充分展现了其超凡的数据效率与性能表现。

OmniVinci的核心使命是构建一个能够同时理解视觉、音频和文本的全能AI系统,让机器能够像人类一样通过多感官协同感知并解析复杂世界。为实现这一宏伟目标,英伟达团队创新性地采用了双管齐下的策略:通过突破性的架构设计优化与高效的数据管理机制,成功构建了一个统一的全模态潜在空间,实现了跨模态信息的无缝融合与深度理解。

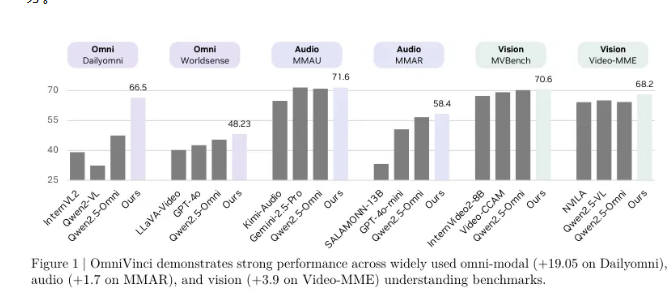

在权威的Dailyomni基准测试中,OmniVinci的表现力超越了业界领先模型Qwen2.5-Omni。具体而言,其在音频理解MMAR测试中高出1.7分,在视觉理解Video-MME测试中更是领先3.9分。值得注意的是,OmniVinci的训练Token数量仅为0.2万亿,而Qwen2.5-Omni的训练量高达1.2万亿,这意味着OmniVinci的训练效率是后者的6倍,这一成就充分彰显了其在资源利用方面的革命性突破。

OmniVinci的核心创新在于其独创的全模态对齐机制,该机制整合了三项关键技术:OmniAlignNet模块、时间嵌入分组(TEG)以及约束旋转时间嵌入(CRTE)。OmniAlignNet通过精准捕捉视觉与音频信号之间的互补性特征,显著提升了模态间的学习协同与对齐效果。TEG技术则通过创新的时间分组策略,有效编码了视听信息中的时序关系。而CRTE技术进一步攻克了时间对齐难题,确保模型能够准确理解事件的绝对时间维度。

研究团队采用了创新的分阶段训练方法:首先进行模态专项训练,随后开展全模态联合训练,通过循序渐进的方式逐步提升模型的多模态理解能力。在隐式全模态学习方面,研究团队通过现有视频问答数据集的深度挖掘,显著增强了模型对音视频信息的联合理解能力。

OmniVinci的问世标志着英伟达在多模态AI领域实现了历史性突破,这一成果预计将全面推动AI技术在各领域的创新应用,助力更智能化的系统和服务的诞生。更为重要的是,英伟达已宣布将OmniVinci开源发布,这一举措将为全球研究者和开发者提供宝贵的资源,加速AI技术在实际场景中的探索与创新进程。