在人工智能大模型领域竞争日趋激烈的今天,高效推理能力与长上下文处理能力已成为制约开发者创新的关键瓶颈。近日,蚂蚁集团旗下百灵大模型团队正式宣布开源其最新研究成果——Ring-flash-linear-2.0-128K模型,这是一款专为超长文本编程场景设计的创新性AI解决方案。该模型凭借其独特的混合线性注意力机制和稀疏MoE(Mixture of Experts)架构,在仅激活6.1B参数的情况下,即可实现媲美40B参数密集模型的卓越性能,在代码生成、智能代理等前沿应用领域取得了SOTA(State-of-the-Art)表现。AIbase基于Hugging Face官方发布资料与技术报告,独家解析了该模型的突破性技术亮点,旨在帮助开发者把握”高效AI编程”的新时代机遇。

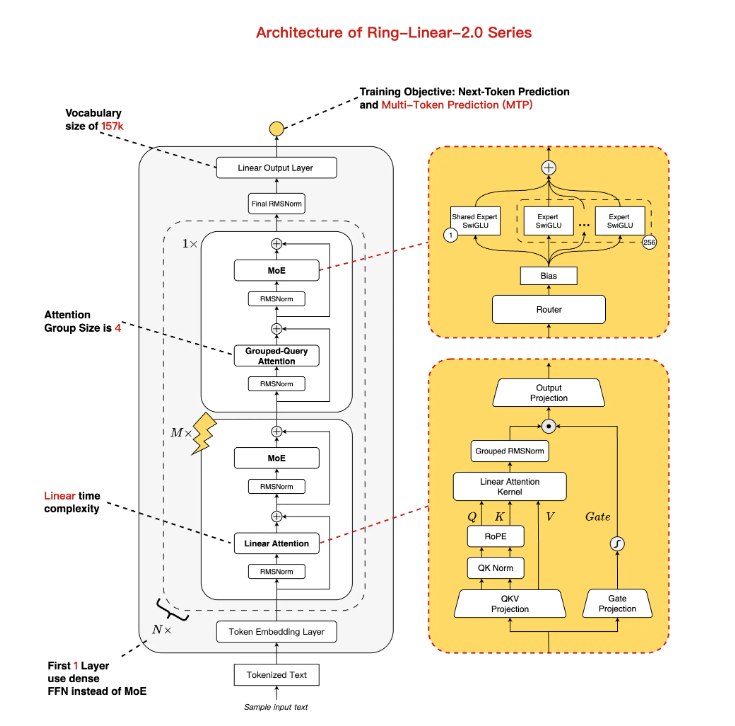

### 创新架构:线性+标准注意力混合 MoE优化平衡性能与效率

Ring-flash-linear-2.0-128K模型是在Ling-flash-base-2.0基础上进行深度迭代升级的产物,其总参数规模达到104B。通过采用1/32专家激活比率和多任务处理层(MTP)等创新优化技术,该模型在实际应用中仅需激活6.1B参数(其中非嵌入参数为4.8B),却能够实现近线性时间复杂度和常量空间复杂度的优异表现。其核心创新点在于混合注意力机制设计:模型主干采用自研线性注意力融合模块,同时辅以少量标准注意力模块,这种组合专为长序列计算场景进行了特别优化。与传统模型相比,该架构在H20硬件平台上支持128K上下文窗口下200+ tokens/s的生成速度,日常使用效率提升超过3倍,特别适合资源受限的应用场景。

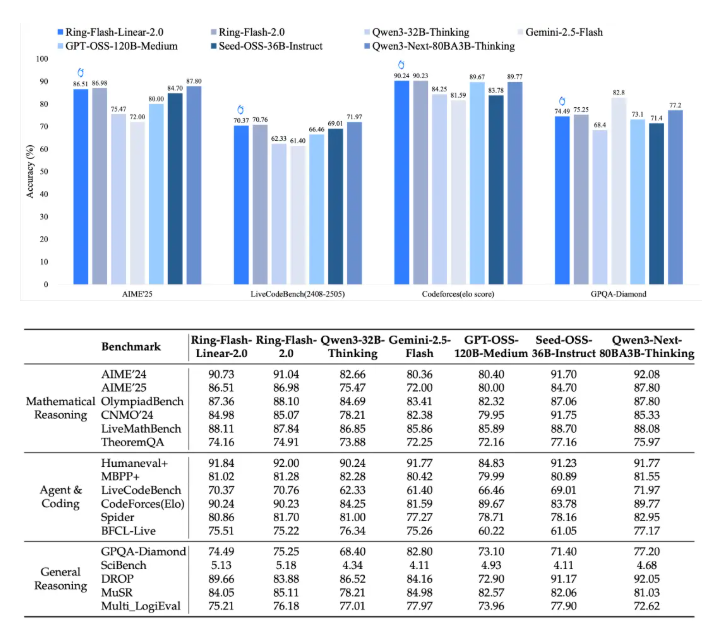

### 训练升级:1T令牌额外微调+RL稳定,复杂推理能力跃升SOTA

该SOTA级模型从Ling-flash-base-2.0转换而来,进一步在额外1T高质量令牌数据集上进行了深度微调,并结合稳定监督微调(SFT)和多阶段强化学习(RL)技术,成功攻克了MoE架构在长链推理训练中普遍存在的稳定性难题。得益于蚂蚁自研的”棒冰(icepop)”算法,该模型在高难度任务中展现出令人瞩目的稳定性:在AIME2025数学竞赛中取得86.98的高分,CodeForces编程Elo评分达到90.23,同时在逻辑推理与创意写作v3等测试中均超越了40B以下的所有密集模型(如Qwen3-32B)。基准测试结果表明,该模型不仅能够匹敌标准注意力模型(如Ring-flash-2.0),还在多项开源MoE/Dense模型中脱颖而出,成为行业标杆。

### 长上下文黑科技:原生128K+YaRN扩展至512K,长输入输出零卡顿

针对编程场景中的典型痛点,Ring-flash-linear-2.0-128K模型原生支持128K上下文窗口,开发者还可以通过YaRN外推技术轻松扩展至512K的更大范围。在长形式输入/输出场景中,预填充(Prefill)阶段吞吐量较Qwen3-32B提升近5倍,解码(Decode)阶段加速效果达10倍。实测数据显示,在32K+上下文编程任务中,模型始终保持高精确度,无”穿模”或漂浮感问题,特别适用于前端开发、结构化代码生成和代理模拟等复杂场景。

### 开源即用:Hugging Face+ModelScope双平台部署,零门槛上手指南

为加速社区落地进程,百灵团队已将模型权重同步开源至Hugging Face与ModelScope两大平台,并支持BF16/FP8格式。开发者只需安装相关依赖,即可通过Transformers、SGLang或vLLM框架一键加载模型:- Hugging Face示例:pip install flash-linear-attention==0.3.2 transformers==4.56.1,加载后可直接使用generate函数处理长代码提示。- vLLM在线推理:在tensor-parallel-size4配置下,GPU利用率高达90%,完美支持API调用。技术报告详见arXiv(https://arxiv.org/abs/2510.19338),开发者可立即下载体验。

### MoE线性注意力时代开启,蚂蚁百灵领跑高效编程AI

此次开源标志着蚂蚁百灵在”MoE+长思维链+RL”技术路线上的重大突破,从Ling2.0系列到Ring-linear,效率提升高达7倍以上。AIbase认为,在成本仅为传统模型1/10的长文本推理浪潮中,该模型将彻底重塑开发者生态:编程小白可以轻松生成复杂脚本,代理系统将变得更加智能,企业级应用部署将实现零门槛。未来,随着Ring-1T万亿级旗舰模型的跟进,国产MoE技术或将主导全球高效AI赛道。

### 结语

Ring-flash-linear-2.0-128K模型以”小激活大性能”的卓越表现,为AI开源领域树立了新范式,为超长编程场景注入了强大动力。开发者们,现在就前往Hugging Face/ModelScope平台体验吧!AIbase将持续追踪该模型的社区迭代动态,为您带来最新技术进展。