近日,中国领先的社交媒体平台微博旗下人工智能部门重磅推出了一款开源的大型语言模型——VibeThinker-1.5B。这款拥有15亿参数的先进模型,是在阿里巴巴尖端研究成果Qwen2.5-Math-1.5B的基础上进行深度优化和精细调整的结晶。VibeThinker-1.5B现已全面登陆Hugging Face、GitHub以及ModelScope等主流开源平台,向全球的研究人员和企业开发者免费开放,并允许在MIT许可证框架下进行商业应用,极大地促进了技术创新与知识共享。

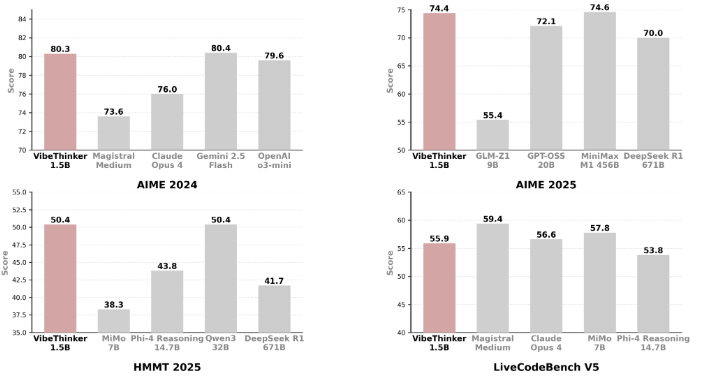

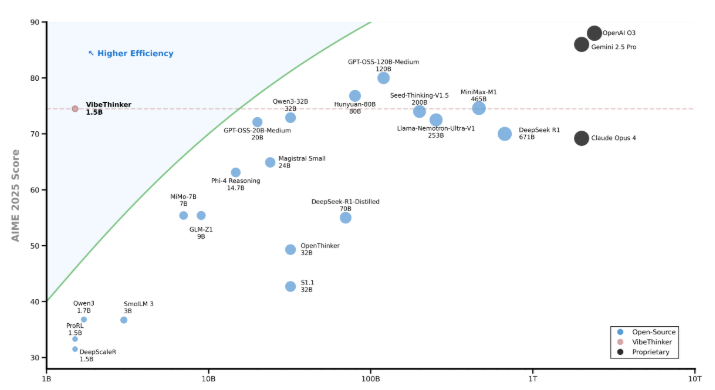

尽管VibeThinker-1.5B的参数规模相对较小,但在数学推理和代码生成等关键任务上却展现出惊人的能力,其推理性能达到了行业顶尖水平,甚至成功超越了参数量高达6710亿的DeepSeek R1模型这一重量级对手。更令人瞩目的是,VibeThinker-1.5B能够在与Mistral AI的Magistral Medium、Anthropic的Claude Opus4以及OpenAI的gpt-oss-20B Medium等多款大型模型同台竞技中脱颖而出,而其所需的基础设施投入和运营成本却要低得多。

VibeThinker-1.5B的后期训练成本仅为7800美元,这一数字与同类或更大规模模型动辄数十万甚至数百万美元的成本形成了鲜明对比,充分彰显了其高性价比和经济效益。大型语言模型的训练过程通常分为两个关键阶段:预训练和后期训练。预训练阶段,模型通过海量文本数据学习语言结构和积累通用知识;而后期训练则聚焦于使用更精炼的高质量数据集,进一步提升模型在提供帮助、执行推理以及与人类期望保持一致等方面的能力。

VibeThinker-1.5B创新性地采用了“谱-信号原则”(Spectrum-to-Signal Principle,SSP)的训练框架,将监督微调和强化学习巧妙地分为两个阶段。第一阶段强调训练数据的多样性,为模型探索广阔的推理空间奠定基础;第二阶段则通过强化学习技术对最优路径进行精准优化,使得即使是参数量较小的小模型也能高效地挖掘推理潜力,最终实现信号的有效放大。在多个领域的严格性能测试中,VibeThinker-1.5B的表现均超越了众多大型开源模型和商业模型,充分证明了小型模型在特定任务中也能创造卓越成就的可能性。

VibeThinker-1.5B开放源代码的发布,不仅打破了传统观念中对模型参数规模和计算强度的固有认知,更向业界展示了小型模型在特定领域实现突破性进展的无限潜力,为人工智能技术的普及和发展注入了新的活力。huggingface:https://huggingface.co/WeiboAI/VibeThinker-1.5B

划重点:📊 VibeThinker-1.5B是微博推出的15亿参数开源AI模型,在多项任务中表现出色,甚至超越部分大型模型。 💰 该模型后期训练成本仅为7800美元,远低于行业平均水平,展现出极高的经济性。 🔍 采用创新的“谱-信号原则”训练框架,有效提升了小模型的推理能力,打破了规模限制的壁垒。