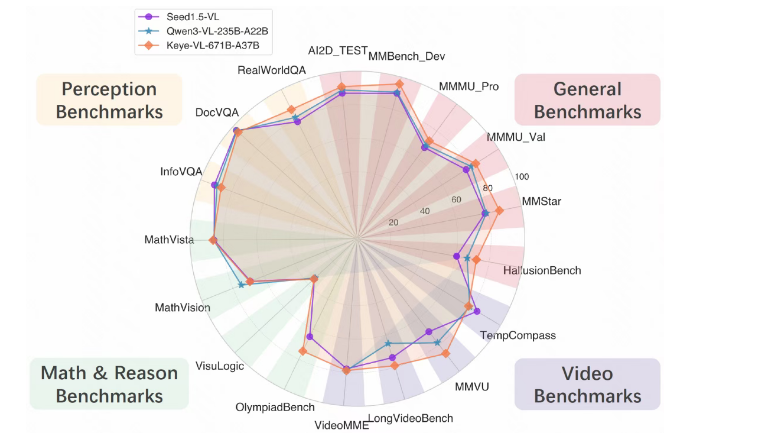

快手重磅发布新一代旗舰多模态模型Keye-VL-671B-A37B,并同步开源代码,标志着公司在人工智能领域的技术实力再攀新高峰。这款模型凭借其卓越的“善看会想”能力,在通用视觉理解、视频分析及数学推理等多项核心benchmark测试中表现惊艳,充分展现了快手在AI领域的深厚积累与创新实力。

Keye-VL-671B-A37B的设计理念聚焦于实现更高层次的多模态理解与复杂推理能力。该模型在基础模型的强大通用能力之上,针对视觉感知、跨模态对齐及复杂推理链路进行了系统性升级,显著提升了在各种场景下的响应准确性和稳定性。无论是日常应用还是高难度任务,Keye-VL-671B-A37B都能提供更为精准可靠的结果。

在技术架构方面,Keye-VL-671B-A37B采用DeepSeek-V3-Terminus作为大语言模型基座,通过MLP层与视觉模型KeyeViT相连接。其中KeyeViT基于Keye-VL-1.5进行初始化,形成了强大的视觉理解能力。模型的预训练过程分为三个阶段,系统性地构建其多模态理解与推理能力。通过严格筛选的300B高质量预训练数据,Keye-VL-671B-A37B在确保视觉理解能力扎实的同时,有效控制了计算成本。

具体训练流程包括四个关键步骤:首先冻结视觉与语言模型参数进行初步对齐训练,接着开放全部参数进行全面预训练,随后在更高质量的数据上进行退火训练,最后通过强化学习优化模型性能。这一系列训练过程显著提升了模型的细粒度感知能力。此外,模型的后训练过程涵盖监督微调、冷启动和强化学习等步骤,训练任务涵盖视觉问答、图表理解、富文本OCR等多个领域。

快手表示,未来Keye-VL将持续提升基础模型能力,同时进一步融合多模态Agent能力,向更“会用工具、能解复杂问题”的智能形态发展。模型的多轮工具调用能力将被强化,使其在实际任务中能够自主调用外部工具,完成复杂的搜索、推理和信息整合。此外,Keye-VL还将在“think with image”和“think with video”等关键方向上深入探索,使模型不仅能理解图像与视频,还能围绕这些内容进行深度思考与链式推理。

通过基础能力与Agent能力的双轮驱动,快手的Keye-VL目标是不断拓展多模态智能的上限,迈向更通用、更可靠和更强推理能力的下一代多模态系统。这一创新将为多模态AI的发展带来新的机遇与挑战,推动整个行业迈向更高水平的技术突破。