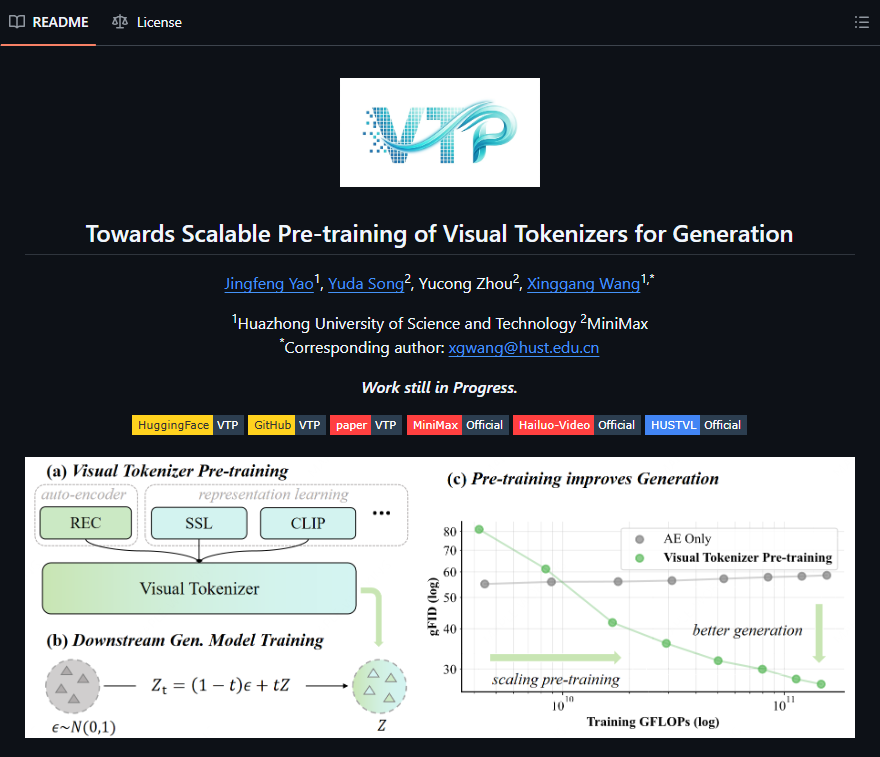

AI视觉生成领域迎来颠覆性技术革新。MiniMax与华中科技大学联合宣布开源其核心突破技术——VTP(Visual Tokenizer Pretraining,视觉分词器预训练),这一成果彻底改变了行业对性能提升的认知。在不触碰标准DiT(Diffusion Transformer)架构的前提下,仅通过优化视觉分词器这一关键组件,VTP实现了65.8%的端到端图像生成性能飞跃,将视觉分词器技术推向全新高度。这一创新首次证明,性能提升并非只能依靠堆砌大模型,而是可以通过优化核心”翻译官”实现倍增效果。

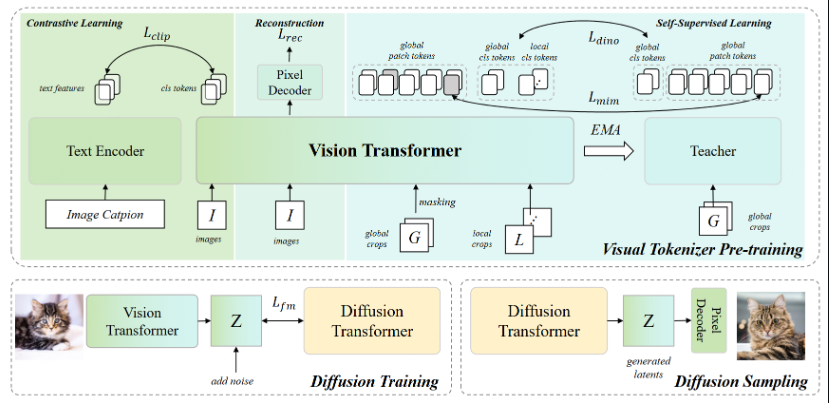

传统生成模型如DALL·E3、Stable Diffusion3主要依赖扩展主干网络提升性能,而VTP开创性地将视觉分词器——负责将图像转化为离散token序列的”视觉翻译官”——作为突破关键。其核心优势在于无需修改DiT的任何训练流程或结构,仅在预训练阶段对分词器进行针对性优化。通过使分词器输出的latent表征更易学习、更具通用性,VTP让下游DiT模型”事半功倍”。实验数据显示,在相同DiT配置下,采用VTP的系统在FID、CLIP Score等关键指标上显著超越基线模型。

VTP的突破不仅限于工程优化,更建立了全新的理论框架:首次明确建立了latent表征易学性与通用视觉表征能力之间的关联;首次证实分词器本身具备可扩展性,随着分词器容量、训练数据与预训练策略的增强,生成性能呈现清晰的scaling曲线;为行业开辟了”模型之外的性能增长路径”,未来或无需盲目扩大DiT参数,而是可通过优化分词器实现更高性价比的性能跃升。

目前,VTP代码、预训练分词器及训练配方已全面开源,完全兼容主流DiT实现。这意味着任何使用DiT架构的研究者或企业,均可”即插即用”VTP,以极低成本获得近70%的生成质量提升,尤其对算力有限的中小团队意义重大。AIbase认为,VTP的发布标志着AI生成技术进入”系统级优化”新阶段。当行业从”唯大模型论”转向”全链路协同提效”,MiniMax与华中科大的这次合作不仅是一次技术胜利,更是对”高效AI”发展理念的有力践行——真正的创新,往往不在于制造更大的引擎,而在于让每个零件都更聪明地协同工作。

代码:https://github.com/MiniMax-AI/VTP

论文:https://arxiv.org/abs/2512.13687v1