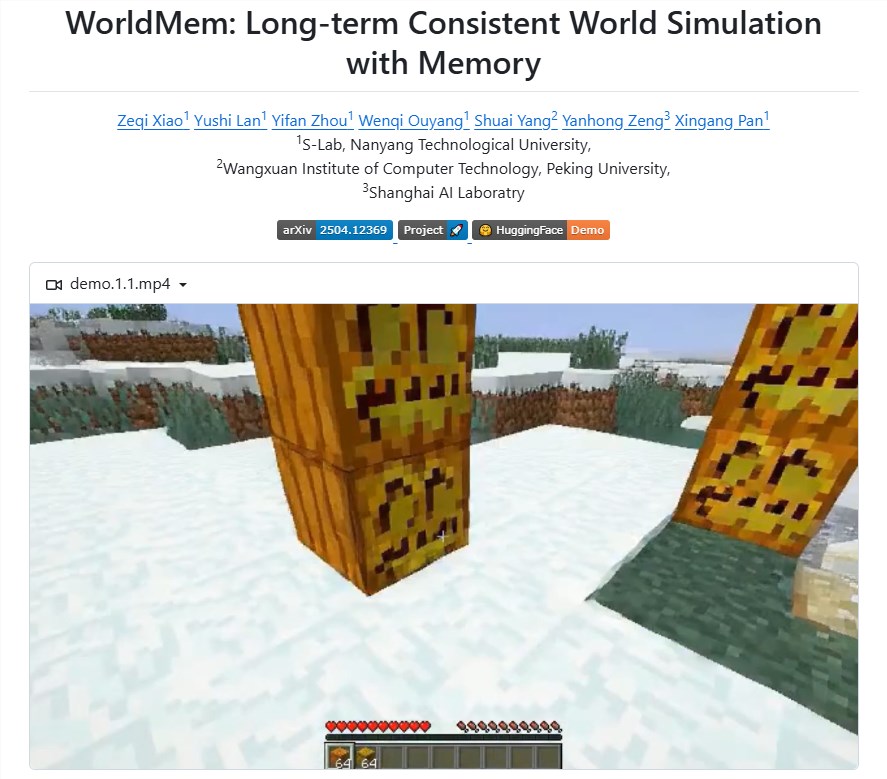

近日,南洋理工大学、北京大学王选计算机技术研究所与上海人工智能实验室的科研团队联合宣布开源了名为“WORLDMEM”的创新长记忆世界模型。这一突破性成果专为解决虚拟环境中长期一致性难题而设计,尤其在视角转换或时间流逝等复杂场景下,仍能保持3D空间的连贯性,从而为用户带来显著优化的沉浸式体验。

WORLDMEM的核心突破在于其独创的记忆机制。该机制构建了一个由多个记忆单元组成的存储库,每个单元都精确记录了特定时间点的场景信息和状态数据。通过这一高效架构,模型能够从过往观察中提取关键信息,并在视角或时间发生改变时精准重建场景。这种创新方法彻底突破了传统方法受限于短时间上下文窗口的瓶颈,实现了环境细节的长期保留与呈现。

在场景生成过程中,WORLDMEM的记忆机制能够从庞大的记忆库中快速检索与当前场景最匹配的信息。这一复杂过程涉及精密的推理与匹配算法,确保提取的信息与当前时间、视角和场景状态高度契合。例如,当虚拟角色在环境中移动后返回原位置时,模型能迅速定位先前的记忆帧,从而实现场景的无缝衔接与高度一致性。更值得一提的是,WORLDMEM具备动态更新能力,随着虚拟世界的发展,新的场景和信息会持续被添加到记忆库中。这一特性不仅保证了模型对最新环境状态的准确记录,更显著提升了场景生成的整体质量。

该模型采用了基于条件扩散变换器的先进架构,能够有效整合外部动作信号,实现虚拟世界的第一人称视角生成。这使得虚拟角色可以在环境中自由移动和互动,增强了用户的参与感。WORLDMEM还运用了扩散强迫技术进行训练,使其能够在时间维度上进行长期模拟。这种训练方式不仅确保了场景生成的连贯性,更使模型能够灵活应对各种动作指令和场景变化。通过将动作信号投影到嵌入空间,并结合去噪时间步嵌入,模型显著提升了对动作信号的响应能力,进一步优化了虚拟体验。

WORLDMEM的发布标志着虚拟环境模拟技术迈入了一个全新阶段,为未来虚拟现实应用的发展提供了强大的技术支撑。这一开源项目将推动整个行业在虚拟环境构建方面的创新,为用户带来更加真实、连贯的沉浸式体验。

开源地址:https://github.com/xizaoqu/WorldMem

划重点:

? WORLDMEM是一个开源的长记忆世界模型,致力于提升虚拟环境中的一致性和连贯性

? 模型的核心记忆机制能够高效存储和提取场景信息,突破传统方法的限制

? WORLDMEM具备动态更新能力,随着环境变化持续优化场景生成质量