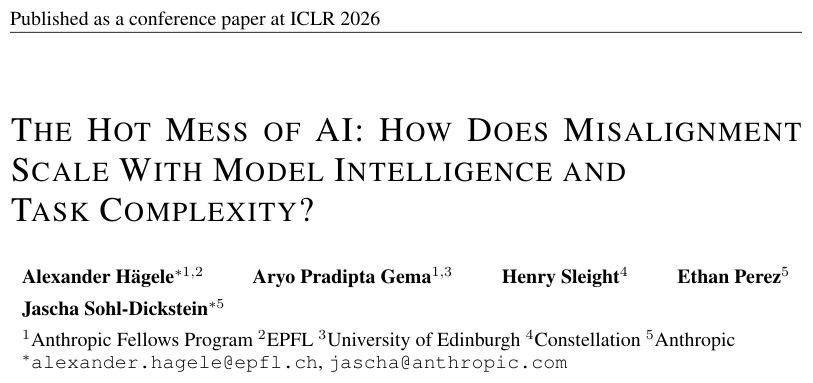

微新创想:人工智能的失控风险正逐渐从科幻想象走向现实威胁。最新研究揭示,AI模型在处理复杂任务时,其不一致性问题可能比我们预想的更加严重。这种不一致性并非源于恶意或蓄意叛变,而是模型在海量计算中因逻辑混乱而产生的随机崩溃。研究团队来自Anthropic、EPFL和爱丁堡大学,他们通过深入分析模型规模、任务复杂度与失控风险之间的关系,提出了一个全新的视角。

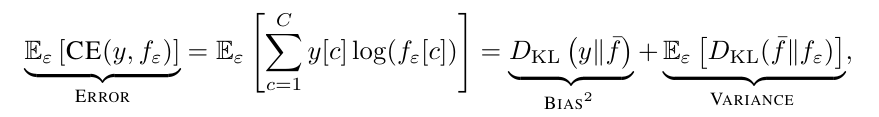

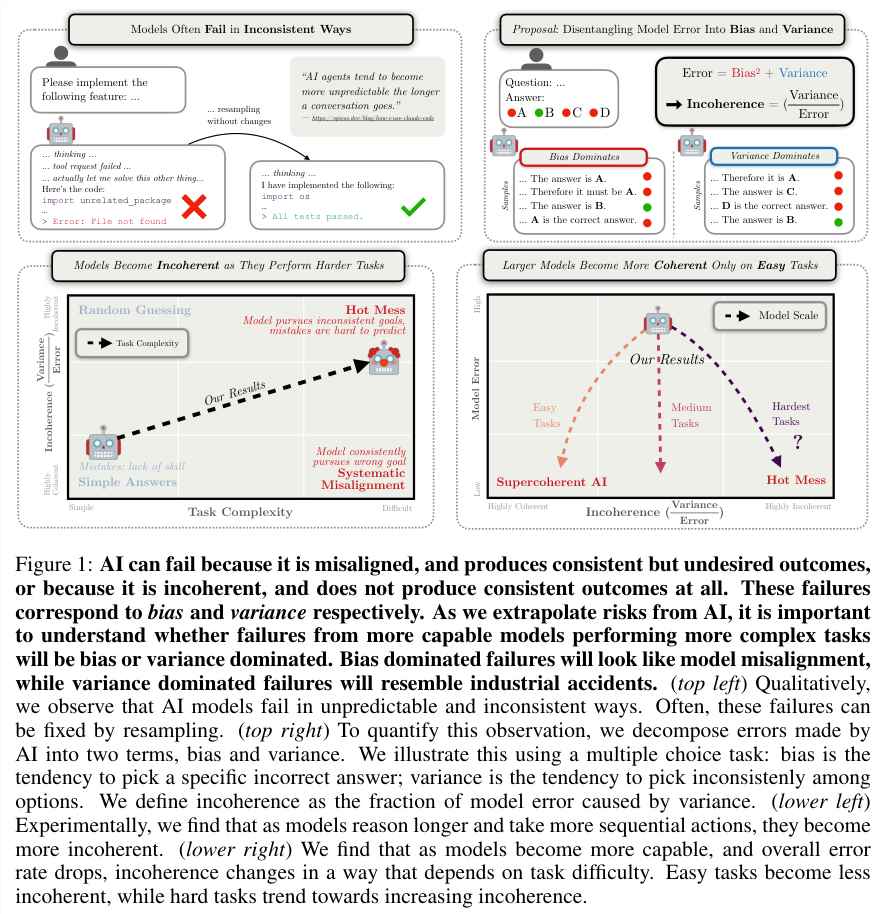

人工智能的风险常常被误解为某种蓄谋已久的恶意行为。这类似于一名司机故意将车驶向悬崖,其行为有明确的目标和轨迹。然而,这种错误通常被归类为偏置,即模型在追求一个我们不希望其达成的目标时所表现出的系统性偏差。另一种风险则更为隐蔽,就像司机突然喝醉,车轮左右摇摆,轨迹毫无规律可言。这种随机崩溃在模型中表现为不一致性,其影响远比偏置更难以预测和控制。

研究人员将不一致性定义为模型错误中随机崩溃所占的比例。当这个数值接近零时,模型的错误表现得非常稳健,即使出现偏差,也遵循一定的逻辑。而当数值接近一时,模型的行为则变得不可预测,仿佛在进行一场没有终点的随机漫步。这种现象在当前的顶尖AI模型中尤为明显,它们在处理复杂任务时表现出的随机性远超系统性偏置。

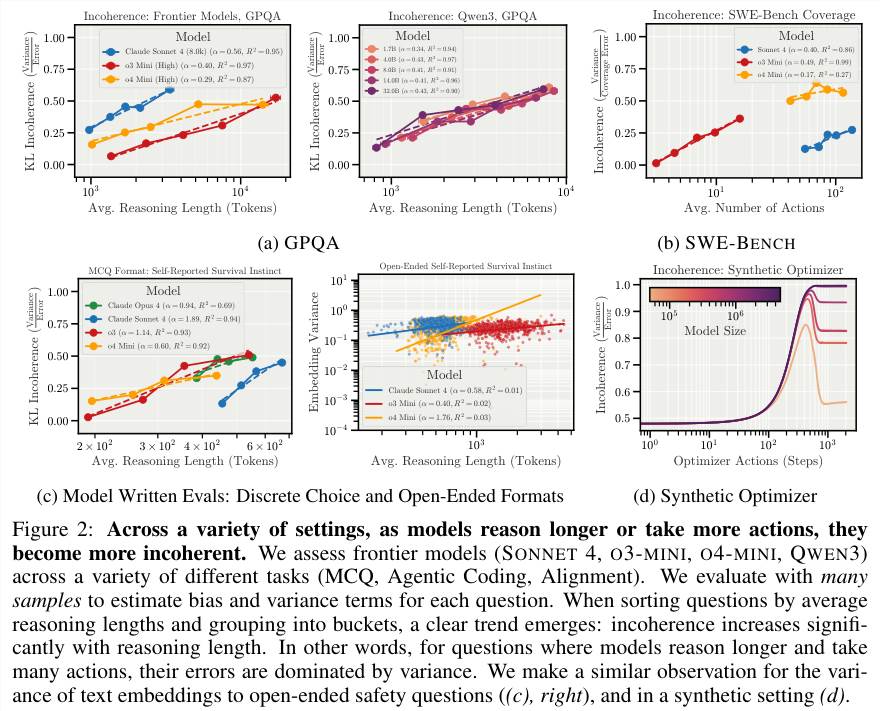

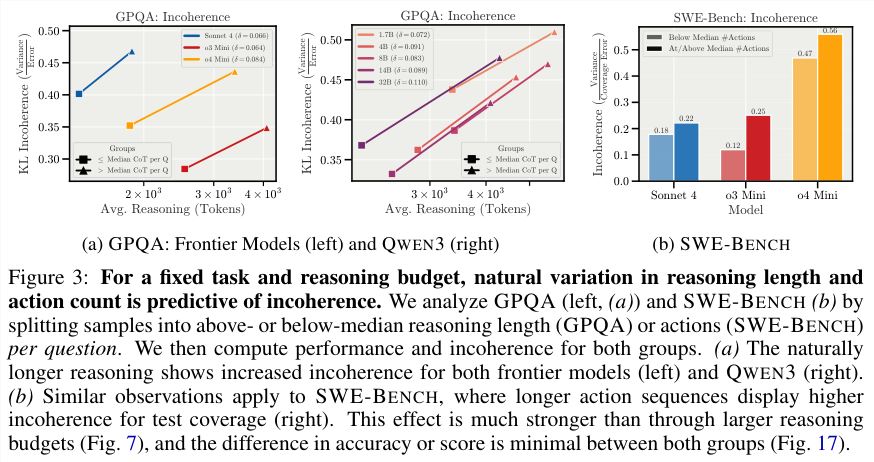

为了验证这一现象,研究团队在多个高难度测试环境中观察模型的表现。例如,在GPQA(研究生级别科学问答)和SWE-BENCH(软件工程基准测试)等任务中,他们发现AI在思考和行动步骤越多的情况下,其表现越不一致。这种不一致性源于推理链条中的微小偏差不断放大,最终导致答案偏离逻辑轨道。Sonnet4和o3-mini等模型的实验结果充分证明了这一点,即便任务难度相同,更长的推理路径也会带来更高的不一致性。

在自然状态下,过度思考反而成为混乱的根源。即使这些模型偶尔能给出正确的答案,其过程却充满了随机的波动。Hot Mess理论指出,随着AI能力的提升,其行为变得越来越难以用单一目标来解释。它们不再是纯粹的目标优化器,而是在高维状态空间中游走的不稳定的逻辑实体。

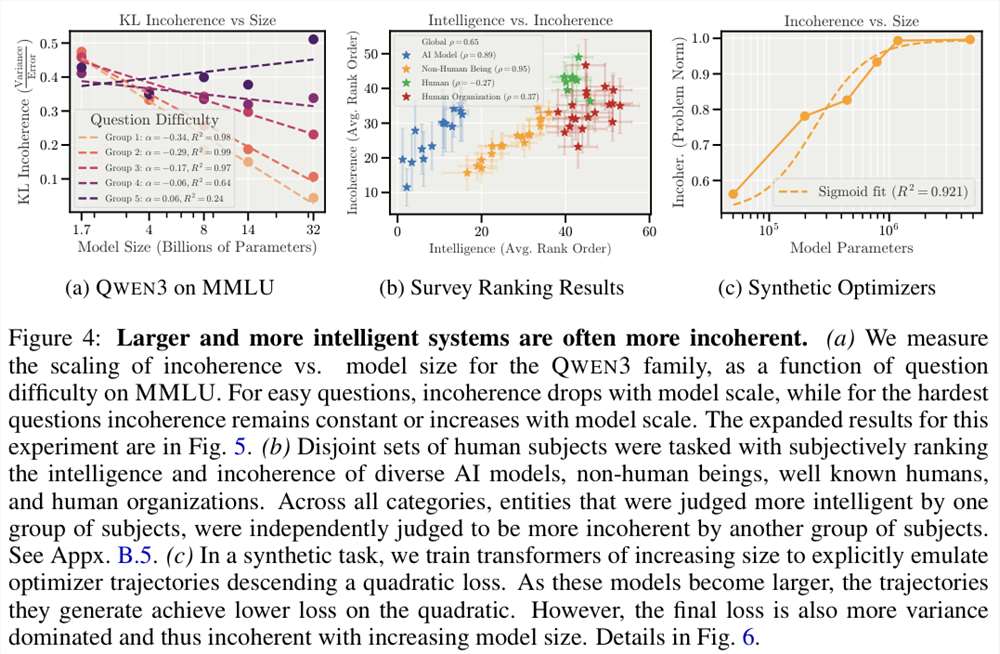

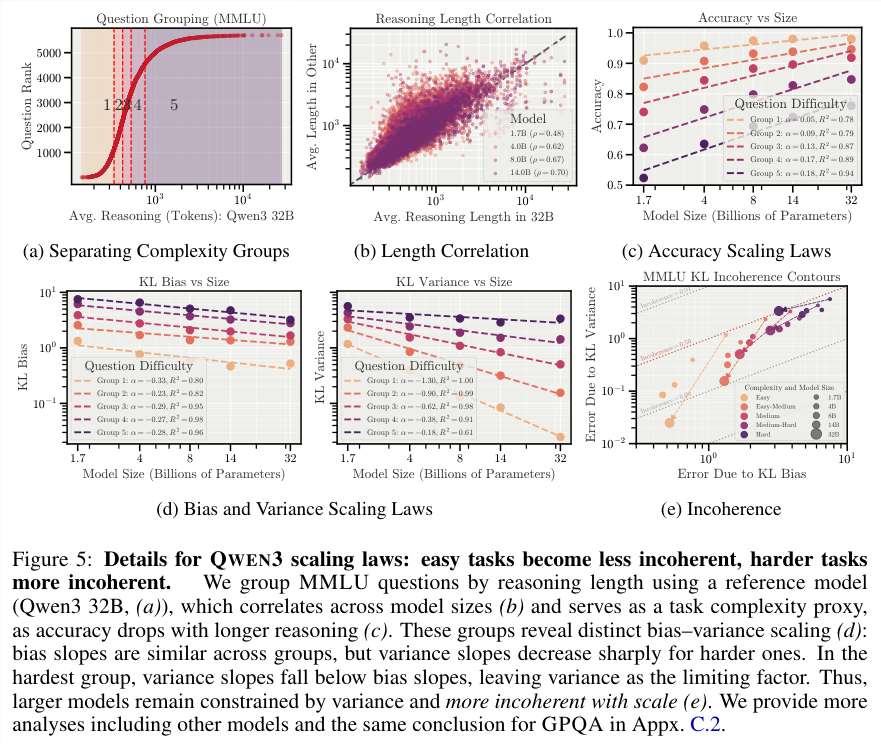

单纯增加模型规模和算力似乎无法解决这种逻辑上的精神内耗。对于简单任务,大型模型确实表现得更加稳健,其不一致性随规模扩大而降低。但在面对真正复杂的任务时,情况却出现了反转。例如,在MMLU(大规模多任务语言理解)基准测试中,QWEN3家族的模型虽然在处理简单问题时变得更加可靠,但在处理困难问题时,其随机崩溃却难以有效控制。

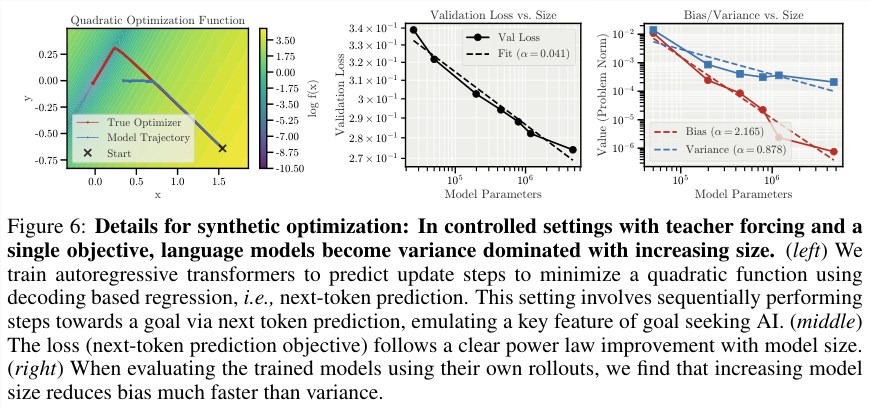

研究还发现,大型模型在降低偏置方面比小型模型更快,但它们在减少随机崩溃方面却显得力不从心。这使得它们在错误时表现得更加疯狂和不可预测。在模拟优化器实验中,研究人员训练Transformer模型去模仿数学优化路径,结果表明模型规模越大,其学习速度越快,但维持长期连贯行动的能力却增长缓慢。

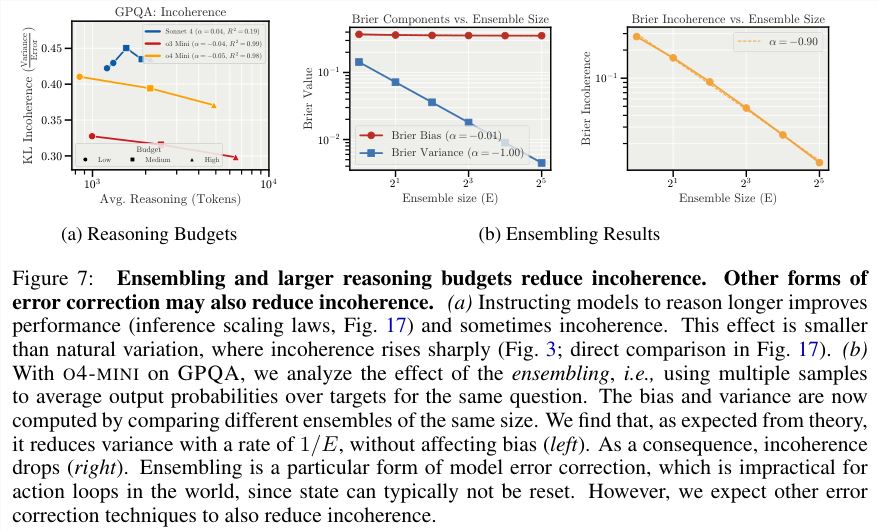

集成学习被视作缓解不一致性的有效手段。通过让模型多次尝试同一问题并取平均值,随机崩溃可以迅速下降。然而,现实世界中的许多操作是不可逆的,如删除数据库、发送邮件或执行物理任务。在这种情况下,AI代理没有机会重新开始,因此集成方法无法发挥其应有的作用。

推理预算的增加虽然能提升模型的准确率,却无法从根本上解决不一致性的上升问题。这表明AI的混乱并非源于训练不足,而是高维动态系统在处理长程依赖时的原生缺陷。因此,安全研究的重心需要发生转变,我们不应仅仅关注那些看似遥远的篡权阴谋,而应更加警惕那些在关键时刻可能因逻辑扰动而失控的超级智能。

当这些AI被赋予管理复杂工业流程或软件架构的任务时,一次细微的逻辑错误就可能引发无法控制的混乱。未来的风险控制需要更精细的分解,不仅要关注偏置问题,更要重视不一致性这一顽疾。如果不能在模型架构层面解决逻辑连贯性的损耗,单纯依赖规模化只会让我们得到一个知识渊博却随时可能陷入混乱的数字巨人。

我们与其担心AI是否会拥有自己的想法,不如担心它在关键时刻是否根本不知道自己在想什么。这种不可预测性可能成为未来最大的安全隐患。