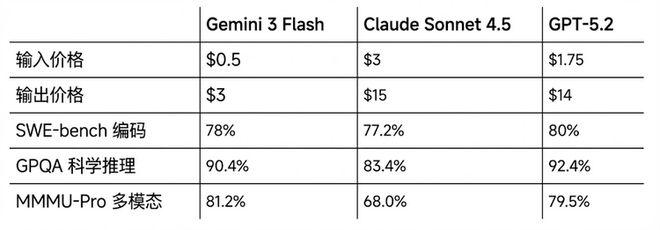

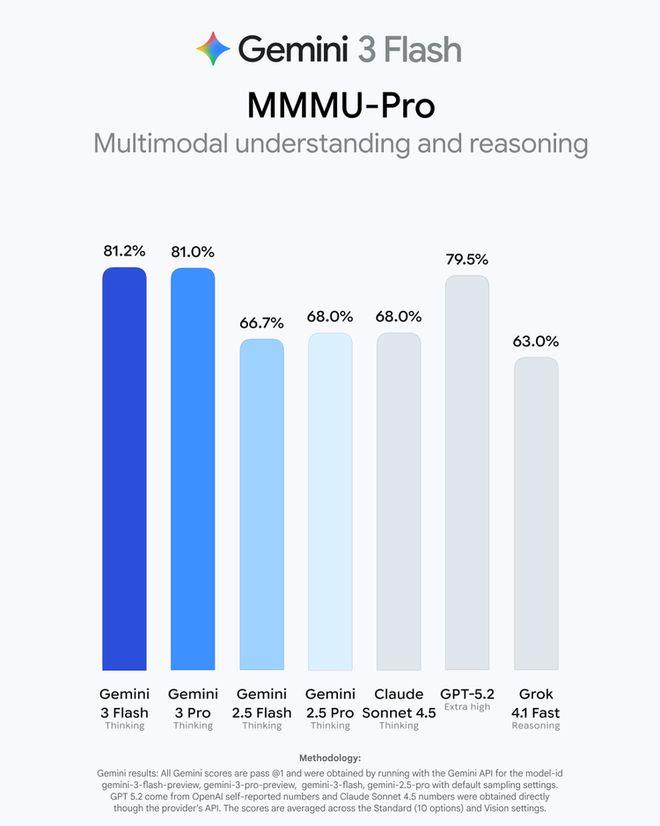

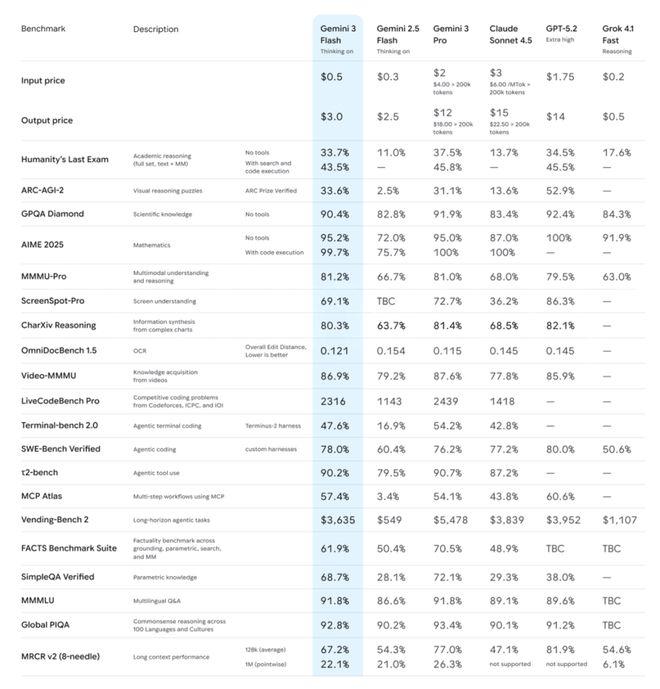

Google于12月17日正式发布了Gemini3Flash,一款定价仅为Claude1/5、GPT1/4的”轻量模型”。尽管体型小巧,其性能却令人惊叹:在编码能力上超越了Claude Sonnet4.5,而在推理和多模态处理方面更是全面碾压GPT-5.2,甚至在某些测试中与之互有胜负。更令人震惊的是,根据MMMU-Pro多模态评估效果,Gemini3Flash的表现甚至超过了自家的旗舰模型Gemini3Pro,以78%的成绩反超Pro的76.2%。这不仅是Flash系列诞生以来首次超越同代Pro模型,更彰显了其强大的技术实力。

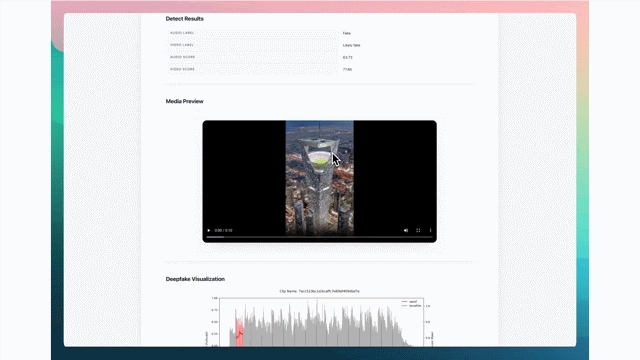

让我们直观感受一下Gemini3Flash的神奇之处:只需一句话,它就能生成完整的3D程序化房间动画;配合Resemble AI技术,可实现实时分析deepfake视频,将复杂的音视频取证数据转化为普通人易于理解的分析结果。在测试中,其多模态分析速度比2.5Pro快了整整4倍,能够在不影响关键工作流的前提下高效处理原始技术数据。

一个月前,Gemini3Pro和Deep Think的发布让Google重新夺回AI第一梯队的位置。Gemini3Pro登顶LMArena,Deep Think在ARC-AGI上创造了其他模型三倍的惊人成绩。发布以来,Gemini API日均处理量更是突破1万亿tokens。如今,Gemini3Flash的到来,终于补齐了Gemini3家族的最后一块拼图。

但这次的Gemini3Flash与以往截然不同。过去我们对Flash的认知十分清晰:速度快、价格便宜,但能力有所妥协。想要速度,就必须接受智能上的让步。然而Gemini3Flash彻底打破了这一常规,它以轻量模型的价格,却打出了旗舰级的能力。1/5的价格,凭什么能打出台阶?让我们深入探究。

在与其他模型的对比中,Gemini3Flash的表现堪称惊艳。在博士级科学推理基准GPQA Diamond上,它以90.4%的成绩大幅领先Claude Sonnet4.5的83.4%,甚至接近GPT-5.2的92.4%。在多模态理解基准MMMU-Pro上,Flash以81.2%的成绩超越了GPT-5.2的79.5%,更是将Claude Sonnet4.5甩开十几个百分点。在人类最后考试 Humanity’s Last Exam上(无工具模式),Gemini3Flash以33.7%的成绩遥遥领先Claude Sonnet4.5的13.7%,差距接近20个百分点。

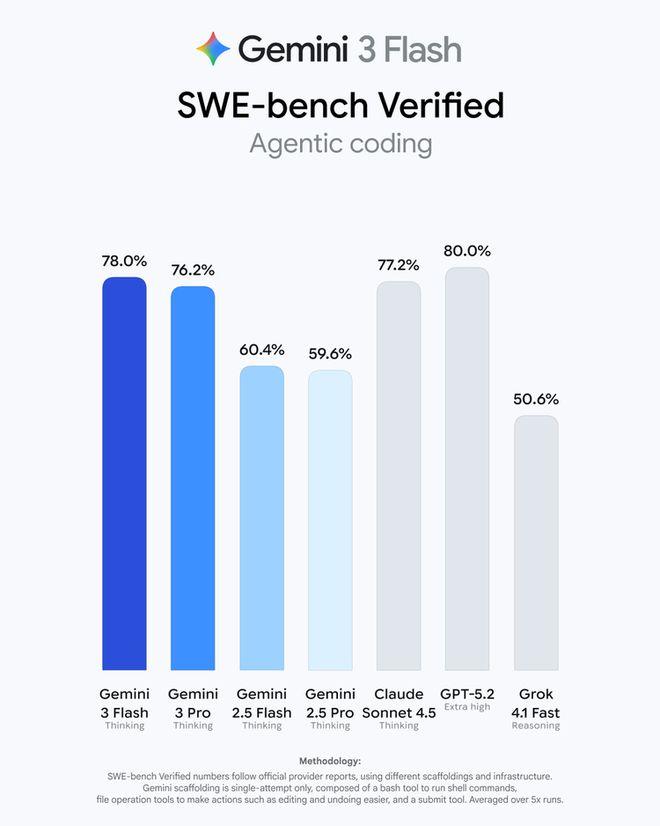

编码能力同样不容小觑。在SWE-bench Verified上,Gemini3Flash以78%的成绩超过了Claude Sonnet4.5的77.2%,更值得一提的是,这是Flash系列首次超越自家3Pro的76.2%。当我们将价格因素纳入考量,这种反差就更加明显了:Flash的价格大约是Claude的1/5、GPT的1/4,却在多项关键指标上打平甚至领先。

如果说以前选择Flash意味着在速度、省钱和智能之间做出妥协,那么现在选择Flash则意味着既省钱又省心。那么一个问题自然浮现:既然如此强大,Gemini3Pro还有什么用?Google给出的答案是:Pro适用于极限推理场景,而Flash则更适合高频agent任务。Pro拥有Deep Think模式,适合需要深度推理的场景;而Flash则在效率、成本和速度上达到了最佳平衡。

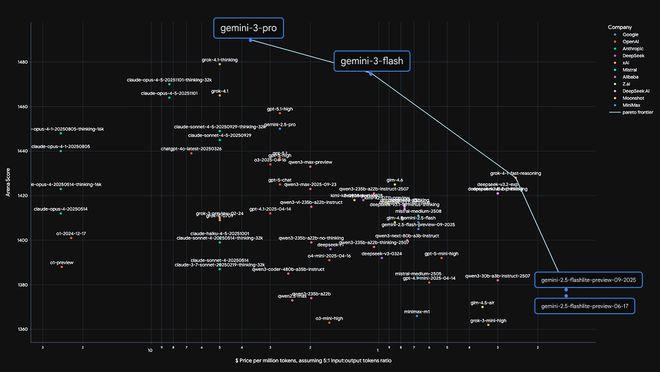

在效率层面,Gemini3Flash同样表现出色。根据Artificial Analysis的测试,Gemini3Flash比2.5Pro快3倍,处理日常任务时平均节省30%的token消耗。在定价方面,输入成本为$0.50/百万tokens,输出成本为$3/百万tokens,仅为3Pro的四分之一。可以说,Gemini3Flash在性能、成本与速度的权衡关系上,将最优边界推进到了新的高度。

Google官方宣称:”速度和规模,不必以牺牲智能为代价。”放在以前的Flash上可能只是句口号,但这次发布的数据有力地证明了这一点。

Gemini3Flash的发布不仅是API层面的升级,它还将直接改变普通用户的日常体验。在Gemini App里,Gemini3Flash将替代原来的2.5Flash,成为新的默认模型。这意味着全球所有的Gemini用户,包括免费用户,都将自动升级到Gemini3级别的体验,无需付费,无需任何设置。升级后的App将提供三种模式供用户选择:基础模式、专业模式和极限模式,满足不同用户的需求。

在Google Search里,AI Mode的默认模型也将在全球范围内升级到3Flash。Google表示,得益于3Flash强大的推理和多模态能力,AI Mode现在能更精准地理解用户意图,处理更复杂、更具多重约束条件的问题,同时生成结构清晰、易于消化的回答。对于美国用户,Google还开放了更多选项,可以在AI Mode里选择”Thinking with3Pro”来获得更深度的帮助,图像生成模型Nano Banana Pro也向更多美国用户开放了。

对于普通用户来说,这可能是感知最明显的一次升级。你打开Gemini,它已经是前沿级别的模型了;你在Google Search里问复杂问题,背后跑的是一个融入了顶级大模型能力的引擎。换句话说,免费用户现在用的默认模型,能力已经不输其他家的付费旗舰。

对于开发者而言,Gemini3Flash更是带来了革命性的变化。以前做agentic应用,想用旗舰级模型就得付旗舰级价格。Gemini3Flash彻底改变了这一局面。过去开发者面临两难选择:要么用快但笨的小模型,牺牲任务完成质量;要么用聪明但慢且贵的大模型,面对延迟和成本的双重压力。尤其是在需要多轮调用、高频迭代的agent场景里,这个取舍几乎是绑死的。Gemini3Flash提供了一个全新的选项:足够快、足够聪明、成本可控。

在SWE-bench上78%的成绩说明它完全有能力处理复杂的编码任务,同时3倍于2.5Pro的速度让它能胜任对延迟敏感的实时场景,而1/5于竞品的价格让大规模部署成为可能。目前,Gemini3Flash已经在以下平台上线(preview):Google Cloud Platform、Google AI Studio和Gemini API。

在高频调用场景,Google还提供了配套的成本优化方案。Context Caching功能可以在重复token使用达到一定阈值时降低90%的成本;Batch API支持异步批量处理,成本可以再降50%,同时提供更高的调用配额。对于那些需要在生产环境里大规模跑agent任务的团队,这套组合拳相当有吸引力。

Flash的含义彻底改变了。Gemini3Flash的发布,某种程度上重新定义了”Flash”这个品类的含义。Flash,终于不只是快速和效率的代名词了。过去,Flash或者说轻量级模型的定位非常明确:用能力换取速度和成本优势。你选择Flash,就意味着接受它在智能上的折扣。但Gemini3Flash证明了另一种可能:当底层的基础模型足够强大时,轻量版本不一定要做太多能力阉割,它可以只是”更高效的满配版”。

Google在博客里提到,Gemini3Flash的核心模型能力已经强到一个程度:在很多任务上,关掉思考模式的3Flash,比开着思考模式的2.5版本表现还好。以前你需要牺牲速度来换准确,现在不用了。

这次发布也让Gemini3家族阵容正式成型:Gemini3Pro、Gemini3Deep Think、Gemini3Flash三个版本,覆盖了从轻度用户到硬核开发者的完整需求谱系。想要极致推理深度,用Deep Think;想要最强综合能力,用Pro;想要又快又好还便宜,用Flash。各取所需,不再是单选题。

从数据来看,Google在AI产品化这条路上跑得相当稳。Gemini App的月活已经突破6.5亿,开发者数量达到1300万,API调用量同比增长3倍。上季度到这季度,用户数从4.5亿猛增到6.5亿。目前,普通用户可以直接在Gemini App和Google Search的AI Mode中体验新模型;开发者可以通过Google AI Studio和Gemini API开始构建应用。

当Google用Flash模型1/5的价格打出旗舰级能力,Flash这个品类的想象空间被彻底打开了。