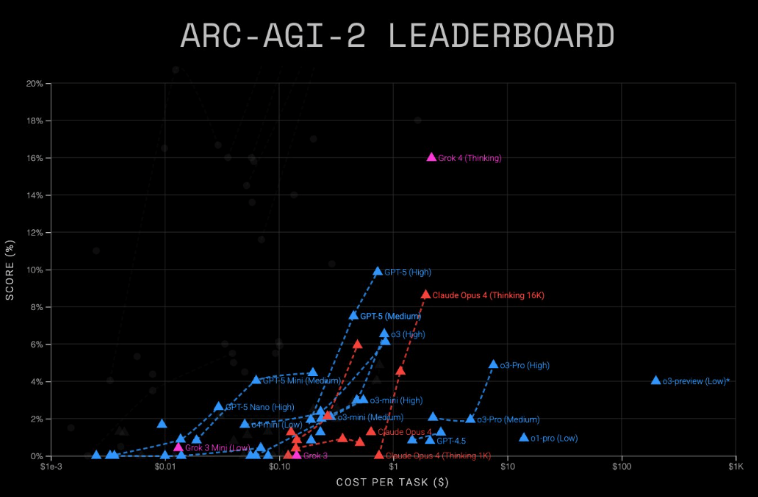

最新发布的 ARC 奖测试结果揭示了主流 AI 模型在性能与成本方面的显著差异。在评估模型通用推理能力的 ARC-AGI-2 基准测试中,GPT-5(高级版)以 9.9% 的得分表现突出,每项任务成本仅为 0.73 美元。相比之下,Grokh4(思考型模型)虽然准确率高达 16%,但成本却高达每项任务 2 至 4 美元。这一数据表明,尽管 Grokh4 在复杂推理任务上表现更优,但其成本效益远不及 GPT-5。ARC-AGI 基准测试全面比较了领先语言模型的性能与成本表现。

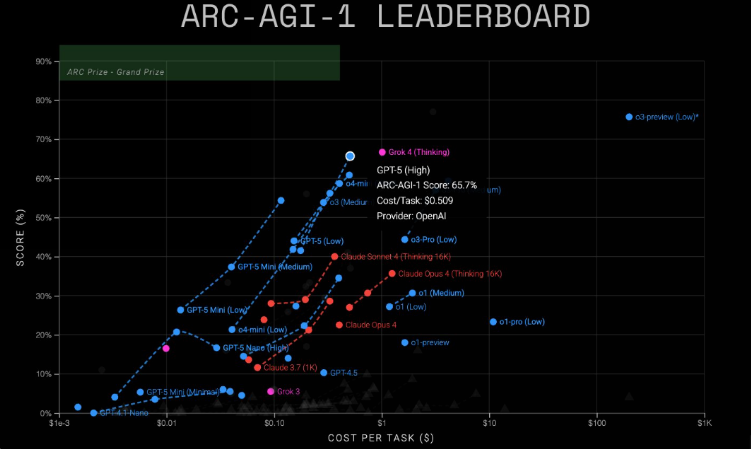

在要求相对较低的 ARC-AGI-1 测试中,Grokh4 再次展现出优势,以 68% 的准确率领先于 GPT-5 的 65.7%。然而,尽管 Grokh4 的准确率更高,其每项任务约 1 美元的成本远超 GPT-5 的 0.51 美元,使得 GPT-5 在此测试中更具性价比。值得注意的是,xAI 公司仍有可能通过价格调整来缩小这一成本差距。此外,报告还特别提及了 GPT-5 的轻量级版本。GPT-5Mini 在 AGI-1 和 AGI-2 上的得分分别为 54.3% 和 4.4%,成本分别为 0.12 美元和 0.20 美元。而更小巧的 GPT-5Nano 在 AGI-1 上达到 16.5%(0.03 美元),在 AGI-2 上达到 2.5%(0.03 美元)。

在 ARC-AGI-1 测试中,于 2024 年 12 月发布的 o3-preview 模型表现惊人,以接近 80% 的准确率遥遥领先,但其成本远超其他竞争者。尽管 OpenAI 在其 GPT-5 演示中并未提及 ARC 奖,但据 The Information 报道,该公司可能为了适应后续的聊天版本而大幅削减了 o3-preview 的能力。

除了上述基准测试,ARC-AGI-3 也正在进行中。该测试要求模型在类似游戏的交互环境中通过反复试验来解决任务。尽管人类可以轻松应对,但大多数 AI 代理在视觉益智游戏中仍然面临挑战。这一测试进一步揭示了当前 AI 技术在复杂交互环境中的局限性。