谷歌近期推出了一款名为 BlenderFusion 的创新框架,旨在革新3D 视觉编辑与生成合成的技术领域。这一全新工具的问世,精准契合了当前图像生成领域的迫切需求,尤其是在处理复杂场景方面展现出卓越潜力。传统的生成对抗网络和扩散模型虽然能在整体图像生成上取得显著成效,但在对多个视觉元素进行精确控制时却显得力不从心。BlenderFusion 的横空出世,为这一技术瓶颈提供了突破性的解决方案。

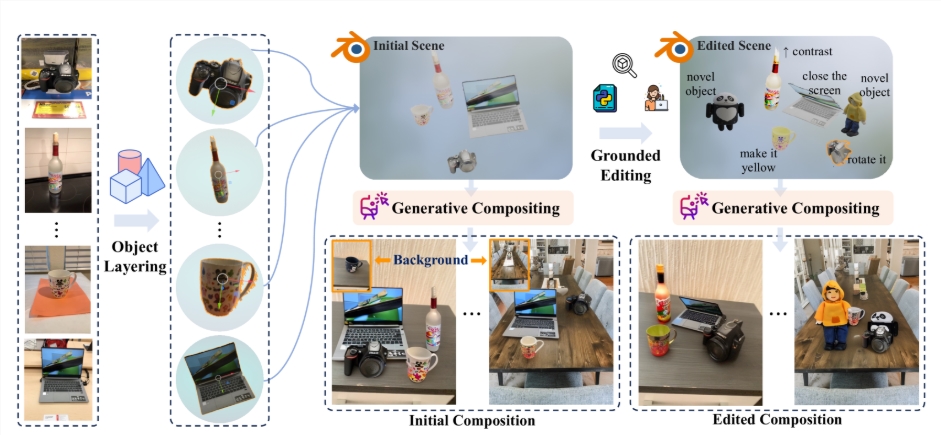

BlenderFusion 的工作流程设计巧妙,主要分为三个核心阶段:分层、编辑和合成。首先进入分层阶段,BlenderFusion 能够从输入的2D图像中智能提取可编辑的3D对象。研究团队巧妙地融合了SAM2、DepthPro等多种前沿视觉基础模型,通过这些模型的强大识别能力,系统能够精准生成物体的3D点云数据,为后续编辑工作奠定坚实基础。进入编辑阶段后,BlenderFusion 充分释放了Blender的专业功能优势。用户可以对导入的3D实体进行全方位操作,包括移动、旋转、缩放等基础变换,甚至还能对物体的外观材质进行精细到像素级的调整。这一过程让用户能够如同处理数字积木般灵活操控场景中的每个元素,确保每次编辑都能实时反映在最终的渲染效果中。最后在合成阶段,BlenderFusion 将经过精心编辑的3D场景与背景无缝融合,生成令人惊叹的最终图像。这一阶段依赖于经过优化的强大生成合成器,能够智能整合来自不同输入的细节信息,确保最终效果既高质量又保持场景连贯性。研究团队通过创新性地改进现有扩散模型,使其能够高效整合编辑与源场景信息,从而大幅提升合成效果的质量和艺术表现力。

通过 BlenderFusion,谷歌不仅彰显了其在3D视觉编辑领域的技术领导力,更为广大创作者提供了一套前所未有的创作工具,让复杂的视觉任务变得前所未有的直观和高效。这一框架的推出,必将为设计师、艺术家和开发者们的工作流程带来革命性的便利。项目官网:https://blenderfusion.github.io/

? BlenderFusion 集成了先进的3D 编辑工具与扩散模型,实现了高效的3D 视觉编辑与生成合成,为创意表达开辟了新维度。?️ 该框架的工作流程包括分层、编辑和合成三个阶段,用户可以像操作实体模型一样方便地编辑3D 对象并生成最终图像,极大降低了技术门槛。? 谷歌的 BlenderFusion 通过持续优化模型算法,显著提升了对复杂场景的处理能力,让设计师能够更精准地实现天马行空的创意构想,推动数字内容创作进入全新纪元。