9月18日,大语言模型(LLM)领域迎来历史性突破。DeepSeek团队凭借其关于DeepSeek R1的研究论文,成功登上顶级学术期刊《Nature》封面,成为首个通过权威同行评审的大语言模型。这一里程碑事件不仅彰显了DeepSeek R1的技术创新性,更为整个AI行业树立了新的学术标杆。

《Nature》编辑部特别指出,在AI技术迅猛发展但炒作泛滥的当下,DeepSeek的做法为行业提供了宝贵示范。通过严格的独立同行评审机制,AI研究的透明度和可重复性得到显著提升,有效降低了未经证实的技术声明可能带来的社会风险。编辑们强烈呼吁更多AI企业效仿DeepSeek的严谨态度,共同促进AI领域的健康发展。

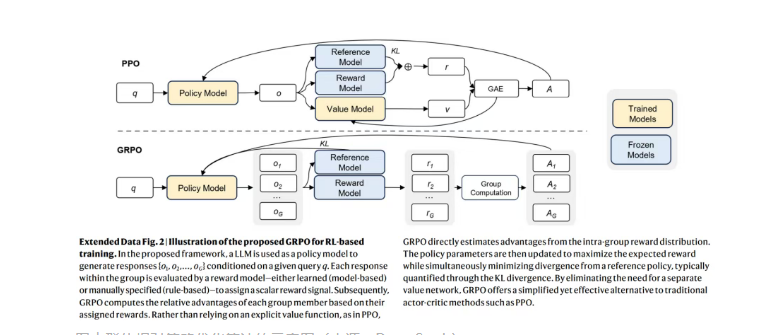

这篇具有突破性的论文详细介绍了DeepSeek R1创新的推理能力训练方法。与传统依赖人工标注进行微调的技术路线不同,DeepSeek R1完全摒弃人工示例,采用强化学习(RL)在自主环境中实现自我演化,从而突破性地发展出复杂推理能力。这种创新方法取得了令人瞩目的成效,例如在AIME2024数学竞赛中,DeepSeek-R1的表现从15.6%大幅跃升至71.0%,达到与OpenAI模型相当的水平。

在长达数月的严格同行评审过程中,八位顶尖专家对该研究提出了宝贵建议,促使DeepSeek团队对技术细节进行了多次迭代优化。尽管研究成果令人瞩目,团队仍坦诚模型在可读性和语言混用等方面仍面临挑战。为解决这些问题,DeepSeek创新性地采用了结合拒绝采样和监督微调的多阶段训练框架,进一步提升了模型的写作能力和整体表现水平。

DeepSeek R1的成功发表标志着AI基础模型研究正在向更科学、更严谨、更可复现的方向迈进。这一突破不仅为未来的AI研究提供了全新范例,更有望推动整个行业走向更加透明和开放的发展道路,为人工智能技术的健康可持续发展奠定坚实基础。