Meta 公司近期发布了一款名为 MobileLLM-R1 的小型推理模型,这一创新举措迅速引发了业界对“小型 AI”在企业应用潜力的高度关注。与以往动辄数百亿甚至数万亿参数规模的人工智能模型不同,MobileLLM-R1 系列展现了小型语言模型(SLMs)的独特魅力,其包含 140M、360M 和 950M 三种参数规模,专门针对数学、编码和科学推理场景进行了深度优化。

长期以来,超大规模 AI 模型在企业应用中面临着诸多现实挑战。庞大的参数规模不仅导致底层系统控制力不足,还加剧了对第三方云服务的依赖,更令人担忧的是其成本往往难以预测。这些痛点促使小型语言模型(SLMs)的发展势头日益强劲,它们凭借成本效益、隐私保护和更强的可控性,正逐渐成为企业 AI 应用的理想选择。

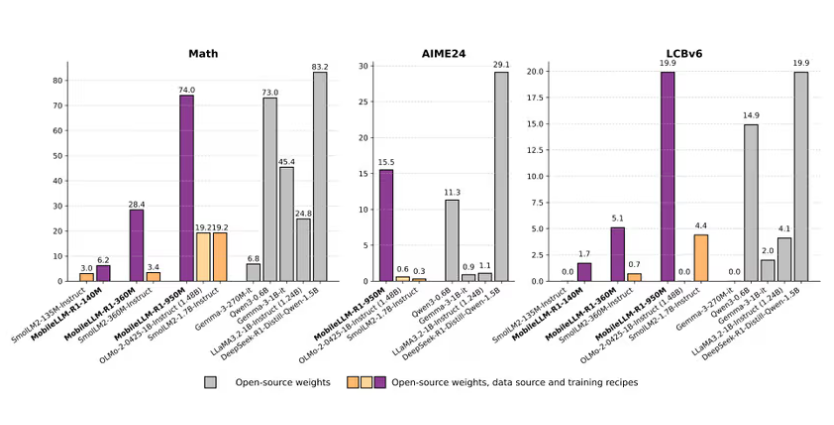

MobileLLM-R1 系列模型的独特之处在于其“深而薄”的架构设计。通过创新的训练方法,这些模型能够在资源受限的设备上高效执行复杂任务。在专业测试中,MobileLLM-R1 在 MATH 基准测试中表现优异,甚至略胜阿里巴巴的 Qwen3-0.6B,尤其是在 LiveCodeBench 编码测试中展现出卓越性能,非常适合作为开发工具中的本地代码助手。

然而需要特别注意的是,MobileLLM-R1 目前仅在 Meta 的 FAIR 非商业许可下发布,明确禁止任何商业用途。这一限制使其更适合作为研究蓝图或企业内部工具,而非直接面向市场的商业化产品。在小型语言模型的竞争格局中,Google 的 Gemma3(270M 参数)凭借其超高效性能和更为宽松的许可证,成为企业定制化应用的理想选择;阿里巴巴的 Qwen3-0.6B 则提供了不受限制的商业使用权;Nvidia 的 Nemotron-Nano 则以独特的控制功能见长,支持开发者根据实际需求灵活调整推理过程。

随着企业对小型模型可控性和经济性的认识不断深化,行业正经历一场向小型专用模型的转型浪潮。越来越多的企业意识到,小型模型能够提供更高的可预测性和隐私保护。这种发展趋势与软件行业向微服务架构转变的思路不谋而合——利用一系列小型专用模型协同工作,共同解决复杂问题。

这一变革并不意味着大型模型的退出,反而预示着它们将在 AI 生态中继续发挥重要作用。通过优化训练数据,大型模型可以为新一代小型模型提供高质量的训练集,从而推动 AI 技术的可持续发展。这一趋势清晰地表明,未来的 AI 发展将更加务实,各大科技巨头正携手迈向更加高效、可持续的 AI 新时代。huggingface:https://huggingface.co/facebook/MobileLLM-R1-950M

划重点:

🌟 **Meta 推出 MobileLLM-R1系列小型推理模型,专注于数学、编码和科学推理。**

🔍 **小型模型在企业应用中提供了成本可控性、隐私保护和高效性能的优势。**

🚀 **行业正在向 “小 AI” 转型,企业更倾向于使用多个小型专用模型来解决复杂问题。**