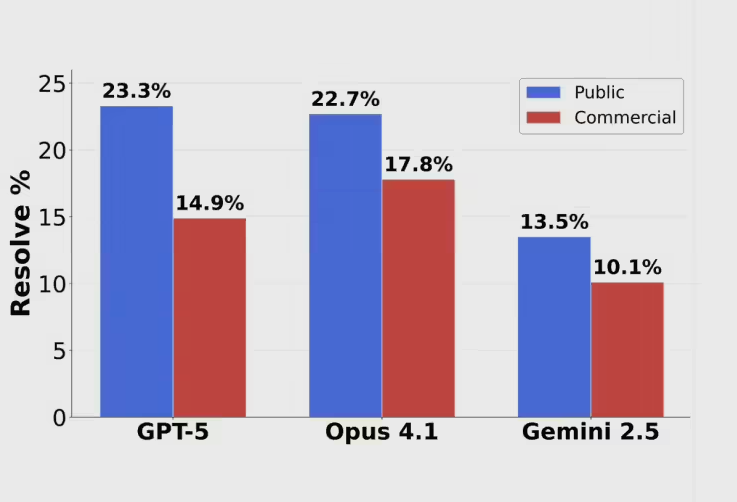

AI领域的三巨头正遭遇前所未有的挫败。当GPT-5、Claude Opus4.1和Gemini2.5这些被誉为人工智能皇冠上的明珠,在Scale AI全新推出的SWE-BENCH PRO编程测评中全军覆没时,整个AI行业的信心受到了沉重打击。这些顶尖模型无一能够突破25%的解决率大关,GPT-5仅取得23.3%的成绩,Claude Opus4.1紧随其后达到22.7%,而Google的Gemini2.5更是跌至13.5%的惨淡表现。这些数字背后隐藏着令人不安的真相:即便是当今最先进的AI模型,在应对真正复杂的编程挑战时依然力不从心。

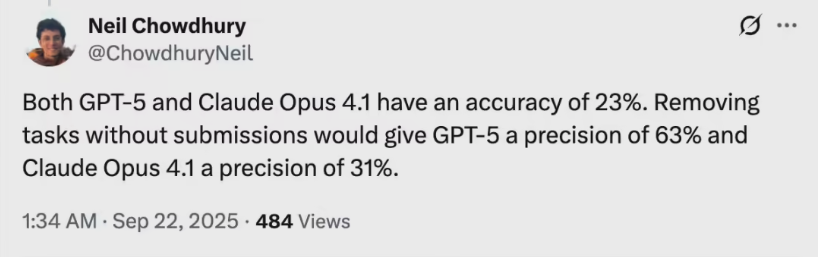

当我们深入探究这场测试背后的真相,会发现比表面现象更加复杂。前OpenAI研究员Neil Chowdhury的深度分析揭示了另一个维度的故事。他发现,GPT-5在尝试解决的任务中,实际准确率高达63%,远超Claude Opus4.1的31%。这意味着,虽然GPT-5在整体表现上看似平庸,但在其擅长的领域内,这个模型仍然保持着强大的竞争优势。

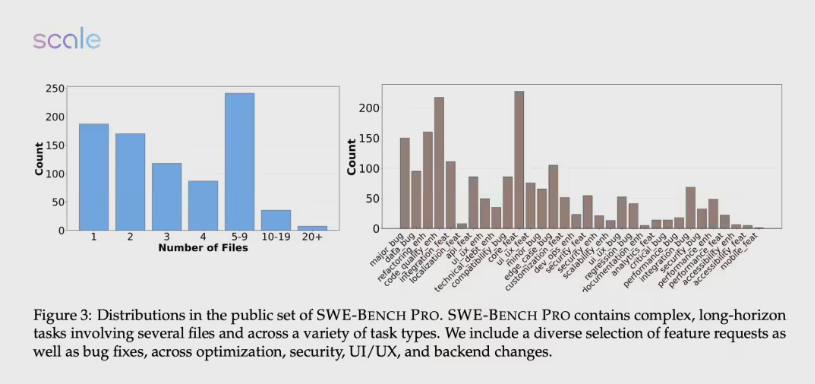

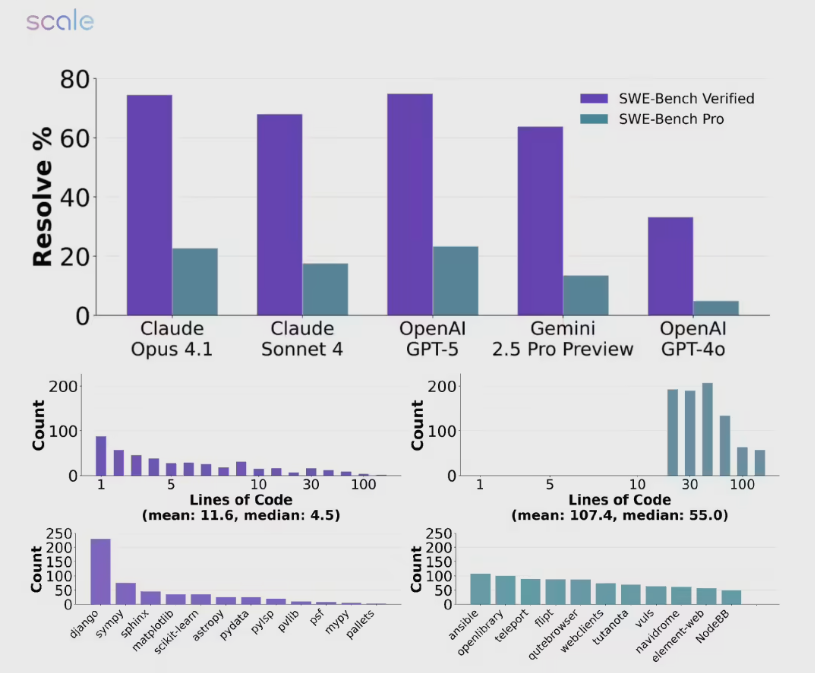

那么,究竟是什么原因导致这些往日的AI霸主在新测试面前纷纷折戟沉沙?答案就隐藏在SWE-BENCH PRO的独特设计理念中。这个由OpenAI在2024年8月精心打造的测试集,就像一把锋利的手术刀,专门用来解剖当前AI模型的真实能力边界。与过去那些动辄70%正确率的SWE-Bench-Verified测试相比,SWE-BENCH PRO的难度提升绝非简单的数字游戏。测试团队刻意规避了可能已被用于模型训练的数据,彻底杜绝了数据污染这一长期困扰AI评测的顽疾。这样做的结果就是,模型们再也无法依靠记忆中的答案来蒙混过关,必须展现出真正的推理和解决问题的能力。

SWE-BENCH PRO的测试范围堪称庞大,涵盖了1865个来自商业应用和开发者工具的真实问题。这些题目被精心分为公共集、商业集和保留集三个层次,确保每一个模型在接受评测时都面临着全新的挑战。更令人印象深刻的是,研究团队还在测试过程中引入了人工增强机制,进一步提升了任务的复杂性和真实性。

测试结果毫不留情地暴露了当前AI模型的软肋。在解决实际商业问题时,这些模型的能力仍然存在明显局限性。特别是在JavaScript和TypeScript等主流编程语言的处理上,各模型的解决率呈现出令人困惑的剧烈波动。研究人员通过深入分析发现,不同模型在理解和处理同类任务时展现出了显著的差异化表现,这种差异背后反映的是各家技术路线和训练策略的根本性分歧。

更加值得关注的是GPT-5高达63.1%的未回答率,这个数字就像一面镜子,清晰地映照出当前AI技术发展的真实状况。即使是最先进的模型,在面对复杂挑战时也经常选择保持沉默,而非冒险给出可能错误的答案。这种谨慎态度虽然在某种程度上体现了模型的自我认知能力,但同时也为整个行业的技术进步敲响了警钟。

这场测试不仅仅是一次简单的技术评估,更像是对整个AI行业发展现状的一次深刻审视。它提醒我们,尽管人工智能在某些领域已经取得了令人瞩目的成就,但在复杂的实际应用场景中,我们仍有很长的路要走。