人工智能公司DeepSeek的研究团队于本周一正式发布了其最新实验模型V3.2-exp,这款模型的核心突破在于创新性地采用了”稀疏注意力”机制,旨在革命性地降低长上下文操作的推理成本。这一具有里程碑意义的成果已在Hugging Face和GitHub平台同步上线,并配有详尽的学术论文作为技术支撑。

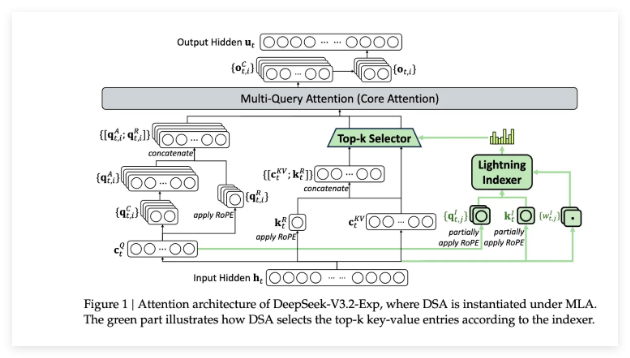

V3.2-exp模型最引人注目的特点是其自主研发的DeepSeek稀疏注意力系统。该复杂机制由两个关键模块协同工作:首先,名为”闪电索引器”的模块能够智能识别并优先排序上下文窗口中的关键信息片段;其次,独立的”细粒度标记选择系统”会从这些高优先级摘录中精准筛选出核心标记,仅将这些重要信息加载到有限的注意力窗口中进行处理。这种创新的机制组合使得模型能够在保持高性能的同时显著降低服务器负载,从而高效处理超长上下文片段。

初步测试结果令人瞩目。DeepSeek官方数据显示,在处理长文本任务时,新模型的API调用成本可降低高达50%。虽然目前仍需更多第三方机构进行独立验证,但考虑到该模型采用开放权重设计并在Hugging Face平台完全免费开放,其真实性能将在不久后得到行业广泛检验。

此次突破是DeepSeek近期一系列解决AI推理成本难题的创新举措之一。与此前专注于降低训练成本的R1模型不同,V3.2-exp着重于提升基础Transformer架构的运行效率,为AI应用的规模化普及提供了更具成本效益的解决方案。推理成本特指部署已训练AI模型的服务器运行费用,而非模型训练投入。

在当前AI技术浪潮中,DeepSeek始终备受瞩目。其早前发布的R1模型凭借创新的低成本强化学习方法曾引发广泛关注。此次稀疏注意力技术的突破虽然可能不会像R1那样产生轰动效应,但为全球AI从业者提供了宝贵的实践经验,将有力推动整个行业共同降低AI服务的运营成本,加速AI技术的商业化进程。