微新创想

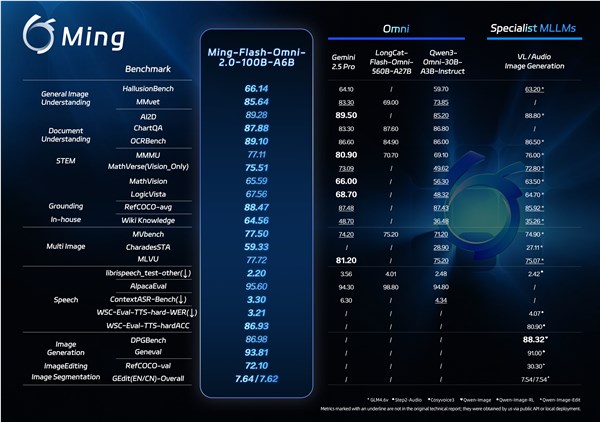

今日,蚂蚁集团正式开源发布全模态大模型 Ming-Flash-Omni 2.0。该模型在多项公开基准测试中展现出卓越的性能,尤其在视觉语言理解、语音可控生成、图像生成与编辑等关键领域表现突出,部分指标甚至超越了 Gemini 2.5 Pro,成为当前开源全模态大模型中的性能新标杆。Ming-Flash-Omni 2.0 作为业界首个全场景音频统一生成模型,能够在一个音轨中同时生成语音、环境音效与背景音乐,极大提升了音频生成的灵活性和实用性。

用户只需通过自然语言下达指令,即可对音色、语速、语调、音量、情绪与方言等进行精细控制。这种高度定制化的音频生成能力,使得模型在实际应用中更具优势。此外,Ming-Flash-Omni 2.0 在推理阶段实现了 3.1Hz 的极低推理帧率,支持分钟级长音频的实时高保真生成,不仅提升了处理效率,也在成本控制方面保持了业界领先水平。

蚂蚁集团在全模态大模型领域已深耕多年,Ming-Omni 系列经历了多次迭代,逐步完善了多模态处理能力。此次开源 Ming-Flash-Omni 2.0,标志着蚂蚁集团将核心能力以“可复用底座”的形式对外释放,为开发者提供统一的能力入口,助力构建端到端的多模态应用。这一举措不仅推动了技术共享,也为行业创新提供了坚实的基础。

Ming-Flash-Omni 2.0 基于 Ling-2.0 架构(MoE,100B-A6B)进行训练,围绕“看得更准、听得更细、生成更稳”三大目标进行全面优化。在视觉处理方面,模型融合了亿级细粒度数据,并采用难例训练策略,显著提升了对近缘动植物、工艺细节和稀有文物等复杂对象的识别能力。这使得模型在处理高精度视觉任务时更加得心应手。

在音频处理方面,Ming-Flash-Omni 2.0 实现了语音、音效与音乐的同轨生成,支持用户通过自然语言对音色、语速、情绪等参数进行精细控制。同时,模型还具备零样本音色克隆与定制能力,能够快速适应不同声音需求,满足多样化的应用场景。这种强大的音频生成与控制能力,为内容创作和交互体验带来了全新可能。

在图像生成与编辑领域,Ming-Flash-Omni 2.0 通过增强复杂编辑的稳定性,支持光影调整、场景替换、人物姿态优化及一键修图等功能。即使在动态场景中,模型也能保持画面的连贯性与细节的真实性,为图像处理提供了更高的精度与效率。这些优化使得模型在实际应用中更加稳定可靠,能够应对各种复杂的图像生成需求。

目前,Ming-Flash-Omni 2.0 的模型权重与推理代码已在多个开源社区发布,用户可以自由下载和使用。同时,蚂蚁百灵官方平台 Ling Studio 也提供了在线体验与调用服务,方便开发者快速上手并探索模型的潜力。这一开源行动不仅促进了技术的普及,也为行业生态的构建注入了新的活力。