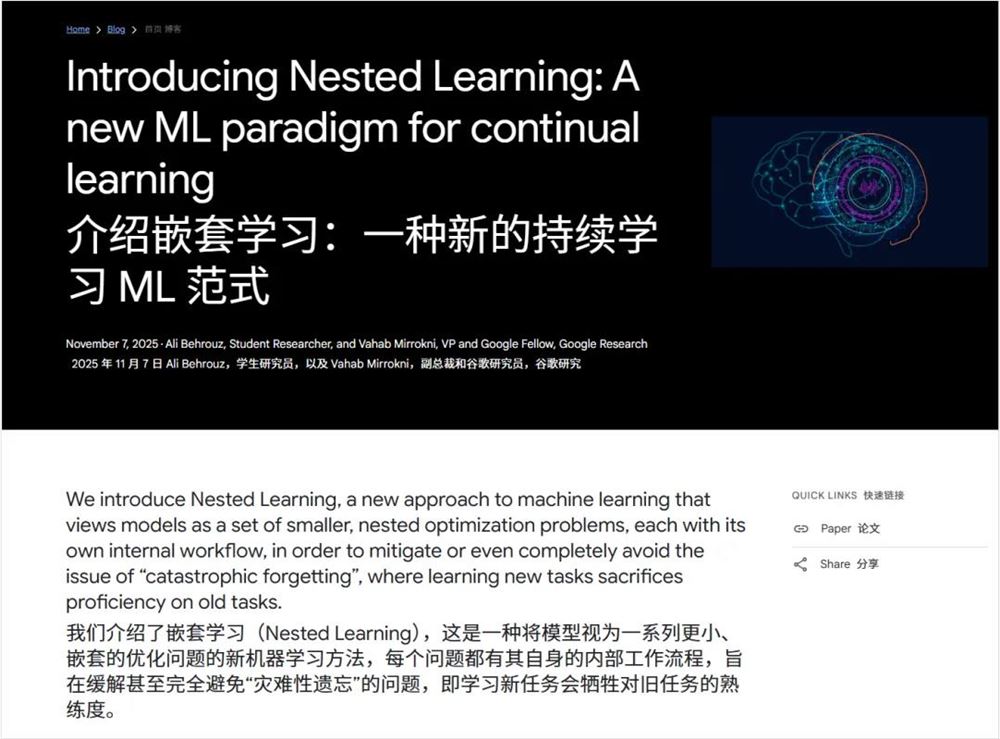

声明:本文源自微信公众号数字生命卡兹克,作者数字生命卡兹克,经站长之家授权转载发布。近日,谷歌发布了一篇极具启发性的论文《Nested Learning: The Illusion of Deep Learning Architectures》,引发广泛关注。这篇论文被戏称为《Attention is all you need(V2)》,而后者作为神作,其提出的Transformer架构已成为GPT、Gemini、Claude、Qwen、DeepSeek等所有大型模型的基石。2017年发表的《Attention is all you need》,引用量已突破17万次,位列21世纪被引用次数最多的论文前十,被誉为现代AI的奠基之作。如今,大模型发展遭遇瓶颈,急需突破性方法,而《Nested Learning》应运而生。有趣的是,两篇论文均出自Google Research,遥相呼应。读完这篇论文后,我深感收获颇丰,其深度与美感不亚于DeepSeek-OCR的论文。以下我将用通俗易懂的语言,解析这篇论文的核心内容及其潜在影响力。

要理解《Nested Learning》的突破性,首先需认识当前大模型的致命缺陷——顺行性遗忘症。人脑最强大的能力并非计算速度,而是记忆持久性与智慧。神经科学研究表明,记忆分阶段巩固,白天学习的内容先在海马体形成草稿,夜间通过脑波反复回放,最终转化为长期记忆。睡眠不足会损害记忆力,而顺行性遗忘症患者则无法形成新长期记忆,生活被困在短暂的循环中,如同诺兰电影《记忆碎片》的主角。大模型虽拥有海量知识,但本质上是”记忆碎片”的主角,其参数仅冻结在预训练结束时的状态,无法形成真正的新记忆。每次对话都是与全新AI的互动,无法从交流中成长,也无法固化经验。需强调的是,此处讨论的是模型层面的缺陷,而非ChatGPT等工程层面的记忆功能。

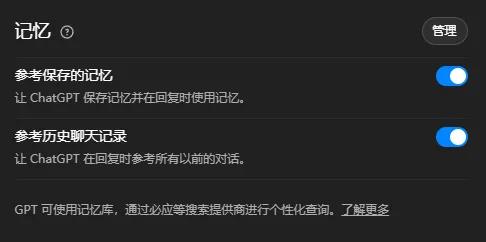

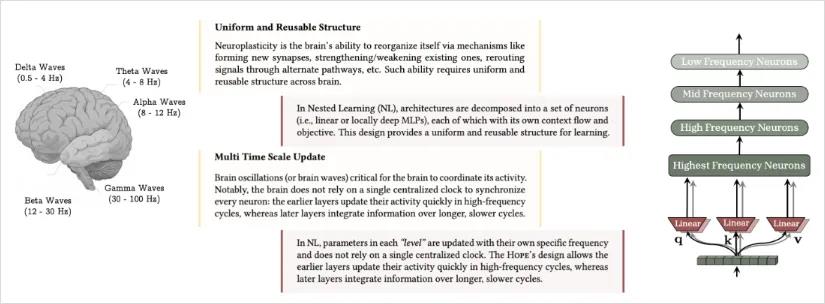

《Nested Learning》正是针对这一根本问题提出解决方案。论文关注人脑多频率协同工作的特性,不同脑电波对应不同神经元功能。以学车为例:高频系统是肌肉记忆,中频系统是战术决策,低频系统是战略规划,最低频系统则是核心驾驶能力的重塑。人类学习天然具有嵌套性,不同频率系统分工协作。而现有Transformer架构本质上是单频系统,训练后参数固定,无法持续学习。HOPE模块创新性地结合了自我修改权重的序列模型和多时间尺度连续记忆带,实现带自我更新机制的记忆单元,将AI明确分层,高频层处理临时记忆,中频层形成概要记忆,低频层整合长期记忆,模拟人脑的巩固机制。白天积累的短期记忆,夜间通过”offline consolidation”筛选写入皮层,形成长期记忆。嵌套学习赋予AI类似的能力,使其成为可持续学习的存在。

有人质疑ChatGPT的记忆功能,但那本质是检索增强生成(RAG),将信息存入外部数据库,而非重塑核心模型。就像随身带笔记本,而非将知识内化。嵌套学习则通过互动数据微调神经网络参数,如同钢琴家将乐谱融入肌肉记忆,实现真正的理解与直觉。现有记忆是行为模拟,嵌套学习则是结构成长,将知识转化为智慧。这正是这篇论文令人兴奋的原因,预示着未来真正的AI形态——懂你的个人助理,无需重复个人信息,能记住你的偏好与经历,互动越多越了解你。论文评测显示,HOPE在多项指标上超越Transformer++、RetNet等模型,证明这一路径可行。

万物皆嵌套,从细胞到文明,每一层都有独特韵律。人类几百万年进化出的学习机制可能蕴含着AI发展的钥匙。AI或许不应另起炉灶,而应谦卑模仿这种嵌套的、多层次的智慧。当AI学会遗忘、沉淀、巩固记忆、保持思考时,它才真正接近智能的幻觉,甚至拥有灵魂的雏形。这条道路漫长,但前景令人激动。