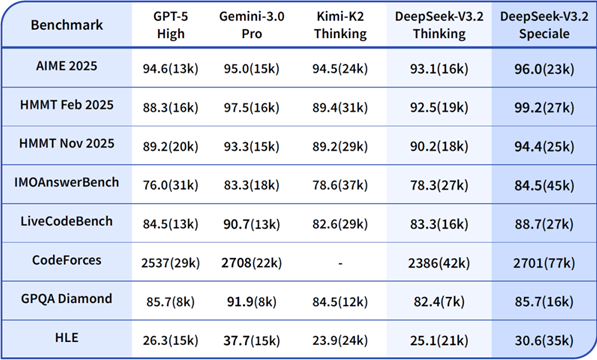

DeepSeek 正式推出 V3.2 标准版与 V3.2-Speciale(深度思考版)两款创新模型,官方评测结果揭示了其卓越性能与突破性进展。在128k上下文场景中,V3.2与GPT-5展现出激烈竞争态势,互有胜负;而V3.2-Speciale则凭借卓越表现,在MMLU、HumanEval等权威基准测试中与Gemini3Pro实现平分秋色,并在IMO2025盲测中斩获金牌分数线83.3%,充分彰显其强大的综合能力。

V3.2系列的核心突破在于转正稀疏注意力(DSA)技术的创新升级。通过引入”目录式路由token”机制,该技术成功将长文本计算复杂度从传统的O(n²)降至线性O(n),这一革命性改进不仅显著降低了显存占用(降幅达40%),更将推理速度提升了惊人的2.2倍。尤为值得称道的是,DeepSeek团队首次在开源模型中实现了百万token级别的单卡推理能力,为长文本处理领域树立了新的里程碑。

在后训练环节,DeepSeek团队展现出对模型持续优化的执着追求。他们投入超过10%的整群算力用于强化学习训练,创新性地采用组对强化学习(GRPO)结合多数投票机制,使模型在代码生成、数学推理及工具调用等关键任务上,性能已逼近商业闭源对手水平,为开源社区树立了新的标杆。

V3.2-Speciale版本在推理策略上进行了大胆创新,取消了”思考长度惩罚”机制,鼓励更长的链式推理过程。实测数据显示,该版本平均输出token数量较Gemini3Pro高出32%,同时准确率提升了4.8个百分点,充分证明了更充分推理对模型能力提升的积极作用。

目前,V3.2系列模型已全面上线GitHub与Hugging Face平台,权重文件采用Apache2.0开源协议,为商业应用提供了充分支持。DeepSeek团队表示,下一步将重点开源长文本DSA内核与RL训练框架,致力于将”闭源优势”转化为社区共享的基础设施资源,推动整个开源生态的发展。

行业专家普遍认为,若DeepSeek能够保持当前迭代节奏,开源阵营有望在2026年前率先实现”长文本处理+推理能力”的双重领先,这一突破将深刻改变人工智能领域的技术格局。