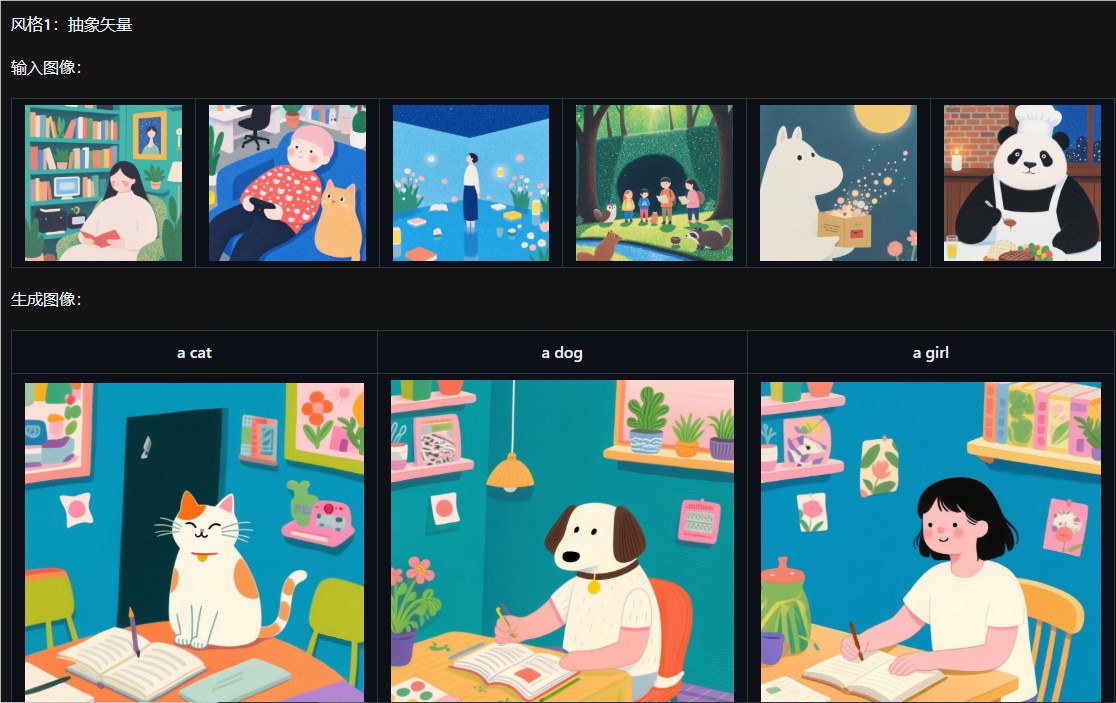

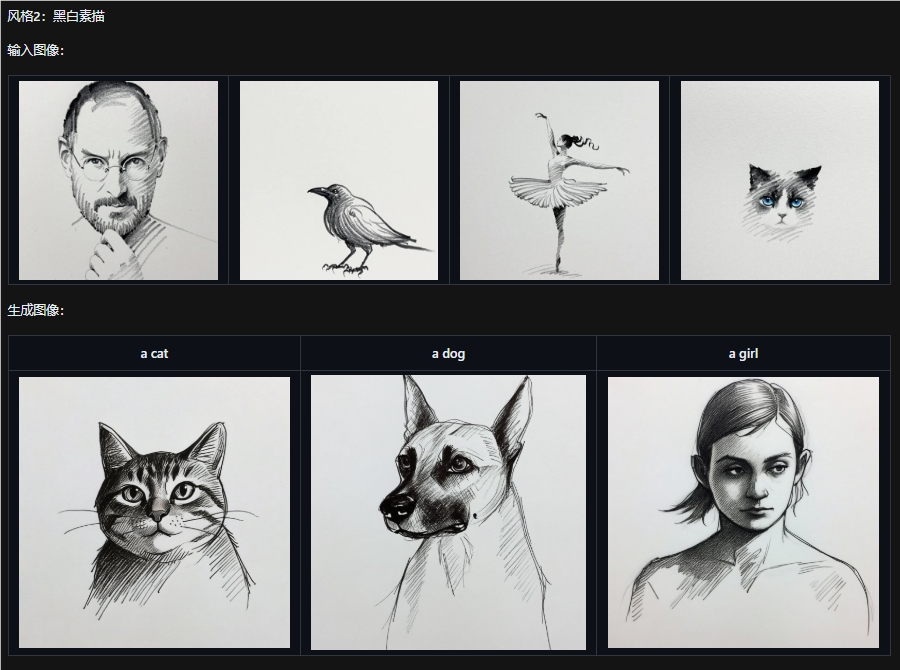

在AI图像生成领域,一项颠覆性的技术创新横空出世:Qwen-Image-i2L。这款由阿里通义实验室倾力打造的开源工具,能够将任意一张静态图片转化为可微调的LoRA(Low-Rank Adaptation)模型,极大地降低了个性化风格迁移的技术门槛。无需依赖庞大的数据集或昂贵的计算资源,用户只需上传一张图片,即可快速生成轻量级的LoRA模块,并能无缝集成到其他生成模型中,实现高效的“单图风格迁移”。这一突破性进展迅速在AI社区引发热烈讨论,被誉为“AI艺术生产的终极飞跃”。

核心创新:从单图到LoRA,一键解锁个性化生成

Qwen-Image-i2L的核心突破在于其独特的图像分解机制。它融合了SigLIP2、DINOv3和Qwen-VL等多模态特征提取体系,能够智能地将输入图片拆解为“风格、内容、构图、色调”等核心视觉元素。这些可学习特征随后被高效压缩,形成一个体积小巧的LoRA模块——平均仅需数GB空间,却能精准捕捉图片的精髓。不妨想象一下:你提供一张印象派油画,系统自动提取其柔和笔触和暖色调;或上传一位艺术家的肖像,瞬间生成具有鲜明个人风格的LoRA模块。生成的模块可直接加载到Stable Diffusion或其他扩散模型中,用于后续的图像生成任务。这不仅简化了传统训练流程(以往需要20多张图片和GPU集群),更实现了“一键学习”,让AI艺术创作从专业领域迈向大众娱乐。社区反馈显示,这一功能特别适用于快速原型设计和风格实验。开源发布后,开发者已开始探索其在产品可视化和数字艺术中的应用,预计将加速AI工具的商业化进程。

四款模型变体,精准适配多元场景

为满足不同用户的需求,Qwen-Image-i2L提供了四种专属“模型风格”,每个变体针对特定用途进行了优化:

– 风格模式(2.4B参数):专注纯美学提取,理想用于艺术画风迁移,例如将水彩风格注入新图像。

– 粗粒度模式(7.9B参数):综合捕捉内容与风格,适合整体场景重构,例如建筑或景观的快速变体生成。

– 精细模式(7.6B参数):支持1024×1024高分辨率细节增强,常与粗粒度模式搭配,提升纹理和边缘精度。

– 偏见模式(30M参数):确保输出与Qwen-Image原生风格一致,避免偏差,适用于需要品牌统一性的企业级应用。

这些变体均基于Apache2.0许可开源,用户可在Hugging Face或ModelScope平台免费下载。测试显示,在复杂文本渲染和语义编辑基准上,Qwen-Image-i2L超越多数开源竞品,与闭源模型不相上下。

技术底蕴与潜在挑战:高效却需警惕过拟合

Qwen-Image-i2L的强大源于其多模态基础模型Qwen-Image(20B参数MMDiT架构),该模型已在GenEval、DPG等基准中表现卓越,尤其在中英双语文本渲染上领先行业。结合FlowMatchEuler调度器,它支持高效推理,平均生成时间缩短至数秒。然而,正如社区讨论所指出的,这一“单图学习”虽具有革命性,但也面临挑战:从单一2D图像提炼复杂3D逻辑可能导致过拟合,输出在多样化场景中的稳定性有待优化。开发者建议结合多步蒸馏或辅助数据集,进一步提升鲁棒性。

展望未来:AI个性化时代的加速器

Qwen-Image-i2L的问世标志着AI图像工具从“通用生成”向“即时定制”的转型。它不仅赋能创作者,还为电商、游戏和影视行业注入新活力。未来,随着生态扩展,这一工具或将催生更多“一键创新”应用,推动开源AI向更普惠方向演进。模型下载地址:https://modelscope.cn/models/DiffSynth-Studio/Qwen-Image-i2L/summary