Mistral AI 近期发布了其创新性 Voxtral 模型系列,这一突破性成果专为融合文本与音频处理技术而设计,旨在为各类应用场景提供强大的支持。Voxtral 系列精心打造了两个核心模型:Voxtral-Mini-3B-2507 和 Voxtral-Small-24B-2507。前者是一款经过优化的3亿参数模型,特别适用于快速音频转录和基础多模态理解任务;而后者则拥有高达240亿参数,能够支持更为复杂的音频文本智能处理和多语言应用,是构建企业级解决方案的理想选择。

这两个模型均具备出色的音频处理能力,支持长达30至40分钟的音频上下文输入,并内置自动语言检测功能,可高效处理多达32,000个标记。它们在 Apache2.0许可证下公开发布,既适用于商业项目也支持学术研究,展现出卓越的多模态智能处理性能。这些模型能够在单一流程中无缝整合口头与书面交流,为用户带来前所未有的便捷体验。

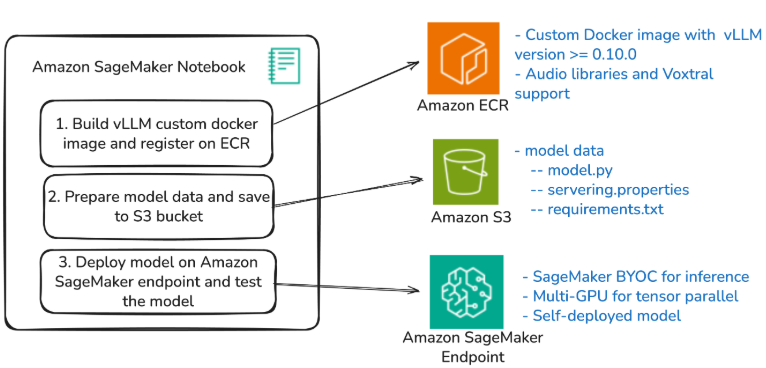

在技术实现层面,本文将详细介绍如何借助 vLLM 高性能库和“自带容器(BYOC)”方案,在亚马逊 SageMaker AI 端点上成功部署 Voxtral 模型。vLLM 作为一款创新性库,能够显著提升大规模语言模型的内存管理效率,并支持跨多个GPU的张量并行处理,为模型运行提供强大动力。SageMaker 的 BYOC 功能则赋予用户高度灵活性,允许使用自定义容器镜像进行部署,从而在模型优化和版本控制方面实现更精细化管理。

整个部署流程以 SageMaker 笔记本环境为核心控制枢纽,负责构建并推送自定义Docker镜像至亚马逊弹性容器注册中心(ECR),同时精准管理模型配置和部署工作流。此外,亚马逊 S3 云存储服务承担着存储Voxtral实施所需关键文件的重要职责,实现了配置与容器镜像的模块化分离,进一步提升了系统的可维护性和扩展性。

这一解决方案覆盖了广泛的应用场景,包括传统仅文本处理的对话AI系统、高精度音频文件转录服务,以及融合音频和文本智能的复杂多模态应用。用户只需通过简单的配置调整,即可在 Voxtral-Mini 和 Voxtral-Small 模型之间实现无缝切换,充分满足不同场景下的性能需求。通过实现这些先进的多模态功能,Voxtral 模型系列将为您带来更加灵活高效的音频和文本处理服务体验。

划重点:📌 Voxtral 模型创新性地结合文本和音频处理技术,为多样化应用场景提供强大支持。 🔧 亚马逊 SageMaker 提供自定义容器部署方案,显著提升模型部署的灵活性。 💡 覆盖多种应用场景,包括文本处理、音频转录及复杂多模态智能应用。