大模型微调正迎来前所未有的普及浪潮,从过去仅供专业实验室使用的“高门槛技术”,迅速转变为“人人可及”的开发利器。近日,英伟达重磅发布了面向初学者的LLM微调官方指南,为开发者提供了一套系统性的解决方案,详细阐述了如何在GeForce RTX笔记本到DGX Spark工作站的全系列NVIDIA硬件上,借助开源框架Unsloth高效完成模型定制。这一举措不仅显著降低了技术门槛,更通过卓越的性能优化,让普通开发者也能在消费级设备上轻松实现专业级的微调效果。

Unsloth:专为NVIDIA GPU量身打造的微调加速器

Unsloth是一个深度优化LLM训练全流程的开源框架,其核心优势在于与CUDA和Tensor Core架构的深度适配。相较于标准Hugging Face Transformers实现,Unsloth在RTX系列GPU上的训练速度提升了惊人的2.5倍,同时显存占用大幅降低。这一突破性性能意味着,即便是一台配备RTX4090的笔记本电脑,也能胜任过去需要多张高端显卡组成的复杂服务器才能完成的微调任务。

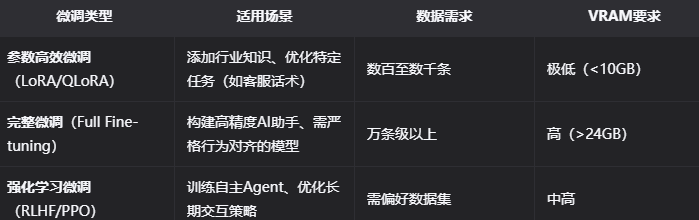

三大微调模式全覆盖,满足不同场景的灵活需求

英伟达的官方指南特别贴心地对比了三种主流微调方法,包括LoRA、QLoRA和Full Fine-Tuning,帮助开发者根据实际需求“对症下药”。无论是学生个人项目还是企业级应用,都能找到最合适的微调策略。这种全面覆盖的解决方案,使得LLM微调真正实现了“从小处着手”的理念:用户可以先从QLoRA在RTX3060上微调7B模型开始,逐步积累经验,再扩展到更大规模的模型训练。

从学生到企业,全民微调时代已经来临

该指南特别强调“循序渐进”的学习路径,为不同水平的开发者提供了清晰的进阶路线。英伟达还贴心地提供了Docker镜像和Colab示例代码,实现了“开箱即用”的便捷体验。AIbase分析认为,英伟达的这一举措不仅是技术布道的善举,更是一项深远的生态战略——通过大幅降低微调门槛,进一步巩固了CUDA在AI开发领域的领导地位。当Unsloth让一张消费级显卡的效能逼近专业级工作站,开源社区必将迎来爆发式的创新浪潮。

这场由英伟达推动的“微调民主化”运动,正加速推动大模型从“通用智能”向“千人千面”的个性化智能时代迈进。随着技术门槛的降低和开发工具的普及,每个人都能参与到这场AI革命的浪潮中,共同塑造更加智能化的未来。