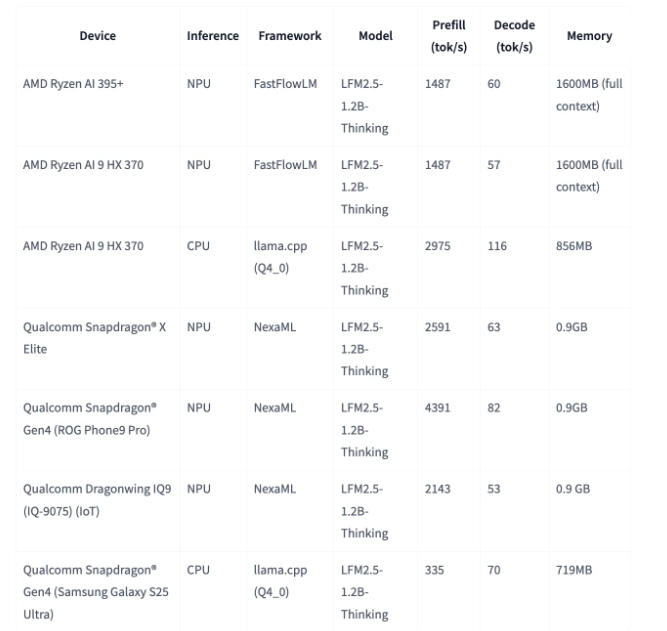

Liquid AI 近期宣布推出其备受期待的 Liquid 基础模型系列最新力作——LFM2.5-1.2B-Thinking。这款拥有12亿参数的推理模型在端侧设备部署方面实现了革命性突破,为移动智能应用开辟了全新可能。令人惊叹的是,该模型在现代智能手机上的运行内存占用仅为900MB,这意味着两年前仍需依赖数据中心才能实现的复杂推理能力,如今已能完全离线运行在个人移动设备上,彻底改变了AI应用的部署边界。

与专注于日常对话交互的通用模型不同,LFM2.5-1.2B-Thinking 专为解决复杂逻辑推理、数学运算及工具调用等高阶任务而设计。其独特之处在于采用了创新的”思考痕迹”机制,在生成最终答案前会先构建类似人类解题过程的内部推理路径。这种模拟人类思维过程的架构设计,能够有效规划解题步骤并验证中间结果,显著提升了多步骤指令的处理准确性和复杂任务的解决能力。

在实际性能表现上,该模型展现了惊人的效率优势。在AMD CPU平台上,其解码速度可达到每秒239个字符,而在移动NPU上的运行速度也达到了每秒82个字符的优异表现。通过引入多阶段强化学习(RLVR)等先进训练技术,研发团队成功将推理模型中常见的”循环死机”率从15.74% 降低至0.36%,这一突破性成果确保了端侧用户体验的极致流畅与稳定,为移动AI应用提供了前所未有的可靠性保障。