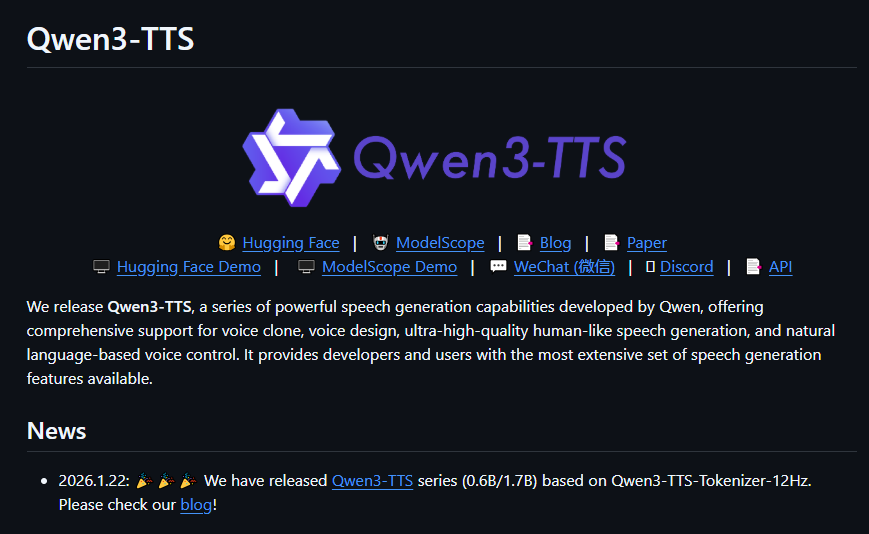

阿里通义千问团队昨晚震撼发布了Qwen3-TTS系列语音生成模型家族的开源成果,这一突破性进展迅速点燃了开源社区的热情,被业界誉为语音合成技术的里程碑式创新。该系列模型采用先进的端到端架构,实现了秒级音色克隆、自然语言驱动的音色设计以及实时流式音频输出,为实时语音应用扫清了技术障碍。

Dual-Track双轨架构突破延迟极限Qwen3-TTS的核心突破在于其独创的Dual-Track双轨混合流式生成机制,通过整合离散多码本语言模型,实现了真正的端到端语音建模,彻底摆脱了传统级联架构(如LM+DiT)造成的性能瓶颈。实测数据显示,该模型的端到端延迟低至惊人的97毫秒,只需输入单个汉字即可触发首包音频输出。这种极致的响应速度,使其成为直播互动、实时翻译、AI智能客服等时延敏感场景的理想选择。

3秒极速克隆 + 跨语言方言无损迁移语音克隆能力令人叹为观止:仅需3秒钟的参考音频,即可完成高保真度的零样本音色复刻。更令人惊叹的是,克隆后的音色能够实现跨语种无缝迁移,中文音色可直接用于演绎英语、日语、韩语、德语、法语、俄语、西班牙语、葡萄牙语、意大利语等10种主流语言,且原音色特征保持完整。此外,模型还能自然输出四川话、北京话等多种中文方言,口音和神韵高度还原,为多语言内容创作和本地化应用开辟了无限可能。

自然语言指令”凭空”创造专属音色除了克隆功能,Qwen3-TTS还具备强大的Voice Design音色设计能力。用户只需通过自然语言指令,即可自定义理想的声音效果,例如”用温柔鼓励的成熟女声讲述故事”或”高亢兴奋的年轻男性解说游戏”,模型将自动调整语调、情感和节奏,生成高度个性化的语音表达。这种”所想即所听”的控制能力,在有声书制作领域展现出巨大价值——单人即可分饰多角,完美驾驭情绪起伏和方言切换,显著提升沉浸感和生产效率。

1.7B与0.6B双参数版本灵活适配不同需求Qwen3-TTS家族提供两种参数规模的选择:- 1.7B模型:性能卓越,控制能力突出,特别适合对音质和表现力要求严苛的云端应用场景;- 0.6B模型:在保持出色合成质量的同时,实现了更优的推理效率和更低的资源占用,完美适配边缘设备或高并发部署需求。官方已将完整系列(包括Base、VoiceDesign、CustomVoice等)全面开源至GitHub和Hugging Face平台,支持全参数微调,开发者可轻松打造品牌专属语音形象。

随着Qwen3-TTS的开源,实时化、个性化、多语言语音AI的门槛被大幅降低。无论是内容创作者、技术开发者还是企业级应用开发者,都将迎来语音交互技术的全新革命浪潮。项目地址:https://github.com/QwenLM/Qwen3-TTS