长期以来,尽管相机为机器装上了“眼睛”,但如何让它们像人类一样理解这个动态的世界——不仅看清当下,还能感知过去并预见未来——一直是计算机视觉领域的终极难题。就在今天,

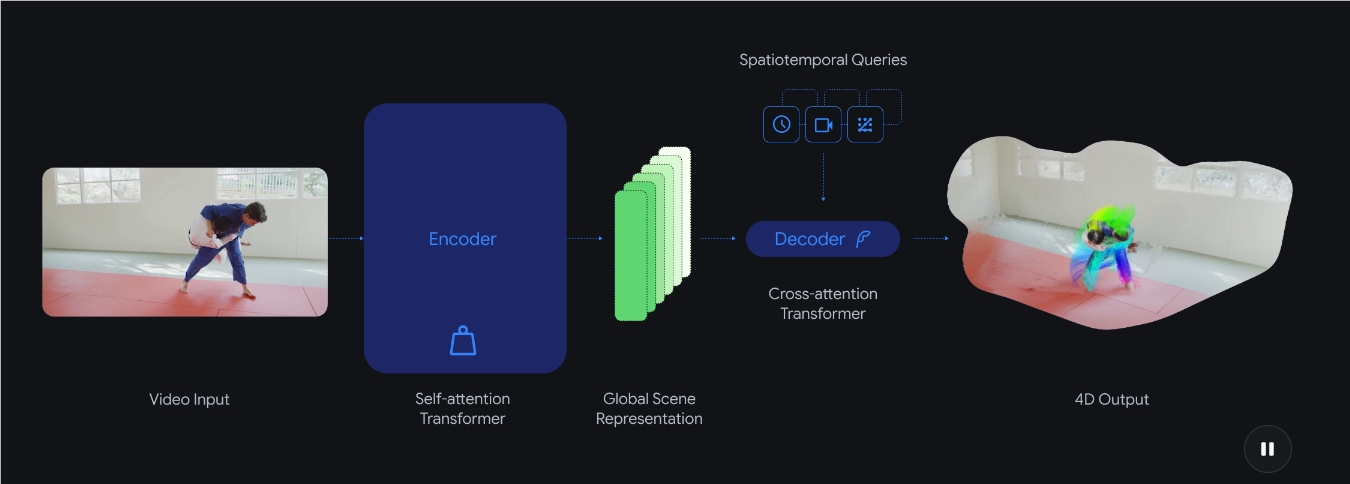

D4RT 的出现,标志着机器视觉从“拼图模式”向“整体建模”的史诗级跃迁。以往,要让 AI 从一段扁平的2D 视频中还原出立体的动态世界,往往需要像打补丁一样堆叠多个模型:有的负责算深度,有的负责盯动作,有的负责测相机视角。这种方式不仅臃肿迟缓,更让 AI 的认知变得支离破碎。而 D4RT 采用了一种优雅的“查询式”架构,将这些复杂任务简化为一个核心问题:“视频中的某个像素,在某个特定时间点,从某个特定镜头看过去,到底位于三维空间的哪个坐标?”

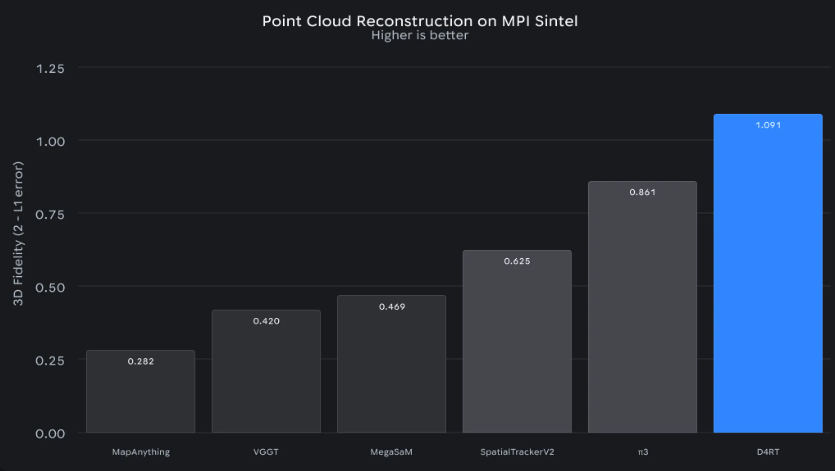

这种“指哪打哪”的聪明打法,让 D4RT 展现出了令人惊叹的效率。在性能测试中,它的运行速度比此前的技术标杆快了18到300倍。一段一分钟长的视频,曾经需要顶级算力死磕十分钟才能解析完成,而 D4RT 仅需短短5秒钟即可搞定。这意味着,AI 第一次拥有了在现实场景中实时构建四维地图的潜力。

除了速度上的碾压,D4RT 在视觉理解的深度上也完成了一次自我超越:

-

全时空像素追踪:即便一个物体移动到了镜头外或被暂时遮挡,D4RT 依然能凭借其强大的内部世界模型,预测出它在三维时空中的运动轨迹。

-

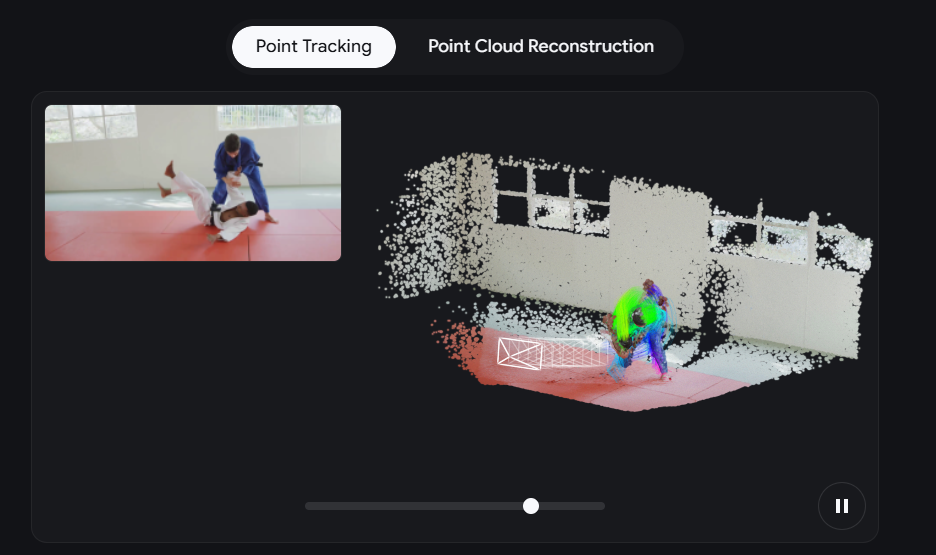

瞬时云端重建:它可以像凝固时间一般,直接生成整个场景的精准3D 结构,无需反复的迭代优化。

-

自适应镜头捕获:通过对不同视角快照的自动对齐,它能精准还原相机本身的运动路径。

从机器人的灵活避障,到增强现实(AR)眼镜的低延迟贴合,再到构建真正具备物理常识的“通用人工智能”,D4RT 为我们描绘了一个 AI 能够真实感知的未来。这不再仅仅是关于算法的更新,而是关于如何让数字灵魂真正看懂我们所处的这个流动的、四维的现实世界。

你想进一步了解 D4RT 在机器人导航或 AR 领域的具体落地细节吗?我可以为你展示更多

详情:https://deepmind.google/blog/d4rt-teaching-ai-to-see-the-world-in-four-dimensions/