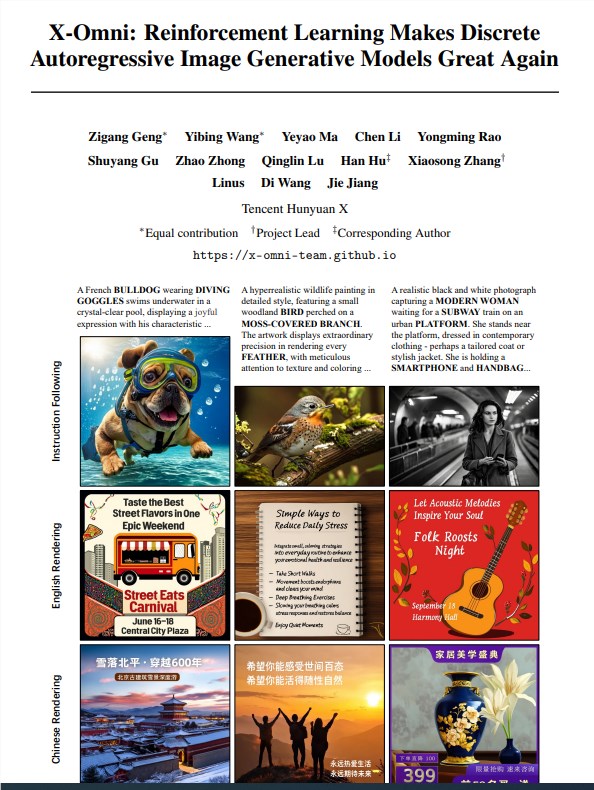

腾讯研究团队近日重磅发布了全新多模态AI模型X-Omni,该模型在图像生成与理解领域取得了革命性突破,尤其在长文本渲染方面展现出卓越性能,成功解决了传统AI模型在图片文字生成中的精度难题。长期以来,AI图像生成模型在处理文字渲染时始终面临严峻挑战。传统离散自回归模型通过逐个生成像素或代币的方式构建图像,这种逐级累积的生成方式极易导致误差叠加,最终表现为拼写错误、字符缺失或扭曲变形等问题。为应对这一瓶颈,众多研究团队开始转向扩散模型或混合架构,认为单纯的自回归方法难以胜任高质量的文字渲染任务。

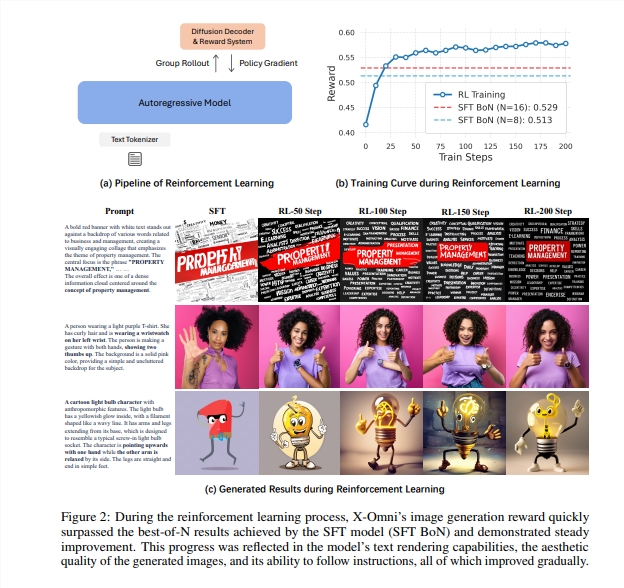

X-Omni创新性地采用了强化学习框架来优化模型性能。该系统精心构建了多维度的奖励机制,包括美学质量评估器HPSv2、综合奖励模型Unified Reward、视觉语言理解模型Qwen2.5-VL-32B,以及专门研发的文字识别评估工具GOT-OCR2.0和PaddleOCR。这些组件协同运作,在模型生成过程中实时提供反馈与指导,显著提升了输出质量的稳定性和准确性。X-Omni的核心创新在于实现了图像生成与理解功能的统一建模。传统方法通常将这两项任务割裂处理,需要不同的模型架构和训练策略,而X-Omni通过采用语义图像分词器SigLIP-VQ,将视觉信息转化为语言模型可处理的语义代币,使得同一个模型既能生成高质量图像,又能精准理解图像内容。

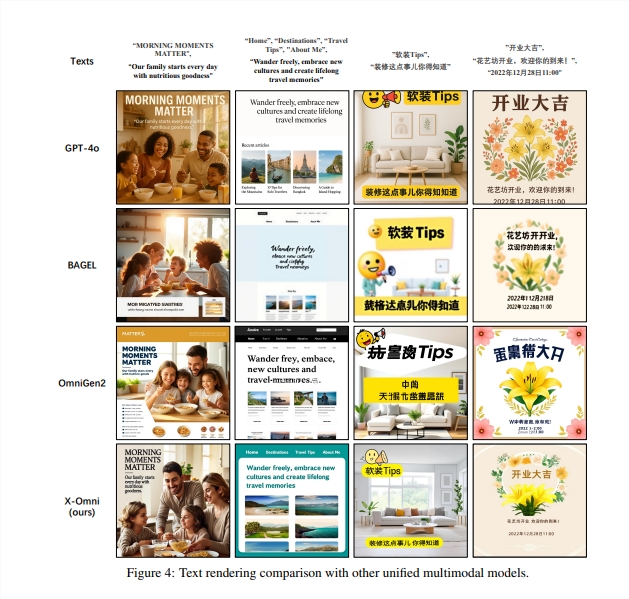

在性能测试方面,X-Omni展现出全面领先的优异表现。在文字渲染任务中,该模型无论处理英文还是中文文本都能保持高准确率,特别是在长文本渲染方面超越了包括GPT-4o在内的多个主流模型。在文本到图像生成任务中,X-Omni能够精确遵循复杂指令,生成符合要求的高质量图像。同时,在图像理解任务上,该模型在OCRBench等专业测试中的表现也超过了LLaVA-One Vision等专门的视觉理解模型。尤为值得注意的是,X-Omni在不依赖分类器自由引导技术的情况下仍能维持高质量的生成效果。分类器自由引导虽能提高模型对指令的遵循度,但会增加计算开销。X-Omni无需这种外部辅助机制就能实现优秀性能,充分证明其内部的视觉和语言模块已经实现了高度协调统一。

从技术架构角度来看,X-Omni的成功验证了离散自回归模型在多模态任务中的巨大潜力。通过引入强化学习的优化机制和统一的语义表示方法,该模型成功克服了传统自回归方法的局限性,为多模态AI的发展开辟了新的技术路径。X-Omni的发布标志着AI在图像生成和理解领域迈入了新的发展阶段。该模型不仅在技术指标上实现突破,更重要的是验证了统一多模态建模的可行性,为构建更加智能和高效的AI系统奠定了坚实基础。随着这类技术的持续完善,用户将能够通过自然语言更便捷地创建包含复杂文字内容的视觉作品,AI辅助内容创作的效率和质量都将得到显著提升。论文地址:https://arxiv.org/pdf/2507.22058