开源社区近日迎来了一项重大突破——全新多模态模型LLaVA-OneVision-1.5的问世,标志着人工智能在视觉与语言融合领域迈出了关键性步伐。经过两年持续研发,LLaVA(大型语言与视觉助手)系列模型实现了从基础图文对齐到综合性多模态框架的跨越式发展。作为该系列的最新成果,LLaVA-OneVision-1.5以开放性、高效性和可复现性为核心设计理念,为开发者构建高性能视觉语言模型提供了强大工具。

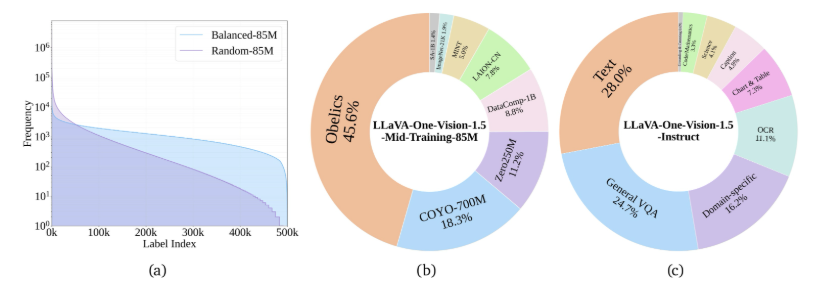

该模型的训练体系经过精心设计,分为三个核心阶段协同推进。第一阶段通过语言-图像对齐预训练,实现视觉特征向语言词嵌入的精准转化。第二阶段”高质量知识学习”尤为关键,模型在8500万海量训练样本上进行全参数深度训练,通过注入丰富视觉信息与专业知识显著增强模型认知能力。第三阶段采用视觉指令微调技术,借助定制化数据集使模型能够灵活应对各类复杂视觉任务。这种分层训练策略确保了模型在保持广泛适应性的同时,又能针对特定场景进行高效优化。

在训练效率方面,团队创新性地采用了离线并行数据打包技术,将数据处理压缩比提升至惊人的11倍。基于8500万样本的训练过程仅需3.7天即可完成,大幅缩短了模型开发周期。技术架构上,LLaVA-OneVision-1.5选用先进的RICE-ViT视觉编码器,其区域感知机制特别适合处理文档类图像中的文字信息,实现了对视觉内容的深度理解与分析。

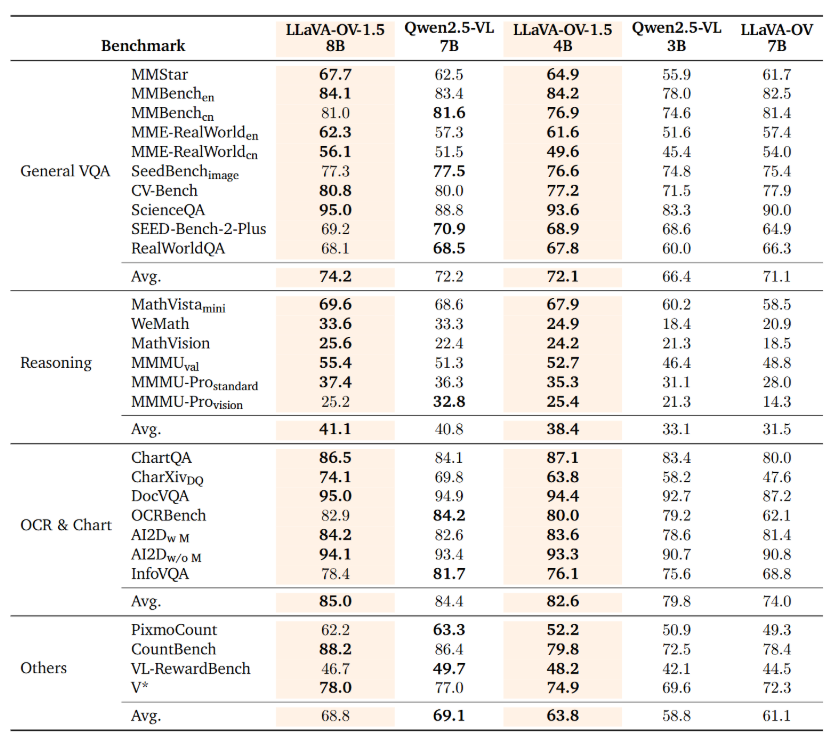

数据质量是模型性能的基石。LLaVA-OneVision-1.5的预训练数据集涵盖广泛场景,并创新性地引入”概念均衡”采样策略,确保模型在各类任务中保持均衡表现。这种数据治理方式有效避免了模型偏向特定类型样本的常见问题。在权威基准测试中,该模型展现出卓越性能,其80亿参数版本在27项测试中全面超越Qwen2.5-VL,充分验证了其技术领先性。

项目资源已开放至以下平台供开发者获取:

https://github.com/EvolvingLMMs-Lab/LLaVA-OneVision-1.5

https://huggingface.co/lmms-lab/LLaVA-OneVision-1.5-8B-Instruct

LLaVA-OneVision-1.5的核心优势可概括为三大亮点:

🌟 作为最新开源多模态模型,具备处理图像、视频等多种输入形式的强大能力

📈 三阶段训练体系科学高效,显著提升模型视觉与语言理解性能

🏆 权威基准测试表现优异,80亿参数版本全面超越Qwen2.5-VL模型