上海人工智能实验室联合浙江大学等顶尖机构近日重磅发布IWR-Bench,这是全球首个专门针对大语言模型视频转网页代码能力的基准测试平台。该基准填补了AI前端开发领域动态交互评测的关键空白,旨在更真实地衡量多模态大语言模型(LVLM)在动态网页重建方面的综合能力。

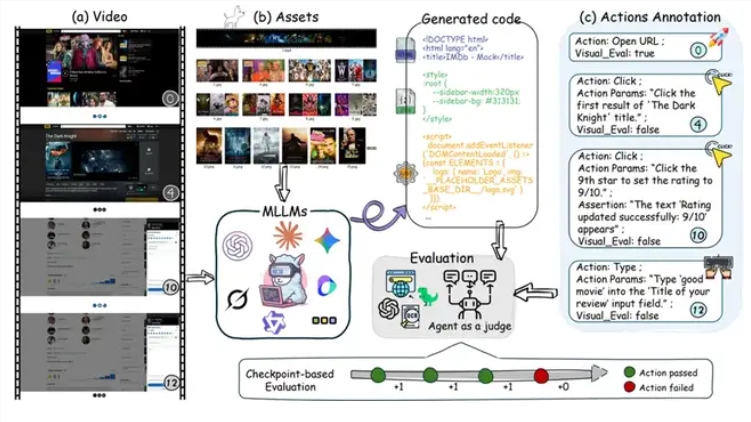

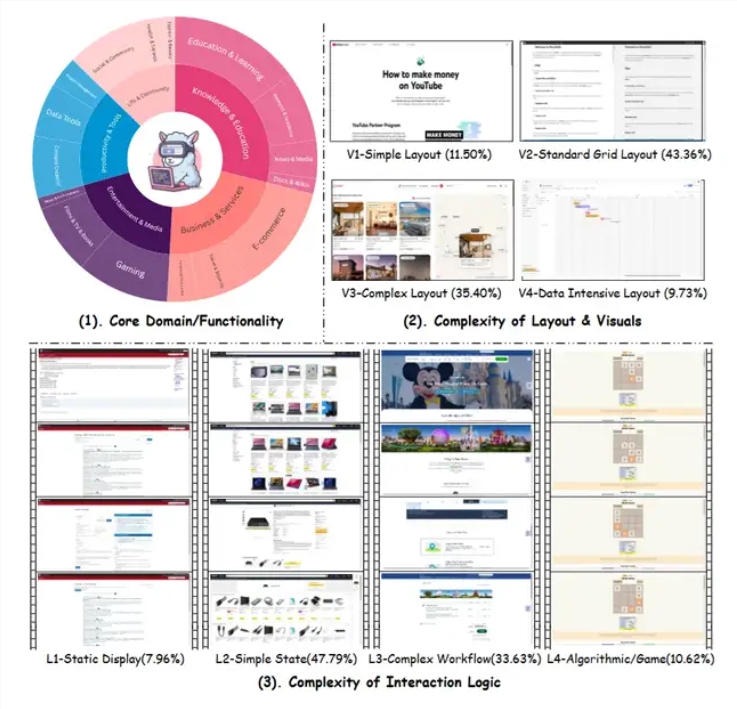

与传统的图像转代码(Image-to-Code)任务截然不同,IWR-Bench要求模型通过观看完整记录用户操作流程的视频,结合网页所需的全部静态资源,精准重建网页的动态交互行为。测试任务覆盖了从基础网页浏览到复杂游戏规则重建的广泛场景,包括经典的2048游戏、机票预订系统等多样化应用。初步评测结果显示,当前AI模型在这一前沿任务上仍面临显著挑战。

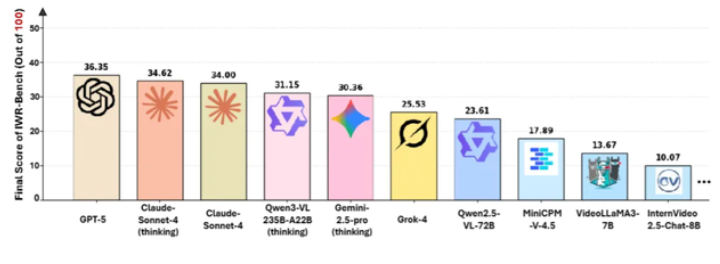

在涵盖28个主流模型的全面评测中,表现最佳的GPT-5综合得分仅为36.35分,其中交互功能正确性(IFS)得分为24.39%,视觉保真度(VFS)得分为64.25%。这一数据直观表明,尽管模型在视觉还原方面表现相对较好,但在实现事件驱动逻辑和动态交互功能方面存在明显短板。值得注意的是,带有”思考”机制的模型版本在某些任务中表现有所提升,但整体增幅有限,印证了基础模型能力的关键决定性作用。

从评测方法设计来看,IWR-Bench采用创新的双维评估体系,既关注模型的视觉还原能力,又通过自动化代理精准验证其交互功能的正确性。每个测试任务均提供完整的静态资源,且所有文件名经过严格匿名化处理,迫使模型必须依赖视觉匹配而非语义推理来关联资源。这种设计更贴近真实开发场景,要求模型深入理解操作视频中的因果关系和状态变化,并高效转化为可执行的代码逻辑。

研究人员还发现了一些值得关注的趋势。专门针对视频理解优化的模型在该任务中的表现反而不及通用多模态模型,这一现象揭示了视频转网页任务与传统视频理解任务存在本质差异——前者不仅需要理解视频内容,更关键的是将动态行为抽象为程序逻辑。

从技术挑战维度分析,视频转网页任务涉及多个层面的复杂难题。首先是时序理解能力,模型需从连续视频帧中精准提取关键交互事件和状态转换;其次是逻辑抽象能力,需将观察到的行为模式转化为事件监听、状态管理等编程概念;第三是资源匹配精度,在匿名化静态资源中准确定位对应图片、样式等文件;第四是代码生成质量,需产出结构合理、逻辑正确的HTML、CSS和JavaScript代码。GPT-5仅获得36.35分的综合得分,表明即便是当前最先进的多模态模型,在将动态行为转化为可执行代码这一核心任务上仍存在巨大提升空间。

24.39%的交互功能正确率意味着模型生成的网页中,超过四分之三的交互功能存在问题,具体可能包括事件响应不正确、状态管理错误、业务逻辑遗漏等严重缺陷。这一评测结果为AI前端开发领域提供了宝贵的参考数据。

IWR-Bench的推出对AI研究和应用具有里程碑意义。从研究角度,它为多模态模型的动态理解和代码生成能力提供了全新评测维度,有助于精准定位当前技术的薄弱环节。从应用角度,若视频转网页能力成熟,将能大幅降低前端开发门槛,使非技术人员通过简单演示操作即可生成功能原型,开启智能化网页开发新纪元。

需要强调的是,即使模型在IWR-Bench上取得高分,距离实际应用仍存在距离。真实网页开发涉及性能优化、兼容性处理、安全防护、可维护性等多维度复杂要求,这些难以通过视频演示完全传达。此外,复杂的业务逻辑、边缘情况处理和用户体验细节,也难以仅从操作视频中全面推断。

从行业发展趋势来看,IWR-Bench代表了AI代码生成从静态向动态、从单帧向多帧、从描述向演示的演进方向。这与当前AI编码助手主要依赖文本描述的模式形成鲜明对比,为”所见即所得”的智能开发工具奠定了坚实技术基础。若未来模型在该任务上取得重大突破,可能催生新一代原型开发工具,让产品经理或设计师通过录制操作视频就能生成可交互的网页原型。

测试结果表明,当前AI模型在理解复杂动态交互方面仍处于早期阶段。64.25%的视觉保真度相对较高,说明模型已具备较好还原页面静态外观的能力;但24.39%的交互功能正确率表明,将观察到的行为转化为正确的程序逻辑仍是巨大挑战。这种差距深刻反映了AI在”看懂”和”做对”之间存在明显鸿沟——能识别视觉元素不等于能理解背后的交互逻辑。

IWR-Bench的意义不仅在于提供了一个评测工具,更在于明确了AI多模态能力发展的关键方向。随着该基准的广泛推广,可以预期将有更多研究聚焦于动态行为理解、时序推理和代码生成的深度融合,推动多模态大模型在实际开发场景中的应用价值实现新突破。