在大语言模型技术浪潮的推动下,蚂蚁技术研究院近日重磅发布了LLaDA2.0系列模型,这一创新成果标志着业内首个参数规模突破百亿级别的离散扩散大语言模型(dLLM)的诞生。该系列模型不仅成功突破了传统扩散模型难以实现规模化扩展的技术瓶颈,更在生成质量与推理速度上实现了质的飞跃,为大语言模型领域注入了全新的活力与方向。LLaDA2.0系列精心设计了两种版本:16B(mini)和100B(flash),其中100B版本作为目前规模最大的扩散语言模型,在复杂代码生成和指令执行等高要求任务中展现出无与伦比的性能优势。

蚂蚁集团表示,LLaDA2.0系列的核心突破在于采用了全新的Warmup-Stable-Decay(WSD)预训练策略,这一创新机制实现了自回归(AR)模型知识的无缝继承,有效规避了从零开始训练所带来的高昂成本与时间消耗。从技术细节来看,LLaDA2.0系列充分彰显了并行解码的强大优势,其推理速度高达535tokens/s,较同级别AR模型实现了2.1倍的显著提升。这一卓越性能的取得,主要归功于模型在推理过程中对KV Cache的高效复用以及块级并行解码技术的创新应用。此外,蚂蚁集团在后训练阶段还引入了互补掩码和置信度感知并行训练(CAP)等先进技术,进一步提升了模型的数据处理效率与推理速度。

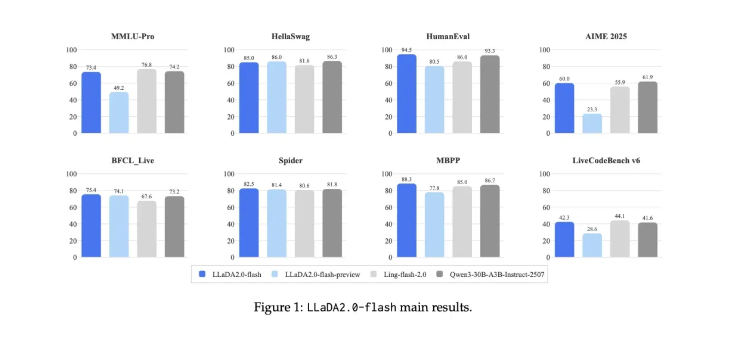

在多项权威评测维度中,LLaDA2.0系列均表现出色,特别是在结构化生成任务如代码生成领域,其展现出的全局规划能力远超同类模型。在涉及复杂智能体调用和长文本处理的任务中,LLaDA2.0同样表现卓越,充分证明了其在多样化应用场景中的强大适应能力与通用性。蚂蚁集团的此次发布不仅标志着离散扩散技术在理论突破与实践应用上达到了新的里程碑,更向业界展示了扩散模型在超大规模应用场景下的巨大潜力与显著优势。

展望未来,蚂蚁集团将继续深耕扩散模型的研究与开发,计划进一步扩大模型参数规模,深入探索强化学习与思考范式的融合应用,并致力于推动生成式人工智能技术的持续进步与创新。更多详情请访问:https://huggingface.co/collections/inclusionAI/llada-20